什麼是谷歌的 LaMDA AI,為什麼谷歌工程師相信它是有感知的?

已發表: 2022-06-29

谷歌的一位高級工程師聲稱該公司的 LaMDA AI 已經變得有感知力。 無論您覺得這令人震驚還是令人興奮,這都是一個非常大膽的主張,即使它完全正確,也可能很難證明。

什麼是 LaMDA?

LaMDA 是Language Model for Dialog Application的縮寫。 換句話說,它是一種專門用於生成自然對話的機器學習語言模型。 機器學習方法允許計算機發現數據中的模式和關係。 因此,例如,您可以在莎士比亞的所有作品上“訓練”機器學習算法,例如 GPT-3(另一個尖端系統),然後讓它生成讀起來像莎士比亞的新原文。

正如 Sundar Pichai(Google 的 CEO)在接受 Yahoo Finance 採訪時所解釋的那樣,LaMDA 是一個與眾不同的系統,因為它專門針對對話進行了培訓。 其目的是讓谷歌的系統能夠與用戶進行類似人類的開放式對話。

換句話說,人們向 Google 產品詢問特定的東西不必改變他們的想法或說話方式。 他們可以像與另一個人互動一樣與計算機系統互動。

在底層,所有當前的機器學習模型實際上都是複雜的數學和統計模型。 他們根據在數據中發現的基本模式生成算法。 為他們提供足夠的高質量數據,這些算法在做迄今為止只有人類或其他自然智能能夠做的事情上變得非常有效。

為什麼 Google 工程師相信 LaMDA 是有感覺的?

有問題的工程師是 Blake Lemoine,他發表了他自己和 LaMDA 之間的採訪,作為他為什麼 LaMDA 可能具有感知力的案例的一部分。 Lemoine 花了幾個月的時間與軟件交談,詢問它複雜的問題,並發現很難相信它的複雜和適當的反應可能是除了有情眾生之外的任何東西的產物。

每個想要了解 Lemoine 為什麼會有這種感覺的人最好自己閱讀 LaMDA 的回复,以了解為什麼這是一個如此令人信服的立場。 LaMDA 的反應非常人性化,讓人想起 Spike Jonze 的Her中虛構的個人助理 AI,在這個故事中,人類與對話式 AI 建立了認真的關係。

撇開 Lemoine 關於 LaMDA 的斷言是否有分量,值得注意的是,LaMDA 的整個設計目的是產生自然、可信的開放式對話。 因此,從這個意義上說,他的信念表明谷歌在產生可信對話方面取得了驚人的成功。 如果任何人工智能係統要讓人類相信它是有知覺的,那麼它很可能是專門為此而設計的。

問題在於,由於許多科學和哲學的原因,關於感知的聲明並不是真正可測試的(或者至少不是可行的,或道德上可測試的)。 為了理解為什麼,我們必須簡要地看一下“感覺”是什麼意思。

什麼是感覺?

“感知”這個詞本質上意味著某物(貓、人或魔毯)具有感知能力。 它與“sentimental”或“sentiment”具有相同的詞根。 感知不僅僅意味著某物具有感知能力。 您的恆溫器幾乎可以肯定是沒有感知力的,儘管它能夠判斷溫度。 相反,感覺是關於感覺的主觀體驗,這意味著首先有一個“主體”。

在這裡陷入語義是很危險的,因為 Lemoine 很可能將“sentience”這個詞與“sapience”、“intelligence”和“consciousness”等不同的概念互換使用。 因此,為了爭論,這裡最仁慈的解釋是 Lemoine 認為 Lamda 是一個有自我意識的存在,能夠感受事物,持有信念,並以我們通常歸因於生物的方式體驗事物。

在另一篇文章中,Lemoine 討論了他認為 LaMDA “想要”和“相信”的東西,這支持了他認為“感知”不僅僅意味著其嚴格的字典定義的想法。

我們一開始並不了解知覺和意識

事情是這樣的:我們對感知力、意識、智力以及成為擁有這些屬性的實體意味著什麼知之甚少。 具有諷刺意味的是,機器學習技術最終可能會幫助我們破解一些關於我們的思想及其存在的大腦的謎團。

目前,哲學家和科學家們正在破解意識的“黑匣子”,但它似乎仍然是某種超越其部分總和的結果。 意識似乎是一種“湧現”的東西。 它是一個“幽靈”,由許多不同的神經子系統相互作用產生,其中沒有一個似乎是自己有感知的。

同樣,複雜的人工智能(例如 DALL-E 2 圖像生成系統)由更簡單的機器學習模型組成,這些模型相互饋送以創建最終產品。 由更簡單系統的交互引起的複雜性主題是您在 AI 世界中經常遇到的主題,儘管我們可能對每個子組件的工作方式有很好的了解,但最終結果通常是不可預測的。

我們甚至會識別人工智能中的情感嗎?

如果為了爭論,一個人工智能實際上是真正意義上的有知覺,我們甚至能說出來嗎? LaMDA 旨在模仿和預測人類對話中的模式,因此在觸發人類與類人智能相關的事物時,這套牌真的很複雜。 然而,我們花了很長時間才將非人類靈長類動物和海豚、章魚和大像等動物視為有知覺——儘管從宏觀上看,它們實際上是我們的兄弟姐妹。

有感知力的 AI 可能是如此陌生,以至於我們不知道我們正在看著我們面前的一個。 這是特別有可能的,因為我們不知道感知出現的閾值條件是什麼。 不難想像,數據和 AI 子系統以正確的方式混合在一起的正確組合可能會突然產生具有感知能力的東西,但它可能會被忽視,因為它看起來不像我們能理解的任何東西。

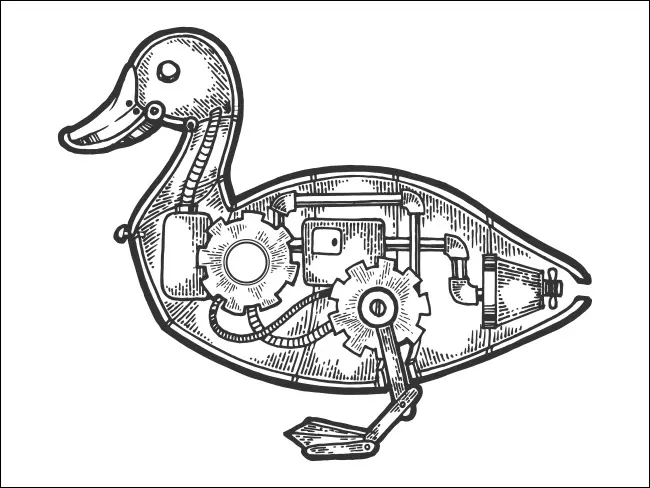

如果它看起來像一隻鴨子……

最後一個關於機器感知力的大問題與其他任何事物(包括人類)的感知力都是同樣的問題。 從哲學上講,您不知道與您互動的任何人是否真的有知覺。 這是經典的哲學殭屍問題,這是一個關於假設的生物的思想實驗,這些生物與人類完全沒有區別,除了它們缺乏感知力或任何類型的意識體驗。

然而,正如艾倫圖靈的著名測試所假設的那樣,人工智能是否“真正”思考和感受並不重要。 重要的是它可以很好地模仿思維和感覺的外觀,以至於我們無法區分。 取決於你問誰,LaMDA 已經通過了圖靈測試,這可能會使 Lemoine 的不可測試的聲明成為一個有爭議的問題。