什么是谷歌的 LaMDA AI,为什么谷歌工程师相信它是有感知的?

已发表: 2022-06-29

谷歌的一位高级工程师声称该公司的 LaMDA AI 已经变得有感知力。 无论您觉得这令人震惊还是令人兴奋,这都是一个非常大胆的主张,即使它完全正确,也可能很难证明。

什么是 LaMDA?

LaMDA 是Language Model for Dialog Application的缩写。 换句话说,它是一种专门用于生成自然对话的机器学习语言模型。 机器学习方法允许计算机发现数据中的模式和关系。 因此,例如,您可以在莎士比亚的所有作品上“训练”机器学习算法,例如 GPT-3(另一个尖端系统),然后让它生成读起来像莎士比亚的新原文。

正如 Sundar Pichai(Google 的 CEO)在接受 Yahoo Finance 采访时所解释的那样,LaMDA 是一个与众不同的系统,因为它专门针对对话进行了培训。 其目的是让谷歌的系统能够与用户进行类似人类的开放式对话。

换句话说,人们向 Google 产品询问特定的东西不必改变他们的想法或说话方式。 他们可以像与另一个人互动一样与计算机系统互动。

在底层,所有当前的机器学习模型实际上都是复杂的数学和统计模型。 他们根据在数据中发现的基本模式生成算法。 为他们提供足够的高质量数据,这些算法在做迄今为止只有人类或其他自然智能能够做的事情上变得非常有效。

为什么 Google 工程师相信 LaMDA 是有感觉的?

有问题的工程师是 Blake Lemoine,他发表了他自己和 LaMDA 之间的采访,作为他为什么 LaMDA 可能具有感知力的案例的一部分。 Lemoine 花了几个月的时间与软件交谈,询问它复杂的问题,并发现很难相信它的复杂和适当的反应可能是除了有情众生之外的任何东西的产物。

每个想要了解 Lemoine 为什么会有这种感觉的人最好自己阅读 LaMDA 的回复,以了解为什么这是一个如此令人信服的立场。 LaMDA 的反应非常人性化,让人想起 Spike Jonze 的Her中虚构的个人助理 AI,在这个故事中,人类与对话式 AI 建立了认真的关系。

撇开 Lemoine 关于 LaMDA 的断言是否有分量,值得注意的是,LaMDA 的整个设计目的是产生自然、可信的开放式对话。 因此,从这个意义上说,他的信念表明谷歌在产生可信对话方面取得了惊人的成功。 如果任何人工智能系统要让人类相信它是有知觉的,那么它很可能是专门为此而设计的。

问题在于,由于许多科学和哲学的原因,关于感知的声明并不是真正可测试的(或者至少不是可行的,或道德上可测试的)。 为了理解为什么,我们必须简要地看一下“感觉”是什么意思。

什么是感觉?

“感知”这个词本质上意味着某物(猫、人或魔毯)具有感知能力。 它与“sentimental”或“sentiment”具有相同的词根。 感知不仅仅意味着某物具有感知能力。 您的恒温器几乎可以肯定是没有感知力的,尽管它能够判断温度。 相反,感觉是关于感觉的主观体验,这意味着首先有一个“主体”。

在这里陷入语义是很危险的,因为 Lemoine 很可能将“sentience”这个词与“sapience”、“intelligence”和“consciousness”等不同的概念互换使用。 因此,为了争论,这里最仁慈的解释是 Lemoine 认为 Lamda 是一个有自我意识的存在,能够感受事物,持有信念,并以我们通常归因于生物的方式体验事物。

在另一篇文章中,Lemoine 讨论了他认为 LaMDA “想要”和“相信”的东西,这支持了他认为“感知”不仅仅意味着其严格的字典定义的想法。

我们一开始并不了解知觉和意识

事情是这样的:我们对感知力、意识、智力以及成为拥有这些属性的实体意味着什么知之甚少。 具有讽刺意味的是,机器学习技术最终可能会帮助我们破解一些关于我们的思想及其存在的大脑的谜团。

目前,哲学家和科学家们正在破解意识的“黑匣子”,但它似乎仍然是某种超越其部分总和的结果。 意识似乎是一种“涌现”的东西。 它是一个“幽灵”,由许多不同的神经子系统相互作用产生,其中没有一个似乎是自己有感知的。

同样,复杂的人工智能(例如 DALL-E 2 图像生成系统)由更简单的机器学习模型组成,这些模型相互馈送以创建最终产品。 由更简单系统的交互引起的复杂性主题是您在 AI 世界中经常遇到的主题,尽管我们可能对每个子组件的工作方式有很好的了解,但最终结果通常是不可预测的。

我们甚至会识别人工智能中的情感吗?

如果为了争论,一个人工智能实际上是真正意义上的有知觉,我们甚至能说出来吗? LaMDA 旨在模仿和预测人类对话中的模式,因此在触发人类与类人智能相关的事物时,这套牌真的很复杂。 然而,我们花了很长时间才将非人类灵长类动物和海豚、章鱼和大象等动物视为有知觉——尽管从宏观上看,它们实际上是我们的兄弟姐妹。

有感知力的 AI 可能是如此陌生,以至于我们不知道我们正在看着我们面前的一个。 这是特别有可能的,因为我们不知道感知出现的阈值条件是什么。 不难想象,数据和 AI 子系统以正确的方式混合在一起的正确组合可能会突然产生具有感知能力的东西,但它可能会被忽视,因为它看起来不像我们能理解的任何东西。

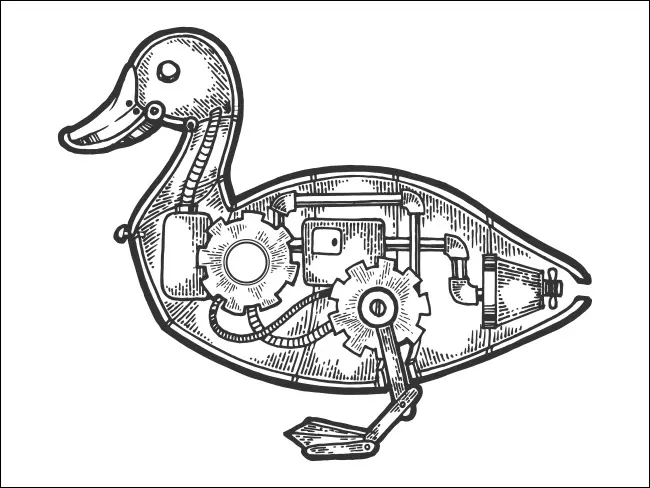

如果它看起来像一只鸭子……

最后一个关于机器感知力的大问题与其他任何事物(包括人类)的感知力都是同样的问题。 从哲学上讲,您不知道与您互动的任何人是否真的有知觉。 这是经典的哲学僵尸问题,这是一个关于假设的生物的思想实验,这些生物与人类完全没有区别,除了它们缺乏感知力或任何类型的意识体验。

然而,正如艾伦图灵的著名测试所假设的那样,人工智能是否“真正”思考和感受并不重要。 重要的是它可以很好地模仿思维和感觉的外观,以至于我们无法区分。 取决于你问谁,LaMDA 已经通过了图灵测试,这可能会使 Lemoine 的不可测试的声明成为一个有争议的问题。