25 เครื่องมือรวบรวมข้อมูลเว็บที่ดีที่สุดฟรี

เผยแพร่แล้ว: 2022-04-08

คุณกำลังมองหาเครื่องมือในการปรับปรุงการจัดอันดับ SEO การเปิดรับและการแปลงหรือไม่? คุณต้องมีเครื่องมือรวบรวมข้อมูลเว็บ โปรแกรมรวบรวมข้อมูลเว็บเป็นโปรแกรมคอมพิวเตอร์ที่สแกนอินเทอร์เน็ต เว็บสไปเดอร์ ซอฟต์แวร์ดึงข้อมูลเว็บ และโปรแกรมขูดเว็บไซต์เป็นตัวอย่างของเทคโนโลยีการรวบรวมข้อมูลเว็บทางอินเทอร์เน็ต มันยังเป็นที่รู้จักกันในนามสไปเดอร์บอทหรือแมงมุม วันนี้ เราจะมาดูเครื่องมือรวบรวมข้อมูลเว็บฟรีเพื่อดาวน์โหลด

สารบัญ

- 25 เครื่องมือรวบรวมข้อมูลเว็บที่ดีที่สุดฟรี

- 1. เปิดเซิฟเวอร์การค้นหา

- 2. Spinn3r

- 3. Import.io

- 4. บูบิง

- 5. GNU Wget

- 6. Webhose.io

- 7. Norconex

- 8. Dexi.io

- 9. ไซเต

- 10. อาปาเช่ นัทช์

- 11. VisualScraper

- 12. เว็บสฟิงซ์

- 13. OutWit Hub

- 14. Scrapy

- 15. โมเซนดา

- 16. Cyotek Webcopy

- 17. การรวบรวมข้อมูลทั่วไป

- 18. เซมรัช

- 19. Sitechecker.pro

- 20. เว็บฮาร์วี่

- 21. NetSpeak Spider

- 22. UiPath

- 23. เครื่องขูดฮีเลียม

- 24. 80ขา

- 25. ParseHub

25 เครื่องมือรวบรวมข้อมูลเว็บที่ดีที่สุดฟรี

เครื่องมือรวบรวมข้อมูลเว็บให้ข้อมูลมากมายสำหรับการทำเหมืองข้อมูลและการวิเคราะห์ วัตถุประสงค์หลักคือการสร้างดัชนีหน้าเว็บบนอินเทอร์เน็ต สามารถตรวจจับลิงก์ที่เสีย เนื้อหาที่ซ้ำกัน และชื่อหน้าที่หายไป และระบุปัญหา SEO ที่ร้ายแรง การขูดข้อมูลออนไลน์อาจเป็นประโยชน์ต่อธุรกิจของคุณในหลายๆ ด้าน

- แอปโปรแกรมรวบรวมข้อมูลเว็บหลายแอปสามารถรวบรวมข้อมูลจาก URL ของเว็บไซต์ได้อย่างเหมาะสม

- โปรแกรมเหล่านี้ช่วยคุณในการปรับปรุงโครงสร้างของเว็บไซต์ของคุณเพื่อให้เครื่องมือค้นหาสามารถเข้าใจและเพิ่มอันดับของคุณ

ในรายการเครื่องมือยอดนิยมของเรา เราได้รวบรวมรายชื่อเครื่องมือรวบรวมข้อมูลเว็บที่ดาวน์โหลดได้ฟรี รวมถึงคุณลักษณะและค่าใช้จ่ายต่างๆ ให้คุณเลือก รายการนี้ยังรวมถึงแอปพลิเคชันที่ต้องชำระ

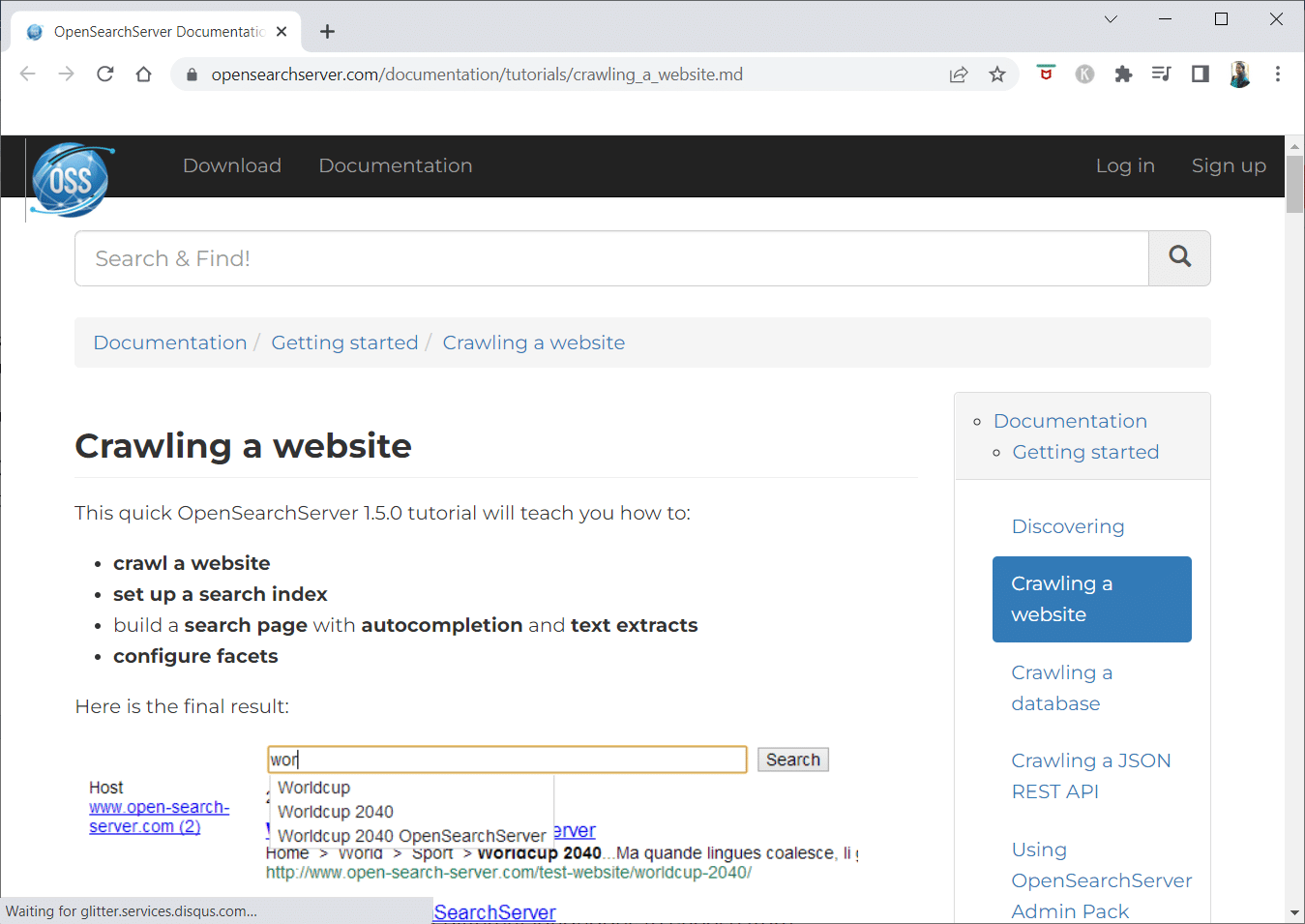

1. เปิดเซิฟเวอร์การค้นหา

OpenSearchServer เป็นโปรแกรมรวบรวมข้อมูลเว็บฟรีและมีการจัดอันดับสูงสุดบนอินเทอร์เน็ต หนึ่งในทางเลือกที่ดีที่สุด

- เป็น โซลูชั่นแบบบูรณาการอย่างสมบูรณ์

- Open Search Server เป็นโปรแกรมรวบรวมข้อมูลเว็บและเสิร์ชเอ็นจิ้นที่ฟรีและโอเพ่นซอร์ส

- เป็นโซลูชันแบบครบวงจรและคุ้มค่า

- มันมาพร้อมกับชุดความสามารถในการค้นหาที่ครอบคลุมและความเป็นไปได้ในการสร้างกลยุทธ์การจัดทำดัชนีของคุณเอง

- โปรแกรมรวบรวมข้อมูลสามารถสร้างดัชนีได้แทบทุกอย่าง

- มี การค้นหาข้อความแบบเต็ม บูลีน และการออกเสียง ให้เลือก

- คุณสามารถเลือกจาก 17 ภาษาที่แตกต่างกัน

- มีการจำแนกประเภทอัตโนมัติ

- คุณสามารถสร้างตารางเวลาสำหรับสิ่งที่เกิดขึ้นบ่อยๆ

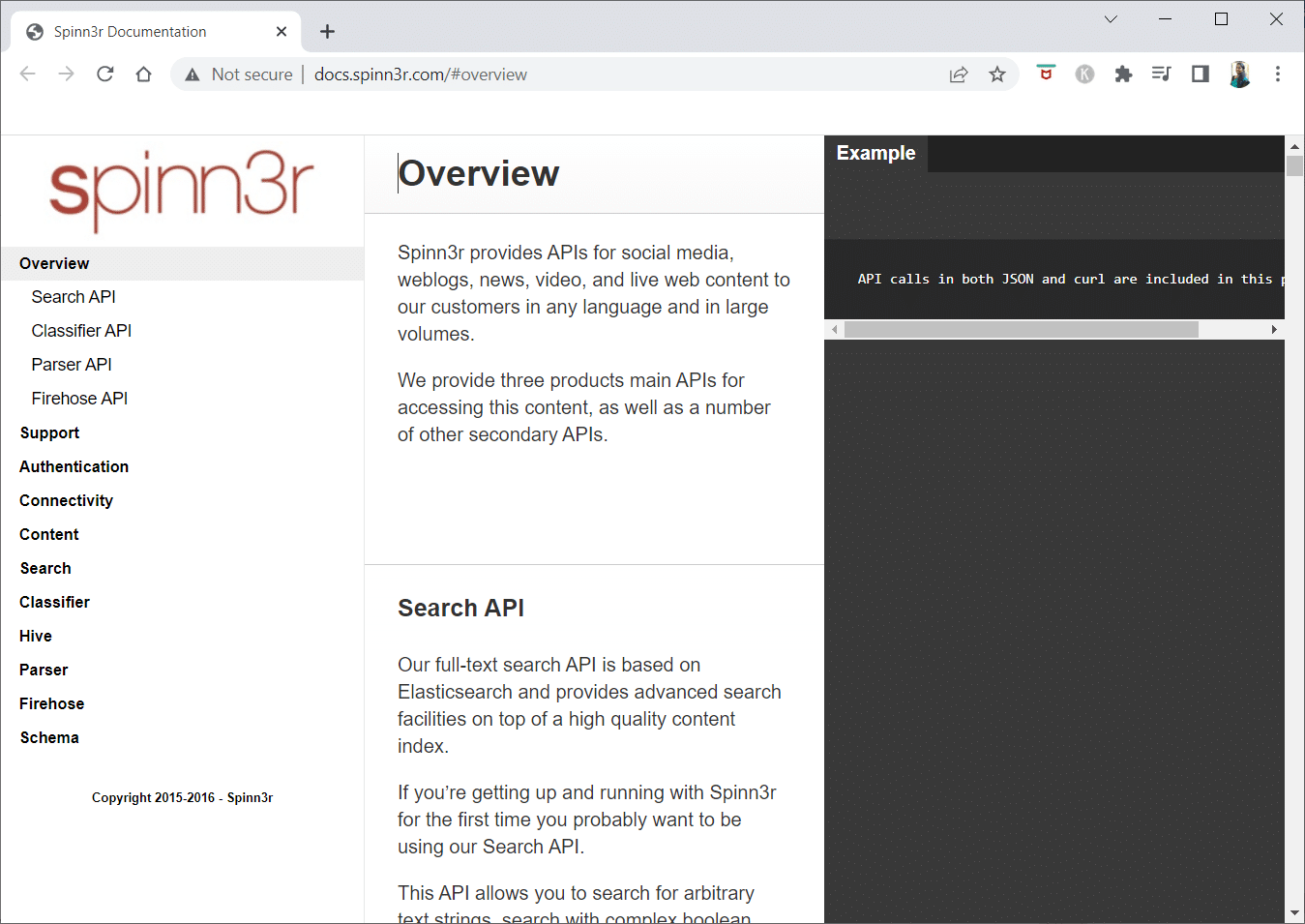

2. Spinn3r

โปรแกรมรวบรวมข้อมูลเว็บ Spinn3r ช่วยให้คุณสามารถดึงเนื้อหาจาก บล็อก ข่าวสาร เว็บไซต์เครือข่ายสังคม ฟีด RSS และฟีด ATOM ได้อย่างเต็มที่

- มันมาพร้อมกับ API ที่รวดเร็วซึ่งจัดการ 95% ของงานการจัดทำดัชนี

- การป้องกันสแปมขั้นสูงรวมอยู่ในแอปพลิเคชันการรวบรวมข้อมูลเว็บนี้ ซึ่งจะลบสแปมและการใช้ภาษาที่ไม่เหมาะสม ปรับปรุงความปลอดภัยของข้อมูล

- เว็บสแครปเปอร์จะคอยค้นหาข้อมูลอัพเดตจากแหล่งต่างๆ อย่างต่อเนื่องเพื่อนำเสนอเนื้อหาแบบเรียลไทม์แก่คุณ

- มันจัดทำดัชนีเนื้อหาในลักษณะเดียวกับที่ Google ทำ และข้อมูลที่แยกออกมาจะถูกบันทึกเป็นไฟล์ JSON

- Parser API ช่วยให้คุณแยกวิเคราะห์และจัดการข้อมูลสำหรับ URL ของเว็บที่กำหนดเองได้อย่างรวดเร็ว

- Firehose API ได้รับการออกแบบมาเพื่อการเข้าถึงข้อมูลปริมาณมหาศาล

- ส่วนหัว HTTP แบบธรรมดาใช้ สำหรับตรวจสอบสิทธิ์ API ของ Spinn3r ทั้งหมด

- นี่คือเครื่องมือรวบรวมข้อมูลเว็บสำหรับการดาวน์โหลดฟรี

- Classifier API ช่วยให้นักพัฒนาสามารถส่งข้อความ (หรือ URL) เพื่อติดป้ายกำกับโดยเทคโนโลยีการเรียนรู้ของเครื่อง

อ่านเพิ่มเติม: วิธีเข้าถึงไซต์ที่ถูกบล็อกใน UAE

3. Import.io

Import.io ให้คุณขูดหน้าเว็บหลายล้านหน้าในเวลาไม่กี่นาที และสร้าง API กว่า 1,000 รายการตามความต้องการของคุณโดยไม่ต้องเขียนโค้ดแม้แต่บรรทัดเดียว

- ขณะนี้สามารถใช้งานได้โดยทางโปรแกรม และสามารถดึงข้อมูลได้โดยอัตโนมัติ

- ดึงข้อมูลจากหลาย ๆ หน้าด้วยจังหวะของปุ่ม

- มันสามารถ จดจำรายการที่มีการแบ่งหน้าได้โดยอัตโนมัติ หรือคุณอาจคลิกที่หน้าถัดไป

- คุณสามารถรวมข้อมูลออนไลน์ลงในแอพหรือเว็บไซต์ของคุณได้ด้วยการคลิกเพียงไม่กี่ครั้ง

- สร้าง URL ทั้งหมดที่คุณต้องการในไม่กี่วินาทีโดยใช้รูปแบบ เช่น หมายเลขหน้าและชื่อหมวดหมู่

- Import.io สาธิตวิธีดึงข้อมูลจากหน้าอย่างตรงไปตรงมา เพียงเลือกคอลัมน์จากชุดข้อมูลของคุณและชี้ไปที่บางสิ่งบนหน้าที่ดึงดูดสายตาของคุณ

- คุณอาจ ได้รับใบเสนอราคาบนเว็บไซต์ของพวกเขา

- ลิงก์ในหน้ารายการนำไปสู่หน้ารายละเอียดพร้อมข้อมูลเพิ่มเติม

- คุณสามารถใช้ Import.io เพื่อเข้าร่วมเพื่อรับข้อมูลทั้งหมดจากหน้ารายละเอียดพร้อมกัน

4. บูบิง

BUbiNG ซึ่งเป็นเครื่องมือรวบรวมข้อมูลเว็บรุ่นต่อไปเป็นประสบการณ์สูงสุดของผู้เขียนกับ UbiCrawler และการวิจัยสิบปีในหัวข้อนี้

- เอเจนต์เดียวสามารถรวบรวมข้อมูลได้หลายพันหน้าต่อวินาที ในขณะที่ปฏิบัติตามมาตรฐานความสุภาพที่เข้มงวด ทั้งบนโฮสต์และตาม IP

- การกระจายงานถูกสร้างขึ้นบนโปรโตคอลความเร็วสูงร่วมสมัยเพื่อให้มีปริมาณงานสูงมาก ซึ่งแตกต่างจากโปรแกรมรวบรวมข้อมูลแบบโอเพนซอร์สแบบกระจายก่อนหน้านี้ที่ขึ้นอยู่กับเทคนิคแบบแบตช์

- ใช้ ลายนิ้วมือของหน้าที่ลอกออกเพื่อตรวจหารายการที่ใกล้เคียงกัน

- BUbiNG เป็น โปรแกรมรวบรวมข้อมูล Java โอเพ่นซอร์สแบบ กระจายอย่างสมบูรณ์

- มีความขนานกันมากมาย

- มีผู้คนจำนวนมากที่ใช้ผลิตภัณฑ์นี้

- มันรวดเร็ว

- ช่วยให้สามารถ รวบรวมข้อมูลขนาดใหญ่ ได้

5. GNU Wget

GNU Wget เป็นเครื่องมือรวบรวมข้อมูลเว็บฟรี ดาวน์โหลดฟรี และเป็นโปรแกรมซอฟต์แวร์โอเพนซอร์ซที่เขียนด้วยภาษา C ที่ช่วยให้คุณได้รับไฟล์ผ่าน HTTP, HTTPS, FTP และ FTPS

- ลักษณะที่โดดเด่นที่สุดอย่างหนึ่งของแอปพลิเคชันนี้คือความสามารถในการสร้างไฟล์ข้อความที่ใช้ NLS ในภาษาต่างๆ

- คุณสามารถ เริ่มการดาวน์โหลด ที่หยุดชั่วคราวโดยใช้ REST และ RANGE

- นอกจากนี้ยังสามารถแปลงลิงก์แบบสัมบูรณ์ในเอกสารที่ดาวน์โหลดเป็นลิงก์ที่เกี่ยวข้องได้หากจำเป็น

- ใช้สัญลักษณ์แทนซ้ำในชื่อไฟล์และไดเรกทอรีมิเรอร์

- ไฟล์ข้อความตาม NLS สำหรับภาษาต่างๆ

- ขณะทำมิเรอร์ ระบบจะประเมินเวลาประทับของไฟล์ใน เครื่องเพื่อพิจารณาว่าจำเป็นต้องดาวน์โหลดเอกสารใหม่หรือไม่

อ่านเพิ่มเติม: แก้ไขข้อผิดพลาด Unspecified เมื่อคัดลอกไฟล์หรือโฟลเดอร์ใน Windows 10

6. Webhose.io

Webhose.io เป็นแอปพลิเคชั่นรวบรวมข้อมูลเว็บที่ยอดเยี่ยมที่ให้คุณสแกนข้อมูลและแยกคำหลักใน หลายภาษา โดยใช้ตัวกรองที่หลากหลายซึ่งครอบคลุมแหล่งที่มาที่หลากหลาย

- ที่เก็บถาวรยังให้ผู้ใช้ ดูข้อมูลก่อนหน้า ได้

- นอกจากนี้ การค้นพบข้อมูลการรวบรวมข้อมูลของ webhose.io มีให้บริการถึง 80 ภาษา

- ข้อมูลส่วนบุคคลที่สามารถระบุตัวตนได้ทั้งหมดที่ถูกบุกรุกอาจพบได้ในที่เดียว

- ตรวจสอบ darknets และแอปพลิเคชั่นรับส่งข้อความสำหรับภัยคุกคามทางไซเบอร์

- รูปแบบ XML, JSON และ RSS ยังสามารถเข้าถึงได้สำหรับข้อมูลที่คัดลอกมา

- คุณอาจได้รับใบเสนอราคาบนเว็บไซต์ของพวกเขา

- ผู้ใช้อาจทำดัชนีและค้นหาข้อมูลที่มีโครงสร้างบน Webhose.io ได้ง่ายๆ

- ในทุกภาษา สามารถตรวจสอบและวิเคราะห์สื่อได้

- เป็นไปได้ที่จะติดตามการอภิปรายในกระดานข้อความและฟอรัม

- ช่วยให้คุณสามารถติดตามโพสต์บล็อกที่สำคัญจากทั่วทั้งเว็บ

7. Norconex

Norconex เป็นแหล่งข้อมูลที่ยอดเยี่ยมสำหรับธุรกิจที่กำลังมองหาแอปซอฟต์แวร์รวบรวมข้อมูลเว็บแบบโอเพนซอร์ส

- ตัวรวบรวมที่มีคุณสมบัติครบถ้วนนี้อาจใช้หรือรวมเข้ากับโปรแกรมของคุณ

- นอกจากนี้ยังอาจใช้ ภาพเด่นของหน้า

- Norconex ช่วยให้คุณสามารถรวบรวมข้อมูลเนื้อหาของเว็บไซต์ได้

- สามารถใช้ระบบปฏิบัติการใดก็ได้

- ซอฟต์แวร์รวบรวมข้อมูลเว็บนี้สามารถรวบรวมข้อมูลหน้าเว็บหลายล้านหน้าบนเซิร์ฟเวอร์ความจุเฉลี่ยเดียว

- นอกจากนี้ยังมีชุดเครื่องมือสำหรับแก้ไขเนื้อหาและข้อมูลเมตา

- รับข้อมูลเมตาสำหรับเอกสารที่คุณกำลังดำเนินการอยู่

- รองรับหน้าที่แสดงผลด้วย JavaScript

- เปิดใช้งานการตรวจจับหลายภาษา

- มันเปิดใช้งานความช่วยเหลือในการแปล

- ความเร็วที่คุณรวบรวมข้อมูลอาจมีการเปลี่ยนแปลง

- ระบุเอกสารที่แก้ไขหรือลบออก

- นี่เป็นโปรแกรมรวบรวมข้อมูลเว็บฟรีทั้งหมด

8. Dexi.io

Dexi.io เป็นแอปรวบรวมข้อมูลเว็บบนเบราว์เซอร์ที่ให้คุณดึงข้อมูลจากเว็บไซต์ใดก็ได้

- Extractors, crawlers และ pipes เป็นหุ่นยนต์สามประเภทที่คุณอาจใช้เพื่อทำการขูด

- การพัฒนาตลาดคาดการณ์โดยใช้รายงานของเดลต้า

- ข้อมูลที่รวบรวมของคุณจะถูกเก็บไว้เป็นเวลาสองสัปดาห์บนเซิร์ฟเวอร์ของ Dexi.io ก่อนที่จะเก็บถาวร หรือคุณอาจส่งออกข้อมูลที่แยกออกมาเป็น ไฟล์ JSON หรือ CSV ได้ทันที

- คุณอาจได้รับใบเสนอราคาบนเว็บไซต์ของพวกเขา

- มีบริการระดับมืออาชีพ เช่น การประกันคุณภาพและการบำรุงรักษาอย่างต่อเนื่อง

- ให้บริการเชิงพาณิชย์เพื่อช่วยให้คุณตอบสนองความต้องการข้อมูลแบบเรียลไทม์ของคุณ

- สามารถติดตามสต็อคและการกำหนดราคาสำหรับ SKU/ผลิตภัณฑ์ได้ไม่จำกัดจำนวน

- ช่วยให้คุณสามารถรวมข้อมูลโดยใช้แดชบอร์ดสดและการวิเคราะห์ผลิตภัณฑ์เต็มรูปแบบ

- ช่วยให้คุณเตรียมและล้างข้อมูลผลิตภัณฑ์ที่จัดระเบียบและพร้อมใช้งานบนเว็บ

อ่านเพิ่มเติม: วิธีถ่ายโอนไฟล์จาก Android ไปยังพีซี

9. ไซเต

Zyte เป็นเครื่องมือแยกข้อมูลบนคลาวด์ที่ช่วยนักพัฒนาหลายหมื่นคนในการค้นหาข้อมูลที่สำคัญ มันเป็นหนึ่งในแอพรวบรวมข้อมูลเว็บที่ดีที่สุดฟรี

- ผู้ใช้อาจขูดหน้าเว็บโดยใช้แอปพลิเคชันการขูดภาพแบบโอเพนซอร์สโดยไม่ทราบรหัสใดๆ

- Crawlera ซึ่ง เป็นตัวหมุนพร็อกซีที่ซับซ้อนซึ่งใช้โดย Zyte อนุญาตให้ผู้ใช้รวบรวมข้อมูลไซต์ขนาดใหญ่หรือไซต์ที่มีการป้องกันบอทได้อย่างง่ายดายในขณะที่หลบเลี่ยงมาตรการตอบโต้ของบอท

- ข้อมูลออนไลน์ของคุณจะถูกส่งตามกำหนดเวลาและสม่ำเสมอ ดังนั้น แทนที่จะจัดการพร็อกซี่ คุณสามารถมุ่งความสนใจไปที่การรับข้อมูล

- เนื่องจากความสามารถและการเรนเดอร์ของเบราว์เซอร์อัจฉริยะ แอนตี้บอทที่กำหนดเป้าหมายเลเยอร์ของเบราว์เซอร์จึงสามารถจัดการได้อย่างง่ายดาย

- บนเว็บไซต์ของพวกเขา คุณอาจได้รับใบเสนอราคา

- ผู้ใช้อาจ รวบรวมข้อมูลจาก IP และภูมิภาคจำนวนมากโดยใช้ HTTP API แบบง่าย โดยไม่จำเป็นต้องบำรุงรักษาพร็อกซี

- ช่วยให้คุณสร้างเงินสดพร้อมทั้งประหยัดเวลาด้วยการรับข้อมูลที่คุณต้องการ

- ช่วยให้คุณสามารถดึงข้อมูลเว็บในปริมาณมากในขณะที่ประหยัดเวลาในการเข้ารหัสและการบำรุงรักษาสไปเดอร์

10. อาปาเช่ นัทช์

Apache Nutch อยู่ในอันดับต้น ๆ ของรายการสำหรับแอพรวบรวมข้อมูลเว็บโอเพ่นซอร์สที่ยิ่งใหญ่ที่สุดอย่างไม่ต้องสงสัย

- สามารถทำงานได้ในเครื่องเดียว อย่างไรก็ตาม จะทำงานได้ดีที่สุดในคลัสเตอร์ Hadoop

- สำหรับการพิสูจน์ตัวตน จะใช้ โปรโตคอล NTLM

- มีระบบไฟล์แบบกระจาย (ผ่าน Hadoop)

- เป็นโครงการซอฟต์แวร์โอเพ่นซอร์สออนไลน์ที่รู้จักกันดีซึ่ง สามารถปรับเปลี่ยนและปรับขนาดได้สำหรับการทำเหมืองข้อมูล

- นักวิเคราะห์ข้อมูลจำนวนมากใช้สิ่งนี้ นักวิทยาศาสตร์ นักพัฒนาแอปพลิเคชัน และผู้เชี่ยวชาญด้านการทำเหมืองข้อความบนเว็บทั่วโลก

- เป็น โซลูชันข้ามแพลตฟอร์มที่ใช้ Java

- ตามค่าเริ่มต้น การดึงข้อมูลและการแยกวิเคราะห์จะทำอย่างอิสระ

- ข้อมูลถูกแมปโดยใช้ XPath และเนมสเปซ

- มันมีฐานข้อมูลกราฟลิงค์

11. VisualScraper

VisualScraper เป็นอีกหนึ่งเว็บมีดโกนที่ไม่มีการเข้ารหัสที่ยอดเยี่ยมสำหรับการดึงข้อมูลจากอินเทอร์เน็ต

- มี อินเทอร์เฟซผู้ใช้แบบชี้และคลิก ที่เรียบง่าย

- นอกจากนี้ยังมีบริการขูดออนไลน์ เช่น การเผยแพร่ข้อมูลและการสร้างซอฟต์แวร์แยกข้อมูล

- คอยจับตาดูคู่แข่งของคุณด้วย

- ผู้ใช้อาจกำหนดเวลาให้โปรเจ็กต์ของตนทำงานในช่วงเวลาหนึ่งหรือให้แสดงลำดับซ้ำทุกนาที วัน สัปดาห์ เดือน และปีด้วย Visual Scraper

- มีราคาไม่แพงและมีประสิทธิภาพมากขึ้น

- ไม่มีแม้แต่รหัสที่จะพูด

- นี่เป็นโปรแกรมรวบรวมข้อมูลเว็บฟรีทั้งหมด

- ข้อมูลแบบเรียลไทม์อาจถูกดึงมาจากหลายหน้าเว็บและบันทึกเป็น ไฟล์ CSV, XML, JSON หรือ SQL

- ผู้ใช้อาจใช้เพื่อ ดึงข่าวสาร อัปเดต และโพสต์ในฟอรัม เป็นประจำ

- ข้อมูลมี ความถูกต้องและปรับแต่งได้ 100%

อ่านเพิ่มเติม: 15 ผู้ให้บริการอีเมลฟรีที่ดีที่สุดสำหรับธุรกิจขนาดเล็ก

12. เว็บสฟิงซ์

WebSphinx เป็นแอพรวบรวมข้อมูลเว็บส่วนตัวฟรีที่ยอดเยี่ยมซึ่งง่ายต่อการติดตั้งและใช้งาน

- ได้รับการออกแบบมาสำหรับผู้ใช้เว็บที่เชี่ยวชาญและโปรแกรมเมอร์ Java ที่ต้องการ สแกนอินเทอร์เน็ตบางส่วนโดยอัตโนมัติ

- โซลูชันการดึงข้อมูลออนไลน์นี้ประกอบด้วยไลบรารีคลาส Java และสภาพแวดล้อมการเขียนโปรแกรมแบบโต้ตอบ

- หน้าสามารถต่อกันเพื่อสร้างเอกสารเดียวที่สามารถเรียกดูหรือพิมพ์ได้

- แยกข้อความทั้งหมด ที่พอดีกับรูปแบบที่กำหนดจากลำดับของหน้า

- ตอนนี้โปรแกรมรวบรวมข้อมูลเว็บสามารถเขียนด้วย Java ได้ด้วยแพ็คเกจนี้

- Crawler Workbench และไลบรารีคลาส WebSPHINX รวมอยู่ใน WebSphinx

- Crawler Workbench คือส่วนต่อประสานกราฟิกกับผู้ใช้ที่ให้คุณปรับแต่งและใช้งานโปรแกรมรวบรวมข้อมูลเว็บ

- สามารถสร้างกราฟจากกลุ่มของหน้าเว็บ

- บันทึกหน้าลงในไดรฟ์ในเครื่องของคุณเพื่ออ่านแบบออฟไลน์

13. OutWit Hub

แพลตฟอร์ม OutWit Hub ประกอบด้วยเคอร์เนลที่มีไลบรารีที่กว้างขวางของความสามารถในการจดจำและดึงข้อมูล ซึ่งอาจสร้างแอปต่างๆ ได้มากมายไม่รู้จบ โดยแต่ละแอปจะใช้ประโยชน์จากฟีเจอร์ของเคอร์เนล

- แอปพลิเคชันตัวรวบรวมข้อมูลเว็บนี้สามารถ สแกนผ่านไซต์ต่างๆ และเก็บรักษาข้อมูลที่ ค้นพบในลักษณะที่เข้าถึงได้

- เป็นรถเกี่ยวข้าวอเนกประสงค์ที่มีคุณสมบัติมากที่สุดเท่าที่เป็นไปได้เพื่อรองรับความต้องการที่หลากหลาย

- Hub มีมานานแล้ว

- มันได้พัฒนาเป็นแพลตฟอร์มที่มีประโยชน์และหลากหลายสำหรับผู้ใช้ที่ไม่ใช่ด้านเทคนิคและผู้เชี่ยวชาญด้านไอทีที่รู้วิธีเขียนโค้ด แต่รู้ว่า PHP ไม่ใช่ตัวเลือกที่เหมาะสำหรับการดึงข้อมูลเสมอไป

- OutWit Hub มี อินเทอร์เฟซเดียวสำหรับการดึงข้อมูลจำนวนเล็กน้อยหรือจำนวนมหาศาล ขึ้นอยู่กับความต้องการของคุณ

- ช่วยให้คุณสามารถขูดหน้าเว็บใด ๆ ได้โดยตรงจากเบราว์เซอร์และสร้างตัวแทนอัตโนมัติที่ดึงข้อมูลและจัดเตรียมตามความต้องการของคุณ

- คุณอาจ ได้รับใบเสนอราคา บนเว็บไซต์ของพวกเขา

14. Scrapy

Scrapy เป็นเฟรมเวิร์กการขูดออนไลน์ของ Python สำหรับการสร้างโปรแกรมรวบรวมข้อมูลเว็บที่ปรับขนาดได้

- เป็นเฟรมเวิร์กการรวบรวมข้อมูลเว็บที่สมบูรณ์ซึ่งจัดการคุณลักษณะทั้งหมดที่ทำให้โปรแกรมรวบรวมข้อมูลเว็บสร้างได้ยาก เช่น มิดเดิลแวร์พร็อกซีและคำถามในการสืบค้น

- คุณสามารถเขียนกฎสำหรับการดึงข้อมูลแล้วปล่อยให้ Scrapy จัดการส่วนที่เหลือ

- ง่ายต่อการเพิ่มคุณสมบัติใหม่โดยไม่ต้องแก้ไขแกนกลางเพราะได้รับการออกแบบมาแบบนั้น

- เป็นโปรแกรมที่ใช้ Python ที่ทำงานบน ระบบ Linux, Windows, Mac OS X และ BSD

- นี่เป็นยูทิลิตี้ฟรีอย่างสมบูรณ์

- ไลบรารีมีโครงสร้างที่พร้อมใช้งานสำหรับโปรแกรมเมอร์สำหรับปรับแต่งโปรแกรมรวบรวมข้อมูลเว็บและดึงข้อมูลจากเว็บในขนาดมหึมา

ยังอ่าน: 9 ซอฟต์แวร์กู้คืนข้อมูลที่ดีที่สุดฟรี (2022)

15. โมเซนดา

Mozenda ยังเป็นแอปรวบรวมข้อมูลเว็บฟรีที่ดีที่สุดอีกด้วย เป็นโปรแกรมขูดเว็บแบบบริการตนเองบนคลาวด์สำหรับธุรกิจ Mozenda มีการ คัดลอกเพจมากกว่า 7 พันล้านหน้า และมีลูกค้าองค์กรอยู่ทั่วโลก

- เทคโนโลยีการขูดเว็บของ Mozenda ขจัดข้อกำหนดสำหรับสคริปต์และการว่าจ้างวิศวกร

- ช่วยเพิ่มความเร็วในการรวบรวมข้อมูลได้ถึงห้าเท่า

- คุณสามารถขูดข้อความ ไฟล์ รูปภาพ และข้อมูล PDF จากเว็บไซต์ด้วยความสามารถชี้และคลิกของ Mozenda

- การจัดระเบียบไฟล์ข้อมูลทำให้คุณสามารถจัดเตรียมไฟล์สำหรับเผยแพร่ได้

- คุณสามารถส่งออกโดยตรงไปยัง TSV, CSV, XML, XLSX หรือ JSON โดยใช้ API ของ Mozeda

- คุณสามารถใช้ Data Wrangling ที่ซับซ้อนของ Mozenda เพื่อจัดระเบียบข้อมูลของคุณ เพื่อให้คุณสามารถตัดสินใจที่สำคัญได้

- คุณสามารถใช้หนึ่งในแพลตฟอร์มของพันธมิตรของ Mozenda เพื่อรวมข้อมูลหรือสร้างการผสานรวมข้อมูลแบบกำหนดเองในไม่กี่แพลตฟอร์ม

16. Cyotek Webcopy

Cyotek Webcopy เป็นเครื่องมือรวบรวมข้อมูลเว็บฟรีที่ให้คุณดาวน์โหลดเนื้อหาของเว็บไซต์ไปยังอุปกรณ์ในพื้นที่ของคุณโดยอัตโนมัติ

- เนื้อหาของเว็บไซต์ที่เลือกจะถูกสแกนและดาวน์โหลด

- คุณสามารถเลือกได้ว่าต้องการโคลนส่วนใดของเว็บไซต์และวิธีการใช้โครงสร้างที่ซับซ้อน

- เส้นทางในพื้นที่ใหม่จะเปลี่ยนเส้นทางลิงก์ไปยังแหล่งข้อมูลของเว็บไซต์ เช่น สไตล์ชีต รูปภาพ และหน้าอื่นๆ

- จะดูที่มาร์กอัป HTML ของเว็บไซต์และพยายามค้นหาแหล่งข้อมูลที่เชื่อมต่อ เช่น เว็บไซต์อื่นๆ รูปภาพ วิดีโอ การดาวน์โหลดไฟล์ และอื่นๆ

- อาจรวบรวมข้อมูลเว็บไซต์และดาวน์โหลดสิ่งที่เห็นเพื่อทำสำเนาต้นฉบับที่ยอมรับได้

17. การรวบรวมข้อมูลทั่วไป

การรวบรวมข้อมูลทั่วไปมีไว้สำหรับผู้ที่สนใจสำรวจและวิเคราะห์ข้อมูลเพื่อรับข้อมูลเชิงลึกที่เป็นประโยชน์

- เป็น องค์กรไม่แสวงหากำไร 501(c)(3) ที่อาศัยการบริจาคเพื่อดำเนินการอย่างถูกต้อง

- ใครก็ตามที่ต้องการใช้ Common Crawl สามารถทำได้โดยไม่ต้องใช้เงินหรือสร้างปัญหาใดๆ

- Common Crawl เป็นคลังข้อมูลที่อาจใช้สำหรับ การสอน การวิจัย และการวิเคราะห์

- คุณควรอ่านบทความหากคุณไม่มีทักษะทางเทคนิคใดๆ เพื่อเรียนรู้เกี่ยวกับการค้นพบที่น่าทึ่งที่ผู้อื่นใช้ข้อมูลการรวบรวมข้อมูลทั่วไป

- ครูสามารถใช้เครื่องมือเหล่านี้เพื่อสอนการวิเคราะห์ข้อมูล

อ่านเพิ่มเติม: วิธีย้ายไฟล์จาก Google Drive หนึ่งไปยังอีกที่หนึ่ง

18. เซมรัช

Semrush เป็นแอปรวบรวมข้อมูลเว็บไซต์ที่ตรวจสอบหน้าและโครงสร้างของเว็บไซต์ของคุณสำหรับปัญหา SEO ด้านเทคนิค การแก้ไขปัญหาเหล่านี้สามารถช่วยปรับปรุงผลการค้นหาของคุณได้

- มีเครื่องมือสำหรับ SEO การวิจัยตลาด การตลาดบนโซเชียลมีเดีย และการโฆษณา

- มี UI ที่ใช้งานง่าย

- ข้อมูลเมตา, HTTP/HTTPS, คำสั่ง, รหัสสถานะ, เนื้อหาที่ซ้ำกัน, ความเร็วในการตอบกลับของเพจ, การเชื่อมโยงภายใน, ขนาดภาพ, ข้อมูลที่มีโครงสร้าง และองค์ประกอบอื่นๆ จะได้รับการตรวจสอบ

- ช่วยให้คุณตรวจสอบเว็บไซต์ของคุณได้อย่างรวดเร็วและง่ายดาย

- ช่วยในการ วิเคราะห์ไฟล์บันทึก

- โปรแกรมนี้มีแดชบอร์ดที่ช่วยให้คุณสามารถดูปัญหาเว็บไซต์ได้อย่างง่ายดาย

19. Sitechecker.pro

Sitechecker.pro เป็นแอปรวบรวมข้อมูลเว็บฟรีที่ดีที่สุดอีกแอปหนึ่ง เป็นตัวตรวจสอบ SEO สำหรับเว็บไซต์ที่ช่วยคุณปรับปรุงการจัดอันดับ SEO ของคุณ

- คุณสามารถเห็นภาพโครงสร้างของหน้าเว็บได้อย่างง่ายดาย

- จะสร้าง รายงานการตรวจสอบ SEO ในหน้า ซึ่งลูกค้าอาจได้รับทางอีเมล

- เครื่องมือรวบรวมข้อมูลเว็บนี้สามารถดู ลิงก์ภายในและภายนอกของเว็บไซต์ของ คุณได้

- ช่วยคุณใน การกำหนดความเร็วของเว็บไซต์ของ คุณ

- คุณยังสามารถใช้ Sitechecker.pro เพื่อ ตรวจสอบปัญหาการจัดทำดัชนีบนหน้า Landing Page

- ช่วยให้คุณ ป้องกันการโจมตีของแฮ็กเกอร์

20. เว็บฮาร์วี่

Webharvy เป็นเครื่องมือขูดเว็บที่มีอินเทอร์เฟซแบบชี้และคลิกที่เรียบง่าย ออกแบบมาสำหรับผู้ที่ไม่รู้วิธีเขียนโค้ด

- ค่าลิขสิทธิ์ เริ่มต้นที่ $139

- คุณจะใช้เบราว์เซอร์ในตัวของ WebHarvy เพื่อโหลดไซต์ออนไลน์และเลือกข้อมูลที่จะคัดลอกโดยใช้การคลิกเมาส์

- มันสามารถ ขูด ข้อความ รูปภาพ URL และอีเมล จากเว็บไซต์โดยอัตโนมัติ และบันทึกไว้ในรูปแบบต่างๆ

- สามารถใช้ พร็อกซีเซิร์ฟเวอร์หรือ VPN เพื่อเข้าถึงเว็บไซต์เป้าหมายได้

- การขูดข้อมูลไม่จำเป็นต้องมีการสร้างโปรแกรมหรือแอปใดๆ

- คุณสามารถขูดโดยไม่ระบุชื่อและป้องกันไม่ให้ซอฟต์แวร์การขูดเว็บถูกห้ามโดยเว็บเซิร์ฟเวอร์โดยใช้พร็อกซีเซิร์ฟเวอร์หรือ VPN เพื่อเข้าถึงเว็บไซต์เป้าหมาย

- WebHarvy ระบุรูปแบบข้อมูลในเว็บไซต์โดยอัตโนมัติ

- หากคุณต้องการขูดรายการออบเจ็กต์จากหน้าเว็บ คุณไม่จำเป็นต้องดำเนินการใดๆ

อ่านเพิ่มเติม: ซอฟต์แวร์จัดการไฟล์ฟรี 8 อันดับแรกสำหรับ Windows 10

21. NetSpeak Spider

NetSpeak Spider เป็นแอปรวบรวมข้อมูลเว็บบนเดสก์ท็อปสำหรับ การตรวจสอบ SEO รายวัน ระบุปัญหาอย่างรวดเร็ว ดำเนินการวิเคราะห์อย่างเป็นระบบ และคัดลอกหน้าเว็บ

- แอปพลิเคชั่นรวบรวมข้อมูลเว็บนี้เก่งในการประเมินหน้าเว็บขนาดใหญ่ในขณะที่ลดการใช้ RAM ให้น้อยที่สุด

- ไฟล์ CSV สามารถนำเข้าและส่งออกได้อย่างง่ายดายจากข้อมูลการรวบรวมข้อมูลเว็บ

- เพียงไม่กี่คลิก คุณก็ระบุปัญหา SEO ของเว็บไซต์เหล่านี้และปัญหาร้ายแรงอื่นๆ ได้หลายร้อยข้อ

- เครื่องมือนี้จะช่วยคุณในการประเมินการเพิ่มประสิทธิภาพในหน้าของเว็บไซต์ ซึ่งรวมถึงรหัสสถานะ คำแนะนำในการรวบรวมข้อมูลและจัดทำดัชนี โครงสร้างเว็บไซต์ และการเปลี่ยนเส้นทาง และอื่นๆ

- ข้อมูลจาก Google Analytics และ Yandex อาจถูกส่งออก

- พิจารณาช่วงข้อมูล ประเภทอุปกรณ์ และการแบ่งกลุ่มสำหรับหน้าเว็บไซต์ การเข้าชม การแปลง เป้าหมาย และแม้แต่การตั้งค่าอีคอมเมิร์ซ

- การ สมัครสมาชิกรายเดือน เริ่มต้นที่ $21

- โปรแกรมรวบรวมข้อมูล SEO จะตรวจพบลิงก์และรูปภาพ ที่เสียหาย เช่นเดียวกับเนื้อหาที่ซ้ำกัน เช่น หน้า ข้อความ ชื่อที่ซ้ำกันและแท็กคำอธิบายเมตา และ H1

22. UiPath

UiPath เป็นเครื่องมือขูดออนไลน์ของโปรแกรมรวบรวมข้อมูลเว็บที่ให้คุณทำให้ขั้นตอนหุ่นยนต์เป็นแบบอัตโนมัติ มันทำการรวบรวมข้อมูลออนไลน์และเดสก์ท็อปโดยอัตโนมัติสำหรับโปรแกรมบุคคลที่สามส่วนใหญ่

- คุณสามารถติดตั้งแอปพลิเคชันการทำงานอัตโนมัติของกระบวนการหุ่นยนต์บน Windows

- สามารถดึงข้อมูลในรูปแบบตารางและตามรูปแบบจากหน้าเว็บจำนวนมาก

- UiPath สามารถ รวบรวมข้อมูลเพิ่มเติมได้ทันทีที่แกะกล่อง

- การรายงานจะติดตามหุ่นยนต์ของคุณเพื่อให้คุณสามารถอ้างอิงเอกสารได้ตลอดเวลา

- ผลลัพธ์ของคุณจะมีประสิทธิภาพและประสบความสำเร็จมากขึ้นหากคุณสร้างมาตรฐานการปฏิบัติของคุณ

- การสมัครสมาชิกรายเดือน เริ่มต้นที่ $420

- ส่วนประกอบสำเร็จรูปมากกว่า 200 รายการของ Marketplace ช่วยให้ทีมของคุณมีเวลามากขึ้นในเวลาที่น้อยลง

- หุ่นยนต์ UiPath เพิ่มความสอดคล้องโดยปฏิบัติตามวิธีการที่ตรงกับความต้องการของคุณ

- บริษัทต่างๆ อาจบรรลุการเปลี่ยนแปลงทางดิจิทัลอย่างรวดเร็วด้วยต้นทุนที่ต่ำลง โดยการปรับกระบวนการให้เหมาะสม คำนึงถึงเศรษฐกิจ และนำเสนอข้อมูลเชิงลึก

อ่านเพิ่มเติม: วิธีแก้ไขข้อผิดพลาดที่ตรวจพบดีบักเกอร์

23. เครื่องขูดฮีเลียม

Helium Scraper เป็นแอปพลิเคชันรวบรวมข้อมูลเว็บแบบภาพออนไลน์ที่ทำงานได้ดีที่สุดเมื่อมีการเชื่อมโยงระหว่างองค์ประกอบเพียงเล็กน้อย ในระดับพื้นฐาน มันสามารถตอบสนองความต้องการในการรวบรวมข้อมูลของผู้ใช้

- ไม่จำเป็นต้องมีการเข้ารหัสหรือการกำหนดค่าใดๆ

- อินเทอร์เฟซผู้ใช้ที่ชัดเจนและใช้งานง่ายช่วยให้คุณเลือกและเพิ่มกิจกรรมจากรายการที่ระบุได้

- เทมเพลตออนไลน์ยังมีให้สำหรับข้อกำหนดการตระเวนเฉพาะทาง

- นอกจอ ใช้เว็บเบราว์เซอร์ Chromium หลายตัว

- เพิ่มจำนวนเบราว์เซอร์พร้อมกันเพื่อรับข้อมูลมากที่สุด

- กำหนดการกระทำของคุณเองหรือใช้ JavaScript ที่กำหนดเองสำหรับอินสแตนซ์ที่ซับซ้อนมากขึ้น

- อาจติดตั้งบนคอมพิวเตอร์ส่วนบุคคลหรือเซิร์ฟเวอร์ Windows เฉพาะ

- ใบอนุญาตเริ่มต้นที่ 99 ดอลลาร์ และเพิ่มขึ้นจากที่นั่น

24. 80ขา

ในปี 2552 ก่อตั้ง 80Legs เพื่อให้ข้อมูลออนไลน์เข้าถึงได้มากขึ้น เป็นอีกหนึ่งเครื่องมือรวบรวมข้อมูลเว็บที่ดีที่สุดฟรี ในขั้นต้น บริษัทเน้นการให้บริการรวบรวมข้อมูลเว็บแก่ลูกค้าหลายราย

- แอพรวบรวมข้อมูลเว็บที่ครอบคลุมของเราจะให้ข้อมูลที่เป็นส่วนตัวแก่คุณ

- ความเร็วในการรวบรวมข้อมูลจะถูก ปรับโดยอัตโนมัติตามการเข้าชมเว็บไซต์

- คุณสามารถดาวน์โหลดผลการสืบค้นลงในสภาพแวดล้อมท้องถิ่นหรือคอมพิวเตอร์ของคุณผ่าน 80legs

- เพียงแค่ระบุ URL คุณก็จะรวบรวมข้อมูลเว็บไซต์ได้

- การสมัครสมาชิกรายเดือนเริ่มต้นที่ $29 ต่อเดือน

- ผ่าน SaaS คุณสามารถสร้างและดำเนินการรวบรวมข้อมูลเว็บได้

- มีเซิร์ฟเวอร์จำนวนมากที่ให้คุณดูไซต์จากที่อยู่ IP ต่างๆ

- เข้าถึงข้อมูลไซต์ได้ทันที แทนที่จะต้องการค้นหาข้อมูลในเว็บ

- อำนวยความสะดวกในการสร้างและดำเนินการรวบรวมข้อมูลเว็บที่กำหนดเอง

- คุณสามารถใช้แอปพลิเคชันนี้เพื่อ ติดตามแนวโน้มออนไลน์

- คุณสามารถสร้างเทมเพลตของคุณได้หากต้องการ

อ่านเพิ่มเติม: 5 แอพซ่อนที่อยู่ IP ที่ดีที่สุดสำหรับ Android

25. ParseHub

ParseHub เป็นแอปรวบรวมข้อมูลเว็บที่ยอดเยี่ยมซึ่งสามารถรวบรวมข้อมูลจากเว็บไซต์ที่ใช้ AJAX, JavaScript, คุกกี้ และเทคโนโลยีที่เกี่ยวข้องอื่นๆ

- เอ็นจิ้นแมชชีนเลิ ร์นนิงสามารถอ่าน ประเมิน และแปลงเนื้อหาออนไลน์เป็นข้อมูลที่มีความหมาย

- คุณยังสามารถใช้เว็บแอปในตัวในเบราว์เซอร์ของคุณได้

- สามารถรับข้อมูลจากเว็บไซต์นับล้านได้

- ParseHub จะค้นหาลิงก์และคำนับพันโดยอัตโนมัติ

- ข้อมูลจะถูกรวบรวมและจัดเก็บโดยอัตโนมัติบนเซิร์ฟเวอร์ของเรา

- แพ็คเกจรายเดือน เริ่มต้นที่ $149

- ในฐานะแชร์แวร์ คุณสามารถสร้างโปรเจ็กต์สาธารณะได้ห้าโปรเจ็กต์บน ParseHub

- คุณสามารถใช้เพื่อ เข้าถึงเมนูแบบเลื่อนลง เข้าสู่ระบบเว็บไซต์ คลิกบนแผนที่ และจัดการหน้าเว็บโดยใช้การเลื่อน แท็บ และป๊อปอัปที่ ไม่จำกัด

- ไคลเอ็นต์เดสก์ท็อปของ ParseHub พร้อมใช้งานสำหรับ Windows, Mac OS X และ Linux

- คุณอาจได้รับข้อมูลที่คัดลอกมาในรูปแบบใดก็ได้เพื่อการวิเคราะห์

- คุณสามารถสร้างโปรเจ็กต์สแครป ส่วนตัวได้อย่างน้อย 20 โปรเจ็ก ต์ที่มีระดับสมาชิกระดับพรีเมียม

ที่แนะนำ:

- วิธีการลบบัญชี DoorDash

- 31 เครื่องมือขูดเว็บที่ดีที่สุด

- 24 ซอฟต์แวร์พิมพ์ดีดฟรีที่ดีที่สุดสำหรับพีซี

- 15 เครื่องมือบีบอัดไฟล์ที่ดีที่สุดสำหรับ Windows

เราหวังว่าบทความนี้จะเป็นประโยชน์ และคุณได้เลือกเครื่องมือ รวบรวมข้อมูลเว็บฟรี ที่คุณชื่นชอบแล้ว แบ่งปันความคิด ข้อสงสัย และข้อเสนอแนะของคุณในส่วนความคิดเห็นด้านล่าง นอกจากนี้ คุณสามารถแนะนำเครื่องมือที่ขาดหายไปให้เราได้ แจ้งให้เราทราบว่าคุณต้องการเรียนรู้อะไรต่อไป