25 лучших бесплатных инструментов для поиска в Интернете

Опубликовано: 2022-04-08

Вы ищете инструменты для улучшения вашего SEO-рейтинга, охвата и конверсий? Для этого вам понадобится веб-краулер. Поисковый робот — это компьютерная программа, которая сканирует Интернет. Веб-пауки, программное обеспечение для извлечения веб-данных и программы очистки веб-сайтов являются примерами технологий сканирования Интернета. Он также известен как робот-паук или паук. Сегодня мы рассмотрим некоторые бесплатные инструменты веб-сканера, которые можно загрузить.

Содержание

- 25 лучших бесплатных инструментов для поиска в Интернете

- 1. Откройте поисковый сервер

- 2. Спинн3р

- 3. Импорт.ио

- 4. БУБИНГ

- 5. GNU Wget

- 6. Webhose.io

- 7. Норконекс

- 8. Dexi.io

- 9. Зайт

- 10. Апач Натч

- 11. Визуальный скребок

- 12. ВебСфинкс

- 13. АутВит Хаб

- 14. Скрепи

- 15. Мозенда

- 16. Циотек Вебкопи

- 17. Общий обход

- 18. Семруш

- 19. Sitechecker.pro

- 20. Вебхарви

- 21. Паук NetSpeak

- 22. УиПат

- 23. Гелиевый скребок

- 24. 80Ноги

- 25. ПарсХаб

25 лучших бесплатных инструментов для поиска в Интернете

Инструменты веб-краулера предоставляют огромное количество информации для добычи и анализа данных. Его основная цель — индексировать веб-страницы в Интернете. Он может обнаруживать неработающие ссылки, дублированный контент и отсутствующие заголовки страниц, а также выявлять серьезные проблемы с SEO. Парсинг онлайн-данных может принести пользу вашему бизнесу различными способами.

- Несколько приложений для веб-сканеров могут правильно сканировать данные с любого URL-адреса веб-сайта.

- Эти программы помогут вам улучшить структуру вашего веб-сайта, чтобы поисковые системы могли его понять и повысить ваш рейтинг.

В списке наших лучших инструментов мы составили список инструментов для бесплатного скачивания веб-краулера, а также их функции и стоимость, чтобы вы могли выбрать из них. В список также входят платные приложения.

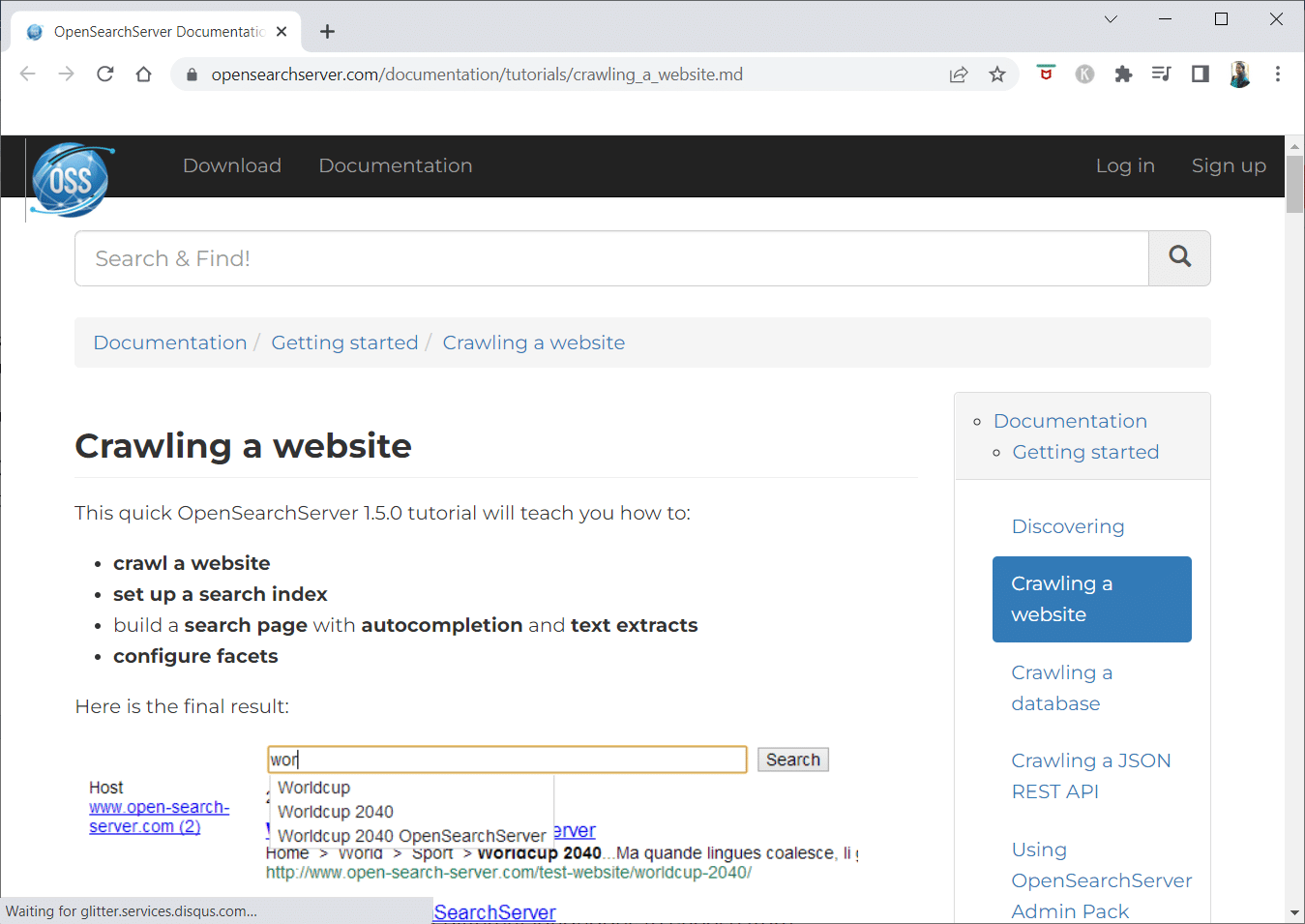

1. Откройте поисковый сервер

OpenSearchServer — бесплатный поисковый робот, имеющий один из самых высоких рейтингов в Интернете. Одна из лучших доступных альтернатив.

- Это полностью интегрированное решение .

- Open Search Server — это бесплатный веб-сканер и поисковая система с открытым исходным кодом.

- Это универсальное и экономичное решение.

- Он поставляется с полным набором возможностей поиска и возможностью создания собственной стратегии индексации.

- Сканеры могут индексировать что угодно.

- Есть полнотекстовый, логический и фонетический поиск на выбор.

- Вы можете выбрать один из 17 различных языков .

- Производятся автоматические классификации.

- Вы можете составить расписание для вещей, которые происходят часто.

2. Спинн3р

Программа-сканер Spinn3r позволяет полностью извлекать контент из блогов, новостей, сайтов социальных сетей, RSS-каналов и каналов ATOM .

- Он поставляется с молниеносным API, который выполняет 95% работы по индексированию .

- В это приложение для веб-сканирования включена расширенная защита от спама, которая удаляет спам и недопустимое использование языка, повышая безопасность данных.

- Веб-скребок постоянно просматривает Интернет в поисках обновлений из многочисленных источников, чтобы предоставить вам контент в реальном времени.

- Он индексирует контент так же, как Google, а извлеченные данные сохраняются в виде файлов JSON.

- Parser API позволяет быстро анализировать и управлять информацией для произвольных веб-адресов.

- API Firehose предназначен для массового доступа к огромным объемам данных.

- Простые заголовки HTTP используются для аутентификации всех API Spinn3r.

- Это инструмент веб-сканера для бесплатной загрузки.

- Classifier API позволяет разработчикам передавать текст (или URL-адреса) для маркировки с помощью нашей технологии машинного обучения.

Читайте также: Как получить доступ к заблокированным сайтам в ОАЭ

3. Импорт.ио

Import.io позволяет вам очищать миллионы веб-страниц за считанные минуты и создавать более 1000 API в соответствии с вашими потребностями без написания единой строки кода.

- Теперь им можно управлять программно, и теперь данные могут извлекаться автоматически.

- Извлекайте данные со многих страниц одним нажатием кнопки.

- Он может автоматически распознавать разбитые на страницы списки , или вы можете щелкнуть на следующей странице.

- Вы можете включить онлайн-данные в свое приложение или на веб-сайт всего за несколько кликов.

- Создавайте все необходимые URL-адреса за пару секунд, используя такие шаблоны, как номера страниц и названия категорий.

- Import.io позволяет легко продемонстрировать, как извлекать данные со страницы. Просто выберите столбец из набора данных и укажите на что-то на странице, что бросается в глаза.

- Вы можете получить предложение на их веб-сайте .

- Ссылки на страницах списка ведут на подробные страницы с дополнительной информацией.

- Вы можете использовать Import.io, чтобы присоединиться к ним, чтобы сразу получить все данные со страниц сведений.

4. БУБИНГ

BUbiNG, инструмент веб-краулера следующего поколения, является кульминацией опыта авторов с UbiCrawler и десяти лет исследований в этой области.

- Один агент может сканировать тысячи страниц в секунду при соблюдении строгих стандартов вежливости, как на основе хоста, так и на основе IP.

- Его распределение заданий основано на современных высокоскоростных протоколах для обеспечения очень высокой пропускной способности, в отличие от более ранних распределенных сканеров с открытым исходным кодом, которые зависят от методов пакетной обработки.

- Он использует отпечаток удаленной страницы для обнаружения почти дубликатов .

- BUbiNG — это полностью распределенный сканер Java с открытым исходным кодом .

- В нем много параллелей.

- Есть много людей, которые используют этот продукт.

- Это быстро.

- Он обеспечивает крупномасштабное сканирование .

5. GNU Wget

GNU Wget — это бесплатный доступный для бесплатной загрузки инструмент веб-сканера, и это программа с открытым исходным кодом, написанная на C, которая позволяет вам получать файлы через HTTP, HTTPS, FTP и FTPS .

- Одним из наиболее отличительных аспектов этого приложения является возможность создавать файлы сообщений на основе NLS на разных языках.

- Вы можете перезапустить загрузку , которая была остановлена, используя REST и RANGE .

- Он также может преобразовывать абсолютные ссылки в загруженных документах в относительные ссылки, если это необходимо.

- Рекурсивно используйте подстановочные знаки в именах файлов и зеркальных каталогах.

- Файлы сообщений на основе NLS для различных языков.

- При зеркалировании метки времени локальных файлов оцениваются, чтобы определить, нужно ли повторно загружать документы.

Читайте также: исправьте неизвестную ошибку при копировании файла или папки в Windows 10

6. Webhose.io

Webhose.io — это фантастическое приложение для поиска в Интернете, которое позволяет сканировать данные и извлекать ключевые слова на нескольких языках с использованием различных фильтров, охватывающих широкий спектр источников.

- Архив также позволяет пользователям просматривать предыдущие данные .

- Кроме того, обнаружение данных сканирования webhose.io доступно на 80 языках .

- Вся скомпрометированная личная информация может быть найдена в одном месте.

- Исследуйте даркнеты и приложения для обмена сообщениями на предмет киберугроз.

- Форматы XML, JSON и RSS также доступны для очищенных данных.

- Вы можете получить предложение на их сайте.

- Пользователи могут просто индексировать и искать структурированные данные на Webhose.io.

- На всех языках он может отслеживать и анализировать СМИ.

- Можно следить за обсуждениями на досках объявлений и форумах.

- Это позволяет вам отслеживать ключевые сообщения в блогах со всего Интернета.

7. Норконекс

Norconex — отличный ресурс для компаний, которые ищут приложение для веб-краулера с открытым исходным кодом.

- Этот полнофункциональный сборщик может быть использован или интегрирован в вашу программу.

- Он также может занимать избранное изображение страницы .

- Norconex дает вам возможность сканировать содержимое любого веб-сайта.

- Можно использовать любую операционную систему.

- Это программное обеспечение для веб-краулера может сканировать миллионы страниц на одном сервере средней мощности.

- Он также включает в себя набор инструментов для изменения контента и метаданных.

- Получите метаданные для документов, над которыми вы сейчас работаете.

- Поддерживаются страницы с визуализацией JavaScript .

- Это позволяет обнаруживать несколько языков.

- Это включает помощь перевода.

- Скорость, с которой вы ползете, может быть изменена.

- Документы, которые были изменены или удалены, идентифицируются.

- Это абсолютно бесплатная программа для поиска в Интернете.

8. Dexi.io

Dexi.io — это веб-сканер на основе браузера, который позволяет собирать информацию с любого веб-сайта.

- Экстракторы, гусеницы и трубы — это три типа роботов, которые вы можете использовать для очистки.

- Развитие рынка прогнозируется с помощью отчетов Delta.

- Собранные вами данные будут храниться в течение двух недель на серверах Dexi.io перед архивированием, или вы можете сразу же экспортировать извлеченные данные в виде файлов JSON или CSV .

- Вы можете получить предложение на их сайте.

- Предлагаются профессиональные услуги, такие как обеспечение качества и текущее обслуживание.

- Он предлагает коммерческие услуги, которые помогут вам удовлетворить ваши потребности в данных в реальном времени.

- Можно отслеживать запасы и цены для неограниченного количества SKU/продуктов .

- Это позволяет интегрировать данные с помощью интерактивных информационных панелей и полной аналитики продукта.

- Это поможет вам подготовить и очистить веб-организованные и готовые к использованию данные о продукте.

Читайте также: Как перенести файлы с Android на ПК

9. Зайт

Zyte — это облачный инструмент для извлечения данных, который помогает десяткам тысяч разработчиков находить важную информацию. Это также одно из лучших бесплатных приложений для поиска в Интернете.

- Пользователи могут очищать веб-страницы, используя приложение визуального парсинга с открытым исходным кодом, не зная кода.

- Crawlera , сложный прокси-ротатор, используемый Zyte , позволяет пользователям легко сканировать большие или защищенные ботами сайты, избегая контрмер ботов.

- Ваша онлайн-информация доставляется по расписанию и последовательно. Следовательно, вместо управления прокси можно сосредоточиться на получении данных.

- Благодаря интеллектуальным возможностям браузера и рендерингу теперь можно легко управлять антиботами, нацеленными на уровень браузера.

- На их сайте вы можете получить цитату.

- Пользователи могут сканировать информацию с многочисленных IP-адресов и регионов, используя простой HTTP API , что избавляет от необходимости обслуживания прокси-сервера.

- Это помогает вам зарабатывать деньги, а также экономить время, получая необходимую информацию.

- Это позволяет вам извлекать веб-данные в больших масштабах, экономя время на кодирование и обслуживание пауков.

10. Апач Натч

Apache Nutch, несомненно, находится в верхней части списка лучших приложений для поиска в Интернете с открытым исходным кодом.

- Он может работать на одной машине. Однако лучше всего он работает в кластере Hadoop.

- Для аутентификации используется протокол NTLM .

- Имеет распределенную файловую систему (через Hadoop).

- Это известный проект программного обеспечения для извлечения данных в Интернете с открытым исходным кодом, который можно адаптировать и масштабировать для интеллектуального анализа данных .

- Его используют многие аналитики данных, ученые, разработчики приложений и специалисты по анализу веб-текста по всему миру.

- Это кроссплатформенное решение на основе Java .

- По умолчанию выборка и анализ выполняются независимо.

- Данные отображаются с использованием XPath и пространств имен .

- Он содержит базу данных графа связей.

11. Визуальный скребок

VisualScraper — еще один фантастический веб-скребок без кодирования для извлечения данных из Интернета.

- Он предлагает простой пользовательский интерфейс «укажи и щелкни» .

- Он также предлагает онлайн-услуги по сбору данных, такие как распространение данных и создание программных экстракторов.

- Он также следит за вашими конкурентами.

- Пользователи могут планировать выполнение своих проектов в определенное время или повторять последовательность каждую минуту, день, неделю, месяц и год с помощью Visual Scraper.

- Это менее затратно, а также более эффективно.

- Нет даже кода, чтобы говорить.

- Это абсолютно бесплатная программа для поиска в Интернете.

- Данные в реальном времени могут быть извлечены из нескольких веб-страниц и сохранены в виде файлов CSV, XML, JSON или SQL .

- Пользователи могут использовать его для регулярного извлечения новостей, обновлений и сообщений на форуме.

- Данные на 100% точны и настроены .

Читайте также: 15 лучших бесплатных провайдеров электронной почты для малого бизнеса

12. ВебСфинкс

WebSphinx — это фантастическое персональное бесплатное приложение для поиска в Интернете, которое легко настроить и использовать.

- Он предназначен для опытных веб-пользователей и программистов на языке Java, которые хотят автоматически сканировать ограниченную часть Интернета .

- Это онлайн-решение для извлечения данных включает в себя библиотеку классов Java и интерактивную среду программирования.

- Страницы можно объединять в единый документ, который можно просматривать или распечатывать.

- Извлеките весь текст , который соответствует заданному шаблону, из последовательности страниц.

- Благодаря этому пакету поисковые роботы теперь могут быть написаны на Java.

- Crawler Workbench и библиотека классов WebSPHINX включены в WebSphinx.

- Crawler Workbench — это графический пользовательский интерфейс, который позволяет настраивать и управлять поисковым роботом.

- График можно построить из группы веб-страниц.

- Сохраняйте страницы на локальный диск для чтения в автономном режиме.

13. АутВит Хаб

Платформа OutWit Hub состоит из ядра с обширной библиотекой возможностей распознавания и извлечения данных, на котором может быть создано бесконечное количество различных приложений, каждое из которых использует функции ядра.

- Этот поисковый веб-сканер может сканировать сайты и сохранять обнаруженные данные в доступной форме.

- Это многоцелевой комбайн с максимальным количеством функций для удовлетворения различных требований.

- Хаб существует уже давно.

- Он превратился в полезную и разнообразную платформу для нетехнических пользователей и ИТ-специалистов, которые знают, как программировать, но понимают, что PHP не всегда является идеальным вариантом для извлечения данных.

- OutWit Hub предоставляет единый интерфейс для извлечения небольших или больших объемов данных в зависимости от ваших требований.

- Это позволяет вам очищать любую веб-страницу прямо из браузера и создавать автоматических агентов, которые собирают данные и подготавливают их в соответствии с вашими требованиями.

- Вы можете получить предложение на их сайте.

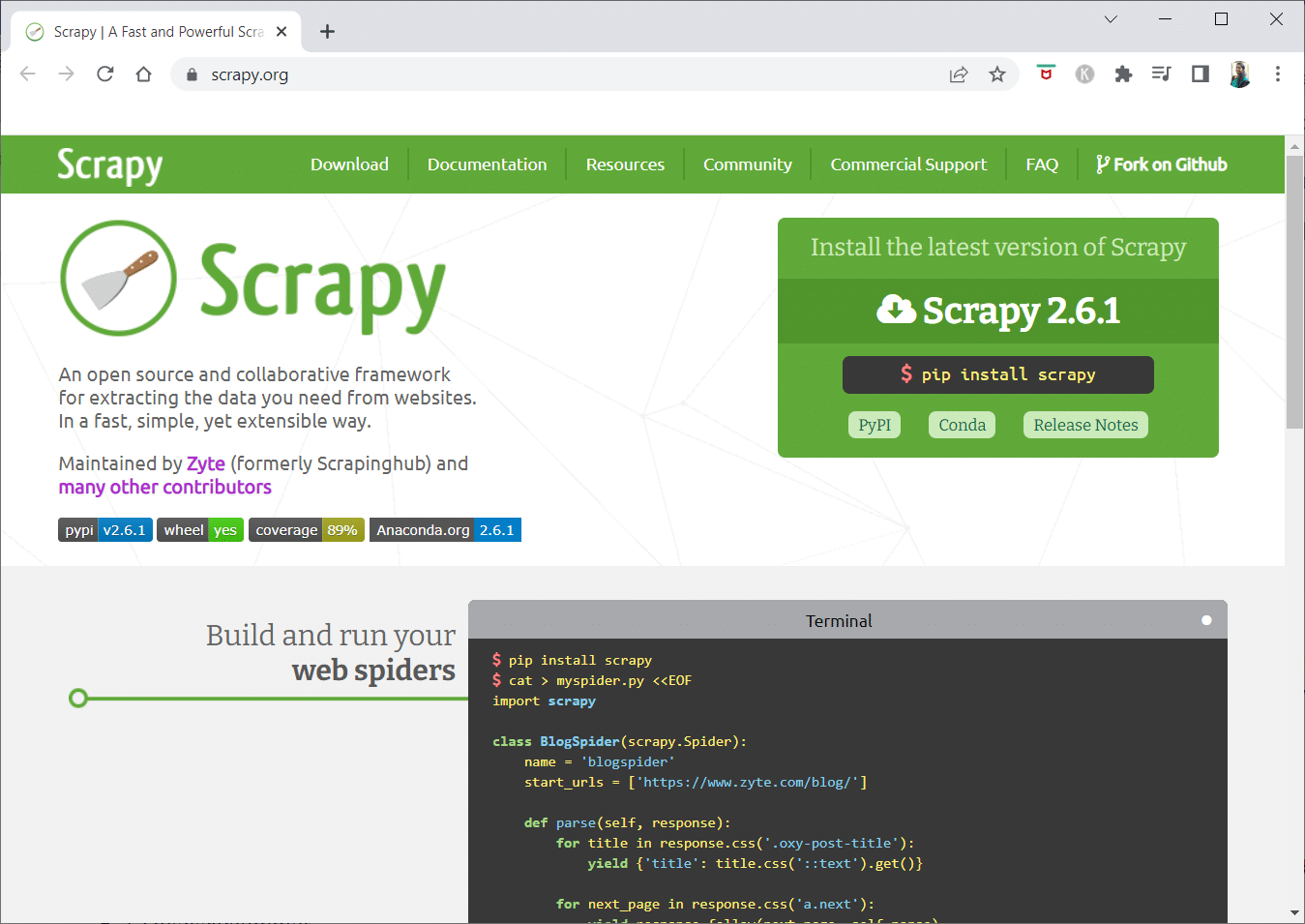

14. Скрепи

Scrapy — это онлайн-фреймворк Python для создания масштабируемых поисковых роботов.

- Это полноценная платформа для сканирования веб-сайтов, которая поддерживает все характеристики, затрудняющие создание поисковых роботов, такие как промежуточное программное обеспечение прокси-сервера и запросы на вопросы .

- Вы можете написать правила для извлечения данных, а затем позволить Scrapy сделать все остальное.

- Легко добавлять новые функции, не изменяя ядро, потому что оно так устроено.

- Это программа на основе Python, которая работает в системах Linux, Windows, Mac OS X и BSD .

- Это полностью бесплатная утилита.

- Его библиотека предоставляет программистам готовую к использованию структуру для настройки поискового робота и извлечения данных из Интернета в огромных масштабах.

Читайте также: 9 лучших бесплатных программ для восстановления данных (2022)

15. Мозенда

Mozenda также является лучшим бесплатным приложением для поиска в Интернете. Это бизнес-ориентированная облачная программа самообслуживания для очистки веб-страниц. Mozenda содержит более 7 миллиардов страниц и имеет корпоративных клиентов по всему миру.

- Технология парсинга веб-страниц Mozenda устраняет необходимость в сценариях и найме инженеров.

- Это ускоряет сбор данных в пять раз .

- Вы можете очищать текст, файлы, изображения и информацию в формате PDF с веб-сайтов с помощью функции Mozenda «укажи и щелкни».

- Организовав файлы данных, вы можете подготовить их к публикации.

- Вы можете экспортировать напрямую в TSV, CSV, XML, XLSX или JSON, используя API Mozeda .

- Вы можете использовать сложную функцию обработки данных Mozenda для организации своей информации, чтобы вы могли принимать жизненно важные решения.

- Вы можете использовать одну из платформ партнеров Mozenda для интеграции данных или настроить индивидуальную интеграцию данных на нескольких платформах.

16. Циотек Вебкопи

Cyotek Webcopy — это бесплатный веб-сканер, который позволяет автоматически загружать содержимое веб-сайта на локальное устройство.

- Содержимое выбранного веб-сайта будет отсканировано и загружено.

- Вы можете выбрать, какие части веб-сайта клонировать и как использовать его сложную структуру.

- Новый локальный маршрут будет перенаправлять ссылки на ресурсы веб-сайта, такие как таблицы стилей, изображения и другие страницы .

- Он просматривает HTML-разметку веб-сайта и пытается найти любые подключенные ресурсы, такие как другие веб-сайты, фотографии, видео, загрузки файлов и т. д.

- Он может сканировать веб-сайт и загружать все, что видит, чтобы сделать приемлемую копию оригинала.

17. Общий обход

Common Crawl был предназначен для всех, кто интересуется изучением и анализом данных, чтобы получить полезную информацию.

- Это некоммерческая организация 501(c)(3) , которая полагается на пожертвования для надлежащего ведения своей деятельности.

- Любой, кто хочет использовать Common Crawl, может сделать это, не тратя денег и не создавая проблем.

- Common Crawl — это корпус, который можно использовать для обучения, исследований и анализа.

- Вам следует прочитать статьи, если у вас нет технических навыков, чтобы узнать о замечательных открытиях, сделанных другими с использованием данных Common Crawl.

- Учителя могут использовать эти инструменты для обучения анализу данных.

Читайте также: Как переместить файлы с одного Google Диска на другой

18. Семруш

Semrush — это приложение для сканирования веб-сайтов, которое проверяет страницы и структуру вашего веб-сайта на наличие технических проблем SEO. Устранение этих проблем может помочь вам улучшить результаты поиска.

- У него есть инструменты для SEO, исследования рынка, маркетинга в социальных сетях и рекламы .

- Он имеет удобный пользовательский интерфейс.

- Будут изучены метаданные, HTTP/HTTPS, директивы, коды состояния, дублированный контент, скорость отклика страницы, внутренние ссылки, размеры изображений, структурированные данные и другие элементы.

- Это позволяет вам проверить свой сайт быстро и просто.

- Это помогает в анализе файлов журналов .

- Эта программа предоставляет панель инструментов, которая позволяет легко просматривать проблемы с веб-сайтом.

19. Sitechecker.pro

Sitechecker.pro — еще одно лучшее бесплатное приложение для поиска в Интернете. Это SEO-проверка для веб-сайтов, которая помогает вам повысить ваш SEO-рейтинг.

- Вы можете легко визуализировать структуру веб-страницы.

- Он создает отчет SEO-аудита на странице , который клиенты могут получить по электронной почте.

- Этот поисковый робот может просматривать внутренние и внешние ссылки вашего веб-сайта .

- Это поможет вам определить скорость вашего сайта .

- Вы также можете использовать Sitechecker.pro для проверки наличия проблем с индексацией целевых страниц .

- Это поможет вам защититься от хакерских атак .

20. Вебхарви

Webharvy — это инструмент для парсинга веб-страниц с простым интерфейсом «укажи и щелкни». Он предназначен для тех, кто не умеет программировать.

- Стоимость лицензии начинается от $139 .

- Вы будете использовать встроенный браузер WebHarvy для загрузки онлайн-сайтов и выбора данных для очистки с помощью щелчков мыши.

- Он может автоматически очищать текст, фотографии, URL-адреса и электронные письма с веб-сайтов и сохранять их в различных форматах.

- Для доступа к целевым веб-сайтам можно использовать прокси-серверы или VPN .

- Очистка данных не требует создания каких-либо программ или приложений.

- Вы можете выполнять парсинг анонимно и предотвращать запрет веб-серверами программ парсинга, используя прокси-серверы или виртуальные частные сети для доступа к целевым веб-сайтам.

- WebHarvy автоматически определяет шаблоны данных на веб-сайтах.

- Если вам нужно очистить список объектов с веб-страницы, больше ничего делать не нужно.

Читайте также: 8 лучших бесплатных файловых менеджеров для Windows 10

21. Паук NetSpeak

NetSpeak Spider — это настольное веб-сканер для ежедневного SEO-аудита, быстрого выявления проблем, проведения систематического анализа и очистки веб-страниц .

- Это приложение для веб-сканирования превосходно оценивает большие веб-страницы при минимальном использовании оперативной памяти.

- Файлы CSV можно легко импортировать и экспортировать из данных веб-сканирования.

- Всего за несколько кликов вы можете определить эти и сотни других серьезных SEO-проблем веб-сайта.

- Инструмент поможет вам оценить внутреннюю оптимизацию веб-сайта, включая код состояния, инструкции по сканированию и индексированию, структуру веб-сайта и перенаправления, среди прочего.

- Данные из Google Analytics и Яндекс могут быть экспортированы.

- Учитывайте диапазон данных, тип устройства и сегментацию для страниц вашего веб-сайта, трафика, конверсий, целей и даже настроек электронной коммерции.

- Ежемесячная подписка начинается с 21 доллара .

- Поисковый робот обнаружит неработающие ссылки и фотографии , а также дублирующиеся материалы, такие как страницы, тексты, повторяющиеся теги заголовков и мета-описаний, а также H1.

22. УиПат

UiPath — это онлайн-инструмент для сбора данных, который позволяет автоматизировать роботизированные процедуры. Он автоматизирует сканирование данных в Интернете и на рабочем столе для большинства сторонних программ.

- Вы можете установить приложение для роботизированной автоматизации процессов в Windows.

- Он может извлекать данные в виде таблиц и шаблонов со многих веб-страниц.

- UiPath может выполнять дополнительные сканирования прямо из коробки .

- Reporting отслеживает ваших роботов, чтобы вы могли обратиться к документации в любое время.

- Ваши результаты будут более эффективными и успешными, если вы стандартизируете свою практику.

- Ежемесячная подписка начинается от 420 долларов .

- Более 200 готовых компонентов Marketplace обеспечат вашей команде больше времени за меньшее время.

- Роботы UiPath повышают соответствие, следуя точному методу, который соответствует вашим потребностям.

- Компании могут добиться быстрой цифровой трансформации с меньшими затратами за счет оптимизации процессов, признания экономии и предложения идей.

Читайте также: Как исправить ошибку «Обнаружен отладчик»

23. Гелиевый скребок

Helium Scraper — это визуальное онлайн-приложение для сканирования данных, которое лучше всего работает, когда между элементами мало связи. На базовом уровне это может удовлетворить потребности пользователей в сканировании.

- Это не требует никакого кодирования или настройки.

- Понятный и простой пользовательский интерфейс позволяет выбирать и добавлять действия из заданного списка.

- Онлайн-шаблоны также доступны для специальных требований сканирования.

- Вне экрана используются несколько веб-браузеров Chromium .

- Увеличьте количество одновременных браузеров, чтобы получить как можно больше данных.

- Определите свои собственные действия или используйте пользовательский JavaScript для более сложных случаев.

- Его можно установить на персональный компьютер или выделенный сервер Windows.

- Его лицензии начинаются с 99 долларов и идут вверх.

24. 80Ноги

В 2009 году была основана компания 80Legs, чтобы сделать онлайн-данные более доступными. Это еще один из лучших бесплатных инструментов для поиска в Интернете. Первоначально фирма сосредоточилась на предоставлении услуг веб-сканирования различным клиентам.

- Наше обширное приложение веб-краулера предоставит вам персонализированную информацию.

- Скорость сканирования автоматически регулируется в зависимости от посещаемости сайта .

- Вы можете загрузить результаты в локальную среду или на компьютер через 80legs.

- Просто указав URL-адрес, вы можете просканировать веб-сайт.

- Ежемесячная подписка начинается с 29 долларов в месяц .

- Через SaaS можно создавать и проводить веб-сканирование.

- У него много серверов, которые позволяют просматривать сайт с разных IP-адресов.

- Получите мгновенный доступ к данным сайта вместо поиска в Интернете.

- Это облегчает создание и выполнение настраиваемых веб-сканеров.

- Вы можете использовать это приложение для отслеживания интернет-тенденций .

- Вы можете сделать свои шаблоны, если хотите.

Читайте также: 5 лучших приложений для скрытия IP-адресов для Android

25. ПарсХаб

ParseHub — отличное приложение для поиска в Интернете, которое может собирать информацию с веб-сайтов, использующих AJAX, JavaScript, файлы cookie и другие связанные технологии.

- Его механизм машинного обучения может считывать, оценивать и преобразовывать онлайн-контент в значимые данные .

- Вы также можете использовать встроенное в браузер веб-приложение.

- Получение информации с миллионов веб-сайтов возможно.

- ParseHub будет автоматически искать тысячи ссылок и слов.

- Данные собираются и автоматически сохраняются на наших серверах.

- Ежемесячные пакеты начинаются от 149 долларов .

- В качестве условно-бесплатного ПО вы можете создать только пять общедоступных проектов на ParseHub.

- Вы можете использовать его для доступа к раскрывающимся меню, входа на веб-сайты, нажатия на карты и управления веб-страницами с помощью бесконечной прокрутки, вкладок и всплывающих окон .

- Настольный клиент ParseHub доступен для Windows, Mac OS X и Linux .

- Вы можете получить данные в любом формате для анализа.

- Вы можете создать не менее 20 частных парсинг-проектов с премиальными уровнями членства.

Рекомендуемые:

- Как удалить учетную запись DoorDash

- 31 лучший инструмент для парсинга веб-страниц

- 24 лучших бесплатных программы для набора текста на ПК

- 15 лучших инструментов сжатия файлов для Windows

Мы надеемся, что эта статья была вам полезна, и вы выбрали свой любимый бесплатный поисковый робот . Поделитесь своими мыслями, вопросами и предложениями в разделе комментариев ниже. Также вы можете предложить нам недостающие инструменты. Дайте нам знать, что вы хотите узнать дальше.