Procesory graficzne NVIDIA z serii RTX 3000: oto, co nowego

Opublikowany: 2022-01-29

1 września 2020 r. NVIDIA ujawniła nową linię procesorów graficznych do gier: serię RTX 3000, opartą na ich architekturze Ampere. Porozmawiamy o nowościach, dołączonym oprogramowaniu wykorzystującym sztuczną inteligencję oraz o wszystkich szczegółach, które sprawiają, że ta generacja jest naprawdę niesamowita.

Poznaj procesory graficzne z serii RTX 3000

Główną zapowiedzią nVIDII były jej lśniące, nowe procesory graficzne, wszystkie zbudowane w niestandardowym procesie produkcyjnym 8 nm i wszystkie przynoszące znaczne przyspieszenie zarówno w zakresie rasteryzacji, jak i ray tracingu.

W dolnej części linii znajduje się RTX 3070, który kosztuje 499 USD. Jest to trochę droższe jak na najtańszą kartę zaprezentowaną przez NVIDIA podczas pierwszego ogłoszenia, ale to absolutna kradzież, gdy dowiesz się, że pokonuje istniejącą kartę RTX 2080 Ti, topową kartę, która regularnie sprzedaje się za ponad 1400 USD. Jednak po ogłoszeniu przez nVIDIĘ ceny sprzedaży stron trzecich spadły, a wiele z nich zostało sprzedanych w panice na eBayu za mniej niż 600 USD.

W momencie ogłoszenia nie ma żadnych solidnych benchmarków, więc nie jest jasne, czy karta jest rzeczywiście obiektywnie „lepsza” niż 2080 Ti, czy też nVIDIA trochę przekręca marketing. Testy porównawcze były w 4K i prawdopodobnie miały włączone RTX, co może sprawić, że różnica będzie większa niż w grach czysto zrasteryzowanych, ponieważ seria 3000 oparta na Ampere będzie działać ponad dwukrotnie lepiej w ray tracingu niż Turing. Ale ponieważ ray tracing jest teraz czymś, co nie wpływa zbytnio na wydajność i jest wspierany przez najnowszą generację konsol, głównym punktem sprzedaży jest to, że działa tak szybko, jak flagowiec poprzedniej generacji za prawie jedną trzecią ceny.

Nie jest też jasne, czy cena się utrzyma. Projekty innych firm regularnie dodają co najmniej 50 USD do ceny, a przy tym, jak wysoki będzie prawdopodobnie popyt, nie będzie zaskoczeniem, że będzie sprzedawany za 600 USD w październiku 2020 r.

Tuż powyżej znajduje się RTX 3080 za 699 USD, który powinien być dwa razy szybszy niż RTX 2080 i być około 25-30% szybszy niż 3080.

Następnie, w górnej części, nowym flagowcem jest RTX 3090, który jest komicznie ogromny. NVIDIA doskonale zdaje sobie z tego sprawę i określiła ją jako „BFGPU”, co według firmy oznacza „Big Ferocious GPU”.

NVIDIA nie pokazała żadnych bezpośrednich wskaźników wydajności, ale firma pokazała, że obsługuje gry 8K przy 60 klatkach na sekundę, co jest naprawdę imponujące. To prawda, że NVIDIA prawie na pewno używa DLSS, aby osiągnąć ten znak, ale granie w 8K to granie w 8K.

Oczywiście w końcu będzie 3060 i inne odmiany bardziej budżetowych kart, ale te zwykle pojawiają się później.

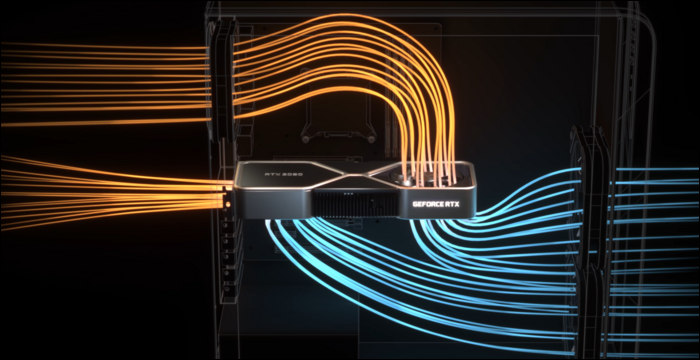

Aby rzeczywiście ochłodzić te rzeczy, NVIDIA potrzebowała odnowionego, chłodniejszego projektu. 3080 ma moc 320 watów, co jest dość wysoką wartością, więc NVIDIA zdecydowała się na konstrukcję z dwoma wentylatorami, ale zamiast obu wentylatorów umieszczonych na dole, NVIDIA umieściła wentylator na górnym końcu, gdzie zwykle znajduje się tylna płyta. Wentylator kieruje powietrze w górę w kierunku chłodnicy procesora i górnej części obudowy.

Sądząc po tym, jak duży wpływ na wydajność może mieć zły przepływ powietrza w obudowie, ma to sens. Jednak płytka drukowana jest z tego powodu bardzo ciasna, co prawdopodobnie wpłynie na ceny sprzedaży stron trzecich.

DLSS: przewaga oprogramowania

Śledzenie promieni to nie jedyna zaleta tych nowych kart. Naprawdę, to trochę hack — serie RTX 2000 i 3000 nie są o wiele lepsze w robieniu rzeczywistego ray tracingu w porównaniu ze starszymi generacjami kart. Ray tracing całej sceny w oprogramowaniu 3D, takim jak Blender, zwykle zajmuje kilka sekund lub nawet minut na klatkę, więc brutalne wymuszenie w czasie poniżej 10 milisekund nie wchodzi w rachubę.

Oczywiście istnieje dedykowany sprzęt do wykonywania obliczeń promieni, zwany rdzeniami RT, ale w dużej mierze NVIDIA zdecydowała się na inne podejście. NVIDIA ulepszyła algorytmy odszumiania, które umożliwiają procesorom graficznym renderowanie bardzo taniego pojedynczego przejścia, które wygląda okropnie, i jakoś - dzięki magii sztucznej inteligencji - zamienia to w coś, na co gracz chce spojrzeć. W połączeniu z tradycyjnymi technikami opartymi na rasteryzacji zapewnia przyjemne wrażenia wzmocnione efektami ray tracingu.

Jednak, aby zrobić to szybko, NVIDIA dodała rdzenie przetwarzania specyficzne dla AI, zwane rdzeniami Tensor. Przetwarzają one całą matematykę wymaganą do uruchomienia modeli uczenia maszynowego i robią to bardzo szybko. Zmieniają reguły gry w zakresie sztucznej inteligencji w przestrzeni serwerów w chmurze, ponieważ sztuczna inteligencja jest szeroko wykorzystywana przez wiele firm.

Poza odszumianiem, głównym zastosowaniem rdzeni Tensor dla graczy jest DLSS, czyli superpróbkowanie głębokiego uczenia. Przyjmuje ramkę o niskiej jakości i skaluje ją do pełnej jakości natywnej. Zasadniczo oznacza to, że możesz grać z klatkami na poziomie 1080p, patrząc na obraz 4K.

Pomaga to również znacznie w wydajności ray tracingu — testy porównawcze z PCMag pokazują RTX 2080 Super działającą kontrolę w ultra jakości, ze wszystkimi ustawieniami ray tracingu podkręconymi do maksimum. W 4K zmaga się tylko z 19 FPS, ale z włączonym DLSS uzyskuje znacznie lepsze 54 FPS. DLSS to darmowa wydajność dla NVIDIA, możliwa dzięki rdzeniom Tensor w architekturze Turing i Ampere. Każda gra, która to obsługuje i jest ograniczona przez GPU, może doświadczyć poważnych przyspieszeń tylko z samego oprogramowania.

DLSS nie jest nowy i został ogłoszony jako funkcja, gdy seria RTX 2000 pojawiła się dwa lata temu. W tamtym czasie była obsługiwana przez bardzo niewiele gier, ponieważ wymagała od NVIDII wytrenowania i dostrojenia modelu uczenia maszynowego dla każdej gry z osobna.

Jednak w tym czasie NVIDIA całkowicie przepisała go, nazywając nową wersję DLSS 2.0. Jest to interfejs API ogólnego przeznaczenia, co oznacza, że każdy programista może go zaimplementować i jest już wybierany przez większość głównych wydań. Zamiast pracować na jednej klatce, pobiera dane wektorowe ruchu z poprzedniej klatki, podobnie jak TAA. Wynik jest znacznie ostrzejszy niż DLSS 1.0, aw niektórych przypadkach wygląda lepiej i ostrzej niż nawet natywna rozdzielczość, więc nie ma powodu, aby go nie włączać.

Jest jeden haczyk — podczas całkowitego przełączania scen, tak jak w przerywnikach, DLSS 2.0 musi renderować pierwszą klatkę w jakości 50%, czekając na dane wektora ruchu. Może to spowodować niewielki spadek jakości na kilka milisekund. Ale 99% wszystkiego, na co patrzysz, zostanie poprawnie wyrenderowanych, a większość ludzi nie zauważa tego w praktyce.

POWIĄZANE: Co to jest NVIDIA DLSS i jak przyspieszy ray tracing?

Ampere Architecture: stworzona z myślą o sztucznej inteligencji

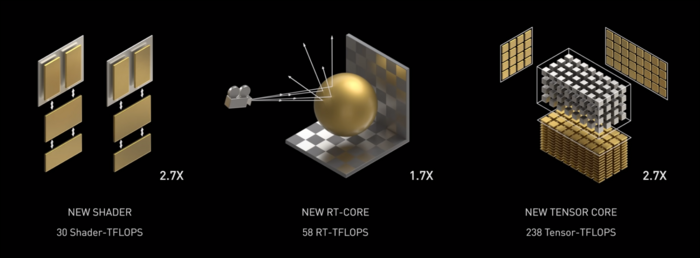

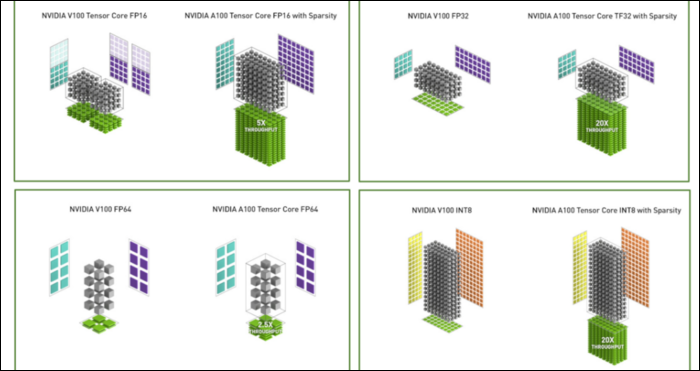

Amper jest szybki. Poważnie szybki, zwłaszcza przy obliczeniach AI. Rdzeń RT jest 1,7x szybszy niż Turing, a nowy rdzeń Tensor jest 2,7x szybszy niż Turing. Połączenie tych dwóch elementów to prawdziwy skok generacyjny w wydajności ray tracingu.

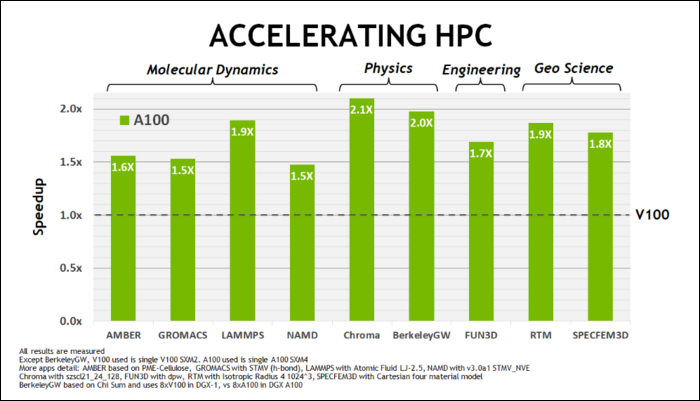

Na początku maja firma NVIDIA wypuściła procesor graficzny Ampere A100, procesor graficzny dla centrum danych przeznaczony do obsługi sztucznej inteligencji. Dzięki niemu szczegółowo opisali wiele tego, co sprawia, że Ampere jest o wiele szybszy. W przypadku obciążeń w centrach danych i obliczeniach o wysokiej wydajności Ampere jest ogólnie około 1,7 razy szybszy niż Turing. W przypadku treningu AI jest to do 6 razy szybsze.

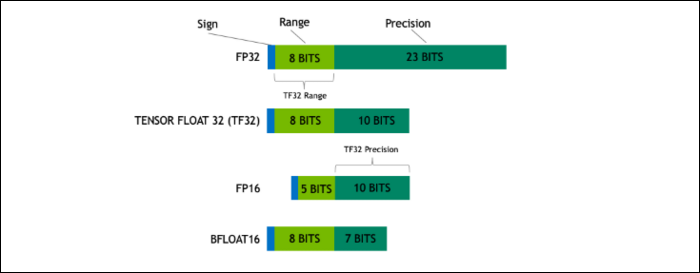

Wraz z Ampere, NVIDIA używa nowego formatu liczb, zaprojektowanego w celu zastąpienia branżowego standardu „Floating-Point 32” lub FP32 w niektórych obciążeniach. Pod maską każda liczba przetwarzana przez komputer zajmuje określoną liczbę bitów w pamięci, niezależnie od tego, czy jest to 8 bitów, 16 bitów, 32, 64 lub nawet więcej. Liczby, które są większe, są trudniejsze do przetworzenia, więc jeśli możesz użyć mniejszego rozmiaru, będziesz mieć mniej do zgryzienia.

FP32 przechowuje 32-bitową liczbę dziesiętną i używa 8 bitów dla zakresu liczby (jak duża lub mała może być) i 23 bitów dla precyzji. Twierdzenie nVIDII jest takie, że te 23 precyzyjne bity nie są całkowicie niezbędne dla wielu obciążeń SI, a podobne wyniki i znacznie lepszą wydajność można uzyskać z zaledwie 10 z nich. Zmniejszenie rozmiaru do zaledwie 19 bitów zamiast 32 ma duże znaczenie w wielu obliczeniach.

Ten nowy format nosi nazwę Tensor Float 32, a rdzenie Tensor w A100 są zoptymalizowane do obsługi formatu o dziwnych rozmiarach. To jest, oprócz kurczenia się kości i wzrostu liczby rdzeni, w jaki sposób uzyskują ogromne 6-krotne przyspieszenie treningu AI.

Oprócz nowego formatu liczb, Ampere widzi znaczne przyspieszenie wydajności w określonych obliczeniach, takich jak FP32 i FP64. Nie przekładają się one bezpośrednio na większą liczbę klatek na sekundę dla laika, ale są częścią tego, co sprawia, że ogólnie jest prawie trzy razy szybszy w operacjach Tensor.

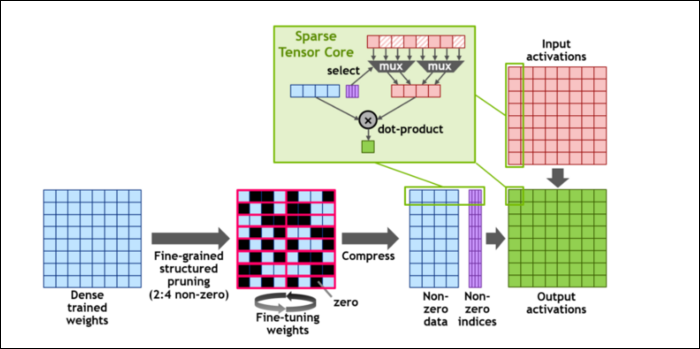

Następnie, aby jeszcze bardziej przyspieszyć obliczenia, wprowadzili pojęcie drobnoziarnistej strukturalnej rzadkości, co jest bardzo fantazyjnym słowem na dość prostą koncepcję. Sieci neuronowe pracują z dużymi listami liczb, zwanymi wagami, które wpływają na ostateczny wynik. Im więcej liczb do zgniecenia, tym wolniej.

Jednak nie wszystkie z tych liczb są rzeczywiście przydatne. Niektóre z nich są dosłownie zerowe i można je w zasadzie wyrzucić, co prowadzi do ogromnych przyspieszeń, gdy możesz jednocześnie przechytrzyć więcej liczb. Sparity zasadniczo kompresuje liczby, co wymaga mniej wysiłku przy wykonywaniu obliczeń. Nowy „Sparse Tensor Core” jest przeznaczony do pracy na skompresowanych danych.

Pomimo zmian, nVIDIA twierdzi, że nie powinno to w zauważalny sposób wpłynąć na dokładność trenowanych modeli.

Dla obliczeń Sparse INT8, jednego z najmniejszych formatów liczbowych, szczytowa wydajność pojedynczego procesora graficznego A100 wynosi ponad 1,25 PetaFLOPs, co jest zdumiewająco wysoką liczbą. Oczywiście dzieje się tak tylko przy chrupaniu jednego konkretnego rodzaju liczby, ale i tak robi to wrażenie.