25 migliori strumenti gratuiti per il crawler web

Pubblicato: 2022-04-08

Stai cercando strumenti per migliorare il posizionamento, l'esposizione e le conversioni SEO? Per fare ciò, è necessario uno strumento web crawler. Un web crawler è un programma per computer che esegue la scansione di Internet. Web spider, software di estrazione dati Web e programmi di scraping di siti Web sono esempi di tecnologie di scansione Web di Internet. È anche conosciuto come un robot ragno o un ragno. Oggi esamineremo alcuni strumenti gratuiti per il crawler web da scaricare.

Contenuti

- 25 migliori strumenti gratuiti per il crawler web

- 1. Aprire il server di ricerca

- 2. Spinn3r

- 3. Import.io

- 4. BOLLE

- 5. GNU Wget

- 6. Webhose.io

- 7. Norconex

- 8. Dexi.io

- 9. Zite

- 10. Apache Nutch

- 11. Raschietto visivo

- 12. WebSfinge

- 13. Hub OutWit

- 14. Scarso

- 15. Mozenda

- 16. Cyotek Webcopy

- 17. Scansione comune

- 18. Semrush

- 19. Sitechecker.pro

- 20. Webharvy

- 21. Ragno di NetSpeak

- 22. Percorso Ui

- 23. Raschietto ad elio

- 24. 80 Gambe

- 25. ParseHub

25 migliori strumenti gratuiti per il crawler web

Gli strumenti del crawler Web forniscono una vasta gamma di informazioni per il data mining e l'analisi. Il suo scopo principale è quello di indicizzare le pagine web su Internet. Può rilevare collegamenti interrotti, contenuti duplicati e titoli di pagine mancanti e identificare gravi problemi SEO. Lo scraping dei dati online può avvantaggiare la tua azienda in vari modi.

- Diverse app web crawler possono eseguire correttamente la scansione dei dati da qualsiasi URL del sito web.

- Questi programmi ti aiutano a migliorare la struttura del tuo sito Web in modo che i motori di ricerca possano comprenderlo e aumentare le tue classifiche.

Nell'elenco dei nostri migliori strumenti, abbiamo compilato un elenco di download gratuiti di strumenti per il crawler Web e le loro funzionalità e costi tra cui scegliere. L'elenco include anche le applicazioni a pagamento.

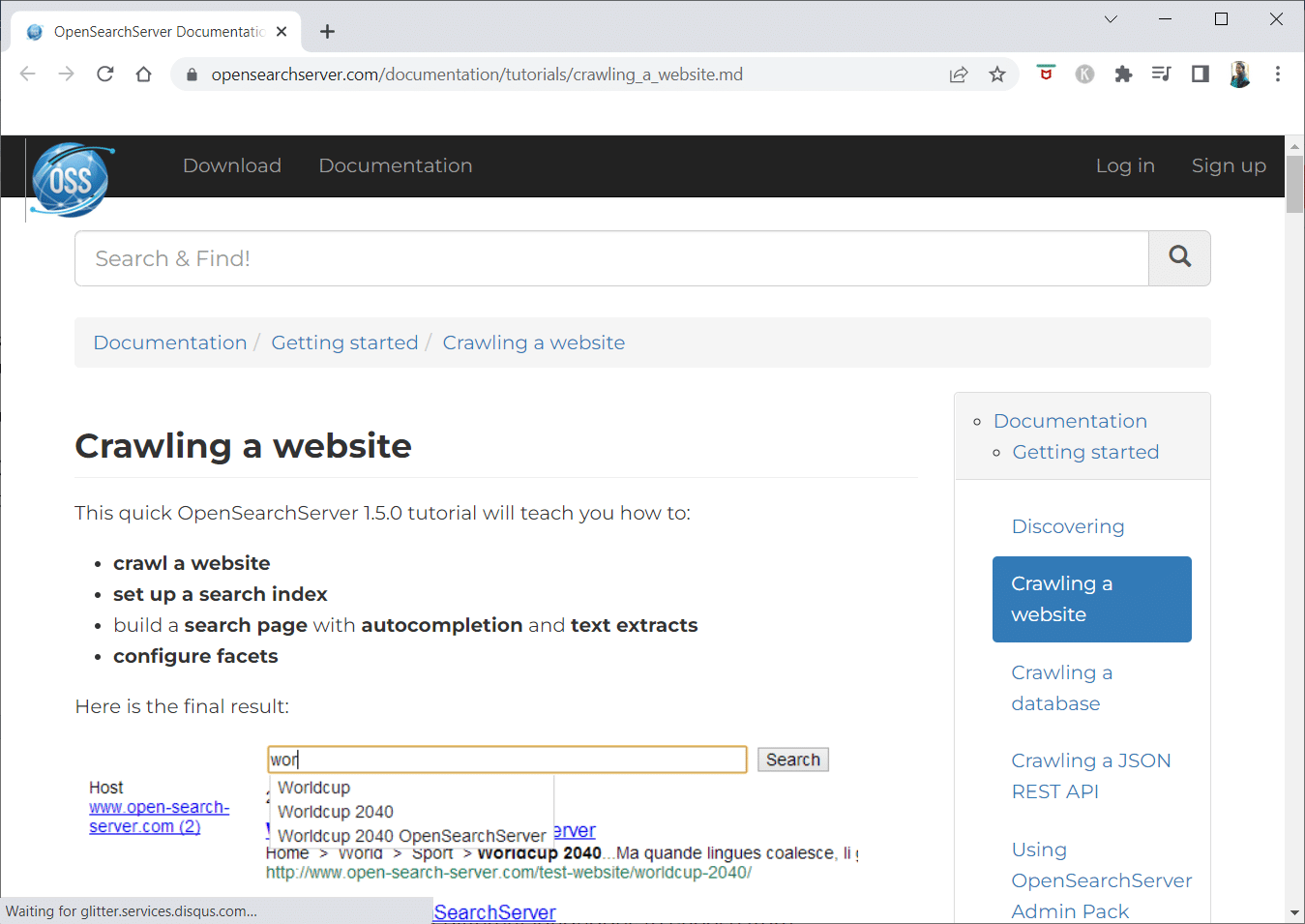

1. Aprire il server di ricerca

OpenSearchServer è un web crawler gratuito e ha una delle migliori valutazioni su Internet. Una delle migliori alternative disponibili.

- È una soluzione completamente integrata .

- Open Search Server è un motore di ricerca e scansione web gratuito e open source.

- È una soluzione completa ed economica.

- Viene fornito con una serie completa di funzionalità di ricerca e la possibilità di costruire la propria strategia di indicizzazione.

- I crawler possono indicizzare qualsiasi cosa.

- Sono disponibili ricerche full-text, booleane e fonetiche tra cui scegliere.

- Puoi scegliere tra 17 lingue diverse .

- Vengono effettuate classificazioni automatiche.

- Puoi creare un calendario per le cose che accadono frequentemente.

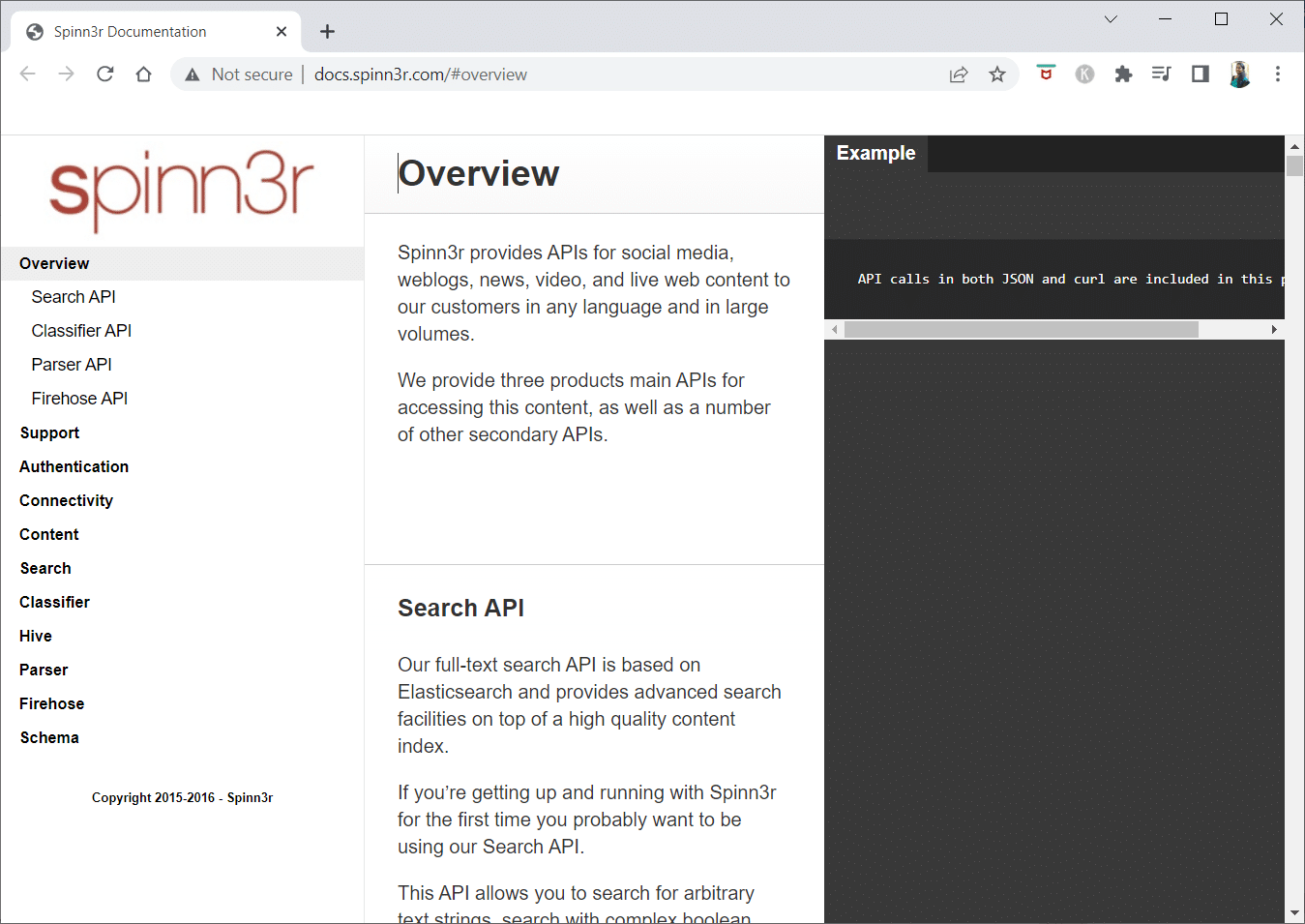

2. Spinn3r

Il programma web crawler Spinn3r ti consente di estrarre completamente i contenuti da blog, notizie, siti di social network, feed RSS e feed ATOM .

- Viene fornito con un'API velocissima che gestisce il 95% del lavoro di indicizzazione .

- La protezione avanzata dallo spam è inclusa in questa applicazione di scansione web, che rimuove lo spam e l'uso inappropriato della lingua, migliorando la sicurezza dei dati.

- Il web scraper perlustra continuamente il Web alla ricerca di aggiornamenti da numerose fonti per presentarti contenuti in tempo reale.

- Indicizza i contenuti allo stesso modo di Google e i dati estratti vengono salvati come file JSON.

- L'API Parser consente di analizzare e gestire rapidamente le informazioni per URL Web arbitrari.

- L'API Firehose è progettata per l'accesso di massa a enormi volumi di dati.

- Semplici intestazioni HTTP vengono utilizzate per autenticare tutte le API di Spinn3r.

- Questo è uno strumento web crawler per il download gratuito.

- L'API Classifier consente agli sviluppatori di trasmettere testo (o URL) da etichettare con la nostra tecnologia di apprendimento automatico.

Leggi anche: Come accedere ai siti bloccati negli Emirati Arabi Uniti

3. Import.io

Import.io ti consente di raschiare milioni di pagine Web in pochi minuti e costruire oltre 1000 API in base alle tue esigenze senza scrivere una singola riga di codice.

- Ora può essere utilizzato in modo programmatico e i dati possono ora essere recuperati automaticamente.

- Estrai dati da molte pagine con la semplice pressione di un pulsante.

- Può riconoscere automaticamente gli elenchi impaginati oppure puoi fare clic sulla pagina successiva.

- Puoi incorporare i dati online nella tua app o nel tuo sito Web con pochi clic.

- Crea tutti gli URL di cui hai bisogno in un paio di secondi utilizzando schemi come i numeri di pagina e i nomi delle categorie.

- Import.io semplifica la dimostrazione di come estrarre i dati da una pagina. Seleziona semplicemente una colonna dal tuo set di dati e punta a qualcosa sulla pagina che attira la tua attenzione.

- Potresti ricevere un preventivo sul loro sito web .

- I collegamenti alle pagine elenco portano a pagine dettagliate con ulteriori informazioni.

- Puoi utilizzare Import.io per unirti a loro per acquisire tutti i dati dalle pagine dei dettagli contemporaneamente.

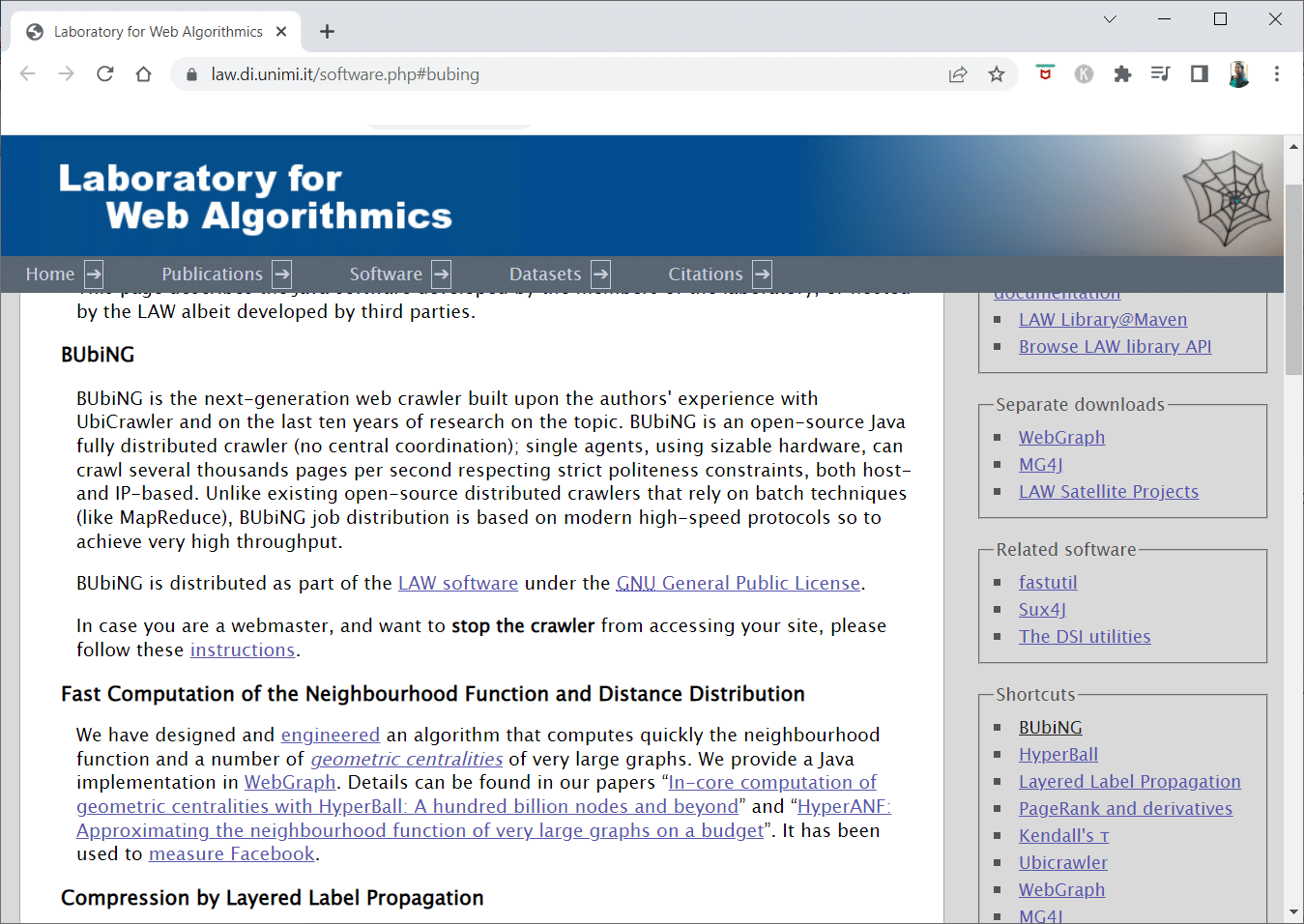

4. BOLLE

BUbiNG, uno strumento web crawler di nuova generazione, è il culmine dell'esperienza degli autori con UbiCrawler e dieci anni di ricerca sull'argomento.

- Migliaia di pagine al secondo possono essere scansionate da un singolo agente nel rispetto di rigorosi standard di cortesia, sia host che basati su IP.

- La sua distribuzione del lavoro si basa su protocolli contemporanei ad alta velocità per fornire un throughput molto elevato, a differenza dei precedenti crawler distribuiti open source che dipendono da tecniche batch.

- Utilizza l' impronta digitale di una pagina rimossa per rilevare quasi duplicati .

- BUbiNG è un crawler Java open source completamente distribuito.

- Ha molti parallelismi.

- Ci sono molte persone che utilizzano questo prodotto.

- È veloce.

- Consente la scansione su larga scala .

5. GNU Wget

GNU Wget è uno strumento gratuito di web crawler disponibile per il download gratuito ed è un programma software open source scritto in C che consente di ottenere file tramite HTTP, HTTPS, FTP e FTPS .

- Uno degli aspetti più distintivi di questa applicazione è la possibilità di creare file di messaggi basati su NLS in varie lingue.

- Puoi riavviare i download che sono stati interrotti utilizzando REST e RANGE .

- Può anche trasformare i collegamenti assoluti nei documenti scaricati in collegamenti relativi, se necessario.

- Usa ricorsivamente i caratteri jolly nei nomi di file e nelle directory mirror.

- File di messaggi basati su NLS per una varietà di lingue.

- Durante il mirroring, i timestamp dei file locali vengono valutati per determinare se i documenti devono essere nuovamente scaricati.

Leggi anche: Correggi l'errore non specificato durante la copia di un file o una cartella in Windows 10

6. Webhose.io

Webhose.io è una fantastica applicazione web crawler che ti consente di scansionare dati ed estrarre parole chiave in diverse lingue utilizzando vari filtri che coprono un'ampia gamma di fonti.

- L'archivio consente inoltre agli utenti di visualizzare i dati precedenti .

- Inoltre, le scoperte dei dati di scansione di webhose.io sono disponibili in un massimo di 80 lingue .

- Tutte le informazioni di identificazione personale che sono state compromesse possono essere trovate in un unico posto.

- Esamina le darknet e le applicazioni di messaggistica per le minacce informatiche.

- I formati XML, JSON e RSS sono accessibili anche per i dati raschiati.

- Potresti ricevere un preventivo sul loro sito web.

- Gli utenti possono semplicemente indicizzare e cercare i dati strutturati su Webhose.io.

- In tutte le lingue, può monitorare e analizzare i media.

- È possibile seguire le discussioni su bacheche e forum.

- Ti consente di tenere traccia dei post chiave del blog da tutto il Web.

7. Norconex

Norconex è una risorsa eccellente per le aziende che cercano un'app web crawler open source.

- Questo raccoglitore completo può essere utilizzato o integrato nel tuo programma.

- Potrebbe anche richiedere l'immagine in primo piano di una pagina .

- Norconex ti dà la possibilità di eseguire la scansione del contenuto di qualsiasi sito web.

- È possibile utilizzare qualsiasi sistema operativo.

- Questo software web crawler può eseguire la scansione di milioni di pagine su un singolo server di capacità media.

- Include anche una serie di strumenti per la modifica di contenuti e metadati.

- Ottieni i metadati per i documenti su cui stai attualmente lavorando.

- Le pagine con rendering JavaScript sono supportate.

- Consente il rilevamento di più lingue.

- Consente l'assistenza alla traduzione.

- La velocità di scansione potrebbe essere modificata.

- I documenti che sono stati modificati o rimossi sono identificati.

- Questo è un programma web crawler totalmente gratuito.

8. Dexi.io

Dexi.io è un'app web crawler basata su browser che ti consente di raccogliere informazioni da qualsiasi sito web.

- Estrattori, cingolati e tubi sono i tre tipi di robot che puoi utilizzare per eseguire un'operazione di raschiatura.

- Gli sviluppi del mercato sono previsti utilizzando i rapporti Delta.

- I dati raccolti verranno conservati per due settimane sui server di Dexi.io prima dell'archiviazione, oppure puoi esportare immediatamente i dati estratti come file JSON o CSV .

- Potresti ricevere un preventivo sul loro sito web.

- Ci sono servizi professionali offerti, come la garanzia della qualità e la manutenzione continua.

- Offre servizi commerciali per aiutarti a soddisfare le tue esigenze di dati in tempo reale.

- È possibile tenere traccia delle scorte e dei prezzi per un numero illimitato di SKU/prodotti .

- Ti consente di integrare i dati utilizzando dashboard live e analisi complete del prodotto.

- Ti aiuta a preparare e risciacquare i dati sui prodotti organizzati e pronti per l'uso basati sul Web.

Leggi anche: Come trasferire file da Android a PC

9. Zite

Zyte è uno strumento di estrazione dati basato su cloud che aiuta decine di migliaia di sviluppatori a individuare informazioni cruciali. È anche una delle migliori app web crawler gratuite.

- Gli utenti possono eseguire lo scraping delle pagine Web utilizzando la sua applicazione di scraping visivo open source senza conoscere alcun codice.

- Crawlera , un complesso rotatore proxy utilizzato da Zyte , consente agli utenti di eseguire facilmente la scansione di siti di grandi dimensioni o protetti da bot eludendo le contromisure dei bot.

- Le tue informazioni online vengono fornite nei tempi previsti e in modo coerente. Di conseguenza, invece di gestire i proxy, puoi concentrarti sull'ottenimento dei dati.

- Grazie alle funzionalità e al rendering intelligenti del browser, gli antibot destinati al livello del browser possono ora essere gestiti facilmente.

- Sul loro sito web, potresti ricevere un preventivo.

- Gli utenti possono eseguire la scansione da numerosi IP e regioni utilizzando una semplice API HTTP , eliminando la necessità di manutenzione del proxy.

- Ti aiuta a generare denaro e allo stesso tempo a risparmiare tempo acquisendo le informazioni di cui hai bisogno.

- Ti consente di estrarre dati Web su larga scala risparmiando tempo sulla codifica e sulla manutenzione dello spider.

10. Apache Nutch

Apache Nutch è senza dubbio in cima alla lista per la migliore app web crawler open source.

- Può funzionare su una singola macchina. Tuttavia, funziona meglio su un cluster Hadoop.

- Per l'autenticazione viene utilizzato il protocollo NTLM .

- Ha un file system distribuito (tramite Hadoop).

- È un noto progetto software di estrazione di dati online open source che è adattabile e scalabile per il data mining .

- Molti analisti di dati lo usano, scienziati, sviluppatori di applicazioni e specialisti di web text mining in tutto il mondo.

- È una soluzione multipiattaforma basata su Java .

- Per impostazione predefinita, il recupero e l'analisi vengono eseguiti in modo indipendente.

- I dati vengono mappati utilizzando XPath e namespace .

- Contiene un database di grafici di collegamento.

11. Raschietto visivo

VisualScraper è un altro fantastico web scraper non codificante per estrarre dati da Internet.

- Offre una semplice interfaccia utente punta e clicca .

- Offre anche servizi di scraping online come la diffusione dei dati e la creazione di estrattori di software.

- Tiene d'occhio anche i tuoi concorrenti.

- Gli utenti possono pianificare l'esecuzione dei propri progetti a una determinata ora o ripetere la sequenza ogni minuto, giorno, settimana, mese e anno con Visual Scraper.

- È meno costoso e più efficace.

- Non c'è nemmeno un codice per parlare.

- Questo è un programma web crawler totalmente gratuito.

- I dati in tempo reale possono essere estratti da diverse pagine Web e salvati come file CSV, XML, JSON o SQL .

- Gli utenti potrebbero utilizzarlo per estrarre regolarmente notizie, aggiornamenti e post del forum .

- I dati sono accurati e personalizzati al 100% .

Leggi anche: 15 migliori provider di posta elettronica gratuiti per le piccole imprese

12. WebSfinge

WebSphinx è una fantastica app web crawler gratuita personale semplice da configurare e utilizzare.

- È progettato per utenti Web sofisticati e programmatori Java che desiderano eseguire automaticamente la scansione di una porzione limitata di Internet .

- Questa soluzione di estrazione dati online include una libreria di classi Java e un ambiente di programmazione interattivo.

- Le pagine possono essere concatenate per creare un unico documento che può essere sfogliato o stampato.

- Estrai tutto il testo che si adatta a un determinato modello da una sequenza di pagine.

- I web crawler possono ora essere scritti in Java grazie a questo pacchetto.

- Il Crawler Workbench e la libreria di classi WebSPHINX sono entrambi inclusi in WebSphinx.

- Crawler Workbench è un'interfaccia utente grafica che consente di personalizzare e utilizzare un web crawler.

- Un grafico può essere creato da un gruppo di pagine web.

- Salva le pagine sull'unità locale per la lettura offline.

13. Hub OutWit

La piattaforma OutWit Hub è costituita da un kernel con un'ampia libreria di capacità di riconoscimento ed estrazione dei dati, su cui è possibile creare un numero infinito di app diverse, ciascuna utilizzando le funzionalità del kernel.

- Questa applicazione web crawler può scansionare i siti e conservare i dati che scopre in modo accessibile.

- È una mietitrice multiuso con quante più funzioni possibili per soddisfare le diverse esigenze.

- L'Hub esiste da molto tempo.

- Si è evoluto in una piattaforma utile e diversificata per utenti non tecnici e professionisti IT che sanno come programmare ma riconoscono che PHP non è sempre l'opzione ideale per estrarre i dati.

- OutWit Hub fornisce un'unica interfaccia per lo scraping di quantità modeste o massicce di dati a seconda delle tue esigenze.

- Ti consente di raschiare qualsiasi pagina Web direttamente dal browser e costruire agenti automatizzati che raccolgono i dati e li preparano in base alle tue esigenze.

- Potresti ricevere un preventivo sul loro sito web.

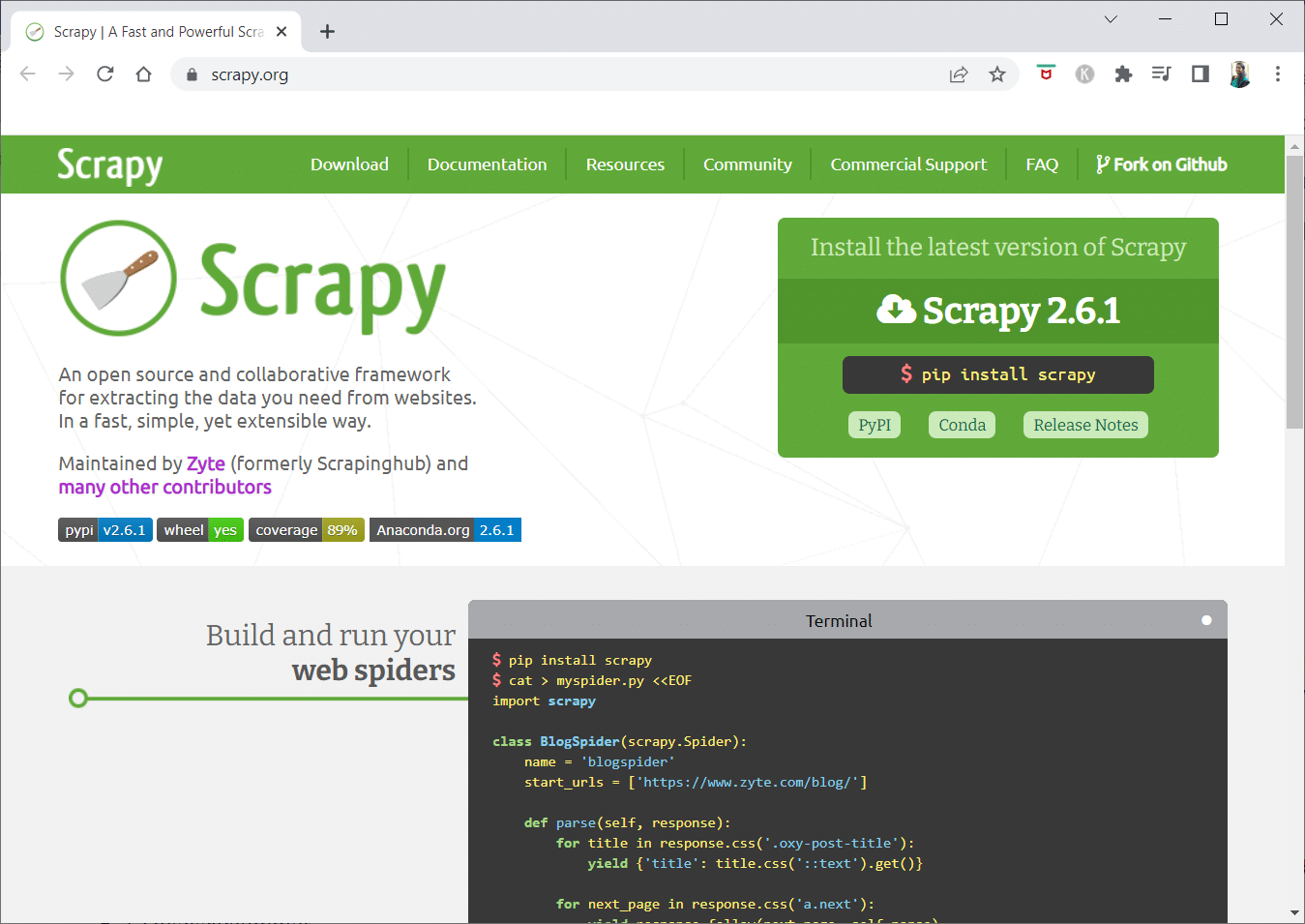

14. Scarso

Scrapy è un framework di scraping online Python per la creazione di crawler web scalabili.

- È un framework completo per la scansione del Web che gestisce tutte le caratteristiche che rendono difficile la creazione di crawler Web, come il middleware proxy e le domande di query .

- Puoi scrivere le regole per estrarre i dati e quindi lasciare che Scrapy gestisca il resto.

- È facile aggiungere nuove funzionalità senza modificare il core perché è progettato in questo modo.

- È un programma basato su Python che opera su sistemi Linux, Windows, Mac OS X e BSD .

- Questa è un'utilità completamente gratuita.

- La sua libreria fornisce ai programmatori una struttura pronta all'uso per personalizzare un web crawler ed estrarre dati dal web su vasta scala.

Leggi anche: 9 migliori software gratuiti di recupero dati (2022)

15. Mozenda

Mozenda è anche la migliore app web crawler gratuita. È un programma di scraping Web self-service basato su cloud orientato al business. Mozenda ha oltre 7 miliardi di pagine raschiate e ha clienti aziendali in tutto il mondo.

- La tecnologia web scraping di Mozenda elimina la necessità di script e l'assunzione di ingegneri.

- Accelera la raccolta dei dati di cinque volte .

- Puoi raschiare testo, file, immagini e informazioni PDF da siti Web con la funzionalità point-and-click di Mozenda.

- Organizzando i file di dati, puoi prepararli per la pubblicazione.

- Puoi esportare direttamente in TSV, CSV, XML, XLSX o JSON utilizzando l'API di Mozeda .

- Puoi utilizzare il sofisticato Data Wrangling di Mozenda per organizzare le tue informazioni in modo da poter prendere decisioni vitali.

- Puoi utilizzare una delle piattaforme dei partner di Mozenda per integrare i dati o stabilire integrazioni di dati personalizzate in alcune piattaforme.

16. Cyotek Webcopy

Cyotek Webcopy è uno strumento web crawler gratuito che ti consente di scaricare automaticamente il contenuto di un sito Web sul tuo dispositivo locale.

- Il contenuto del sito Web scelto verrà scansionato e scaricato.

- Puoi scegliere quali parti di un sito Web clonare e come utilizzare la sua struttura complessa.

- Il nuovo percorso locale reindirizzerà i collegamenti alle risorse del sito Web come fogli di stile, immagini e altre pagine .

- Esaminerà il markup HTML di un sito Web e proverà a trovare qualsiasi risorsa collegata, come altri siti Web, foto, video, download di file e così via.

- Può eseguire la scansione di un sito Web e scaricare tutto ciò che vede per creare una copia accettabile dell'originale.

17. Scansione comune

Common Crawl era destinato a chiunque fosse interessato a esplorare e analizzare i dati per acquisire informazioni utili.

- È un'organizzazione no-profit 501(c)(3) che fa affidamento sulle donazioni per gestire correttamente le proprie operazioni.

- Chiunque desideri utilizzare Common Crawl può farlo senza spendere soldi o causare problemi.

- Common Crawl è un corpus che può essere utilizzato per l'insegnamento, la ricerca e l'analisi.

- Dovresti leggere gli articoli se non hai competenze tecniche per conoscere le straordinarie scoperte che altri hanno fatto utilizzando i dati di Common Crawl.

- Gli insegnanti possono utilizzare questi strumenti per insegnare l'analisi dei dati.

Leggi anche: Come spostare i file da un Google Drive a un altro

18. Semrush

Semrush è un'app crawler di siti Web che esamina le pagine e la struttura del tuo sito Web per problemi tecnici di SEO. La risoluzione di questi problemi può aiutarti a migliorare i risultati di ricerca.

- Dispone di strumenti per SEO, ricerche di mercato, social media marketing e pubblicità .

- Ha un'interfaccia utente intuitiva.

- Verranno esaminati metadati, HTTP/HTTPS, direttive, codici di stato, contenuti duplicati, velocità di risposta della pagina, collegamenti interni, dimensioni delle immagini, dati strutturati e altri elementi.

- Ti consente di controllare il tuo sito Web in modo rapido e semplice.

- Aiuta nell'analisi dei file di registro .

- Questo programma fornisce una dashboard che ti consente di visualizzare facilmente i problemi del sito Web.

19. Sitechecker.pro

Sitechecker.pro è un'altra migliore app web crawler gratuita. È un controllo SEO per siti Web che ti aiuta a migliorare le tue classifiche SEO.

- Puoi facilmente visualizzare la struttura di una pagina web.

- Crea un rapporto di audit SEO on-page che i clienti possono ricevere via e-mail.

- Questo strumento web crawler può esaminare i link interni ed esterni del tuo sito web .

- Ti aiuta a determinare la velocità del tuo sito web .

- Puoi anche utilizzare Sitechecker.pro per verificare la presenza di problemi di indicizzazione sulle pagine di destinazione .

- Ti aiuta a difenderti dagli attacchi degli hacker .

20. Webharvy

Webharvy è uno strumento di scraping web con una semplice interfaccia point-and-click. È progettato per coloro che non sanno programmare.

- Il costo di una licenza parte da $ 139 .

- Utilizzerai il browser integrato di WebHarvy per caricare i siti online e scegliere i dati da raschiare usando i clic del mouse.

- Può raschiare automaticamente testo, foto, URL ed e-mail da siti Web e salvarli in vari formati.

- I server proxy o una VPN possono essere utilizzati per accedere ai siti Web di destinazione.

- Lo scraping dei dati non richiede la creazione di alcuna programmazione o app.

- È possibile eseguire lo scraping in modo anonimo e impedire che il software di scraping Web venga vietato dai server Web utilizzando server proxy o VPN per accedere ai siti Web di destinazione.

- WebHarvy identifica automaticamente i modelli di dati nei siti Web.

- Se hai bisogno di raschiare un elenco di oggetti da una pagina web, non devi fare nient'altro.

Leggi anche: I migliori 8 software di gestione file gratuiti per Windows 10

21. Ragno di NetSpeak

NetSpeak Spider è un'app desktop web crawler per gli audit SEO giornalieri, l'identificazione rapida dei problemi, la conduzione di analisi sistematiche e lo scraping di pagine web .

- Questa applicazione di scansione del Web eccelle nella valutazione di pagine Web di grandi dimensioni riducendo al minimo l'utilizzo della RAM.

- I file CSV possono essere facilmente importati ed esportati dai dati di scansione del Web.

- Con pochi clic, puoi identificare questi e centinaia di altri gravi problemi di SEO per i siti web.

- Lo strumento ti aiuterà a valutare l'ottimizzazione on-page di un sito Web, inclusi il codice di stato, le istruzioni di scansione e indicizzazione, la struttura del sito Web e i reindirizzamenti, tra le altre cose.

- I dati di Google Analytics e Yandex possono essere esportati.

- Prendi in considerazione l'intervallo di dati, il tipo di dispositivo e la segmentazione per le pagine del tuo sito Web, il traffico, le conversioni, i target e persino le impostazioni dell'e-commerce.

- I suoi abbonamenti mensili partono da $ 21 .

- I link e le foto interrotti verranno rilevati dal crawler SEO, così come il materiale duplicato come pagine, testi, tag duplicati di titoli e meta descrizioni e H1.

22. Percorso Ui

UiPath è uno strumento di scraping online del web crawler che consente di automatizzare le procedure robotiche. Automatizza la scansione dei dati online e desktop per la maggior parte dei programmi di terze parti.

- È possibile installare l'applicazione di automazione dei processi robotici su Windows.

- Può estrarre dati in moduli tabulari e basati su modelli da molte pagine Web.

- UiPath può eseguire ricerche per indicizzazione aggiuntive fin da subito.

- Reporting tiene traccia dei tuoi robot in modo che tu possa fare riferimento alla documentazione in qualsiasi momento.

- I tuoi risultati saranno più efficienti e di successo se standardizzi le tue pratiche.

- Gli abbonamenti mensili partono da $ 420 .

- Gli oltre 200 componenti già pronti del Marketplace offrono al tuo team più tempo in meno tempo.

- I robot UiPath aumentano la conformità seguendo il metodo esatto che soddisfa le tue esigenze.

- Le aziende possono ottenere una rapida trasformazione digitale a costi inferiori ottimizzando i processi, riconoscendo le economie e offrendo approfondimenti.

Leggi anche: Come correggere l'errore rilevato dal debugger

23. Raschietto ad elio

Helium Scraper è un'applicazione di scansione web di dati online visiva che funziona meglio quando c'è poca associazione tra gli elementi. A livello di base, potrebbe soddisfare i requisiti di scansione degli utenti.

- Non richiede alcuna codifica o configurazione.

- Un'interfaccia utente chiara e semplice consente di selezionare e aggiungere attività da un elenco specifico.

- Sono disponibili anche modelli online per requisiti di scansione specializzati.

- Fuori dallo schermo, vengono utilizzati diversi browser Web Chromium .

- Aumenta il numero di browser simultanei per ottenere quanti più dati possibili.

- Definisci le tue azioni o utilizza JavaScript personalizzato per istanze più complesse.

- Può essere installato su un personal computer o un server Windows dedicato.

- Le sue licenze partono da $ 99 e salgono da lì.

24. 80 Gambe

Nel 2009 è stata fondata 80Legs per rendere più accessibili i dati online. È un altro dei migliori strumenti web crawler gratuiti. Inizialmente, l'azienda si è concentrata sulla fornitura di servizi di scansione del Web a vari clienti.

- La nostra ampia app web crawler ti fornirà informazioni personalizzate.

- La velocità di scansione viene regolata automaticamente in base al traffico del sito web .

- Puoi scaricare i risultati nel tuo ambiente locale o computer tramite 80legs.

- Semplicemente fornendo un URL, puoi eseguire la scansione del sito web.

- I suoi abbonamenti mensili partono da $ 29 al mese .

- Attraverso SaaS, è possibile costruire ed eseguire web crawl.

- Ha molti server che ti consentono di visualizzare il sito da vari indirizzi IP.

- Ottieni l'accesso istantaneo ai dati del sito invece di perlustrare il Web.

- Facilita la costruzione e l'esecuzione di web crawl personalizzati.

- È possibile utilizzare questa applicazione per tenere traccia delle tendenze online .

- Puoi creare i tuoi modelli se lo desideri.

Leggi anche: 5 migliori app per nascondere gli indirizzi IP per Android

25. ParseHub

ParseHub è un'eccellente app web crawler in grado di raccogliere informazioni da siti Web che utilizzano AJAX, JavaScript, cookie e altre tecnologie correlate.

- Il suo motore di apprendimento automatico può leggere, valutare e convertire i contenuti online in dati significativi .

- Puoi anche utilizzare l'app Web integrata nel tuo browser.

- È possibile ottenere informazioni da milioni di siti Web.

- ParseHub cercherà automaticamente tra migliaia di link e parole.

- I dati vengono raccolti e archiviati automaticamente sui nostri server.

- I pacchetti mensili partono da $ 149 .

- Come shareware, puoi creare solo cinque progetti pubblici su ParseHub.

- Puoi usarlo per accedere ai menu a discesa, accedere a siti Web, fare clic su mappe e gestire pagine Web utilizzando scorrimento infinito, schede e popup .

- Il client desktop di ParseHub è disponibile per Windows, Mac OS X e Linux .

- È possibile acquisire i dati raschiati in qualsiasi formato per l'analisi.

- Puoi stabilire almeno 20 progetti di scraping privati con livelli di abbonamento premium.

Consigliato:

- Come eliminare l'account DoorDash

- 31 migliori strumenti per il web scraping

- 24 migliori software di digitazione gratuiti per PC

- 15 migliori strumenti di compressione dei file per Windows

Ci auguriamo che questo articolo sia stato utile e che tu abbia scelto il tuo strumento web crawler gratuito preferito. Condividi i tuoi pensieri, domande e suggerimenti nella sezione commenti qui sotto. Inoltre, puoi suggerirci gli strumenti mancanti. Facci sapere cosa vuoi imparare dopo.