25最高の無料のWebクローラーツール

公開: 2022-04-08

SEOランキング、露出、コンバージョンを改善するためのツールをお探しですか? そのためには、Webクローラーツールが必要です。 Webクローラーは、インターネットをスキャンするコンピュータープログラムです。 Webスパイダー、Webデータ抽出ソフトウェア、およびWebスクレイピングプログラムは、インターネットWebクロールテクノロジの例です。 スパイダーボットまたはスパイダーとも呼ばれます。 今日は、ダウンロードできる無料のWebクローラーツールをいくつか見ていきます。

コンテンツ

- 25最高の無料のWebクローラーツール

- 1.検索サーバーを開きます

- 2. Spinn3r

- 3. Import.io

- 4.BUbiNG

- 5. GNU Wget

- 6. Webhose.io

- 7. Norconex

- 8. Dexi.io

- 9.ザイト

- 10. Apache Nutch

- 11. VisualScraper

- 12. WebSphinx

- 13.OutWitハブ

- 14. Scrapy

- 15.モゼンダ

- 16. Cyotek Webcopy

- 17.コモンクロール

- 18.セムラッシュ

- 19. Sitechecker.pro

- 20. Webharvy

- 21. NetSpeak Spider

- 22. UiPath

- 23.ヘリウムスクレーパー

- 24.80レッグ

- 25. ParseHub

25最高の無料のWebクローラーツール

Webクローラーツールは、データマイニングと分析のための豊富な情報を提供します。 その主な目的は、インターネット上のWebページにインデックスを付けることです。 壊れたリンク、重複したコンテンツ、欠落しているページタイトルを検出し、深刻なSEOの問題を特定できます。 オンラインデータをスクレイピングすると、さまざまな方法でビジネスにメリットがもたらされる可能性があります。

- いくつかのWebクローラーアプリは、任意のWebサイトURLからデータを適切にクロールできます。

- これらのプログラムは、検索エンジンがWebサイトを理解してランキングを上げることができるように、Webサイトの構造を改善するのに役立ちます。

トップツールのリストには、Webクローラーツールの無料ダウンロードとその機能およびコストのリストがまとめられています。 このリストには、支払い可能なアプリケーションも含まれています。

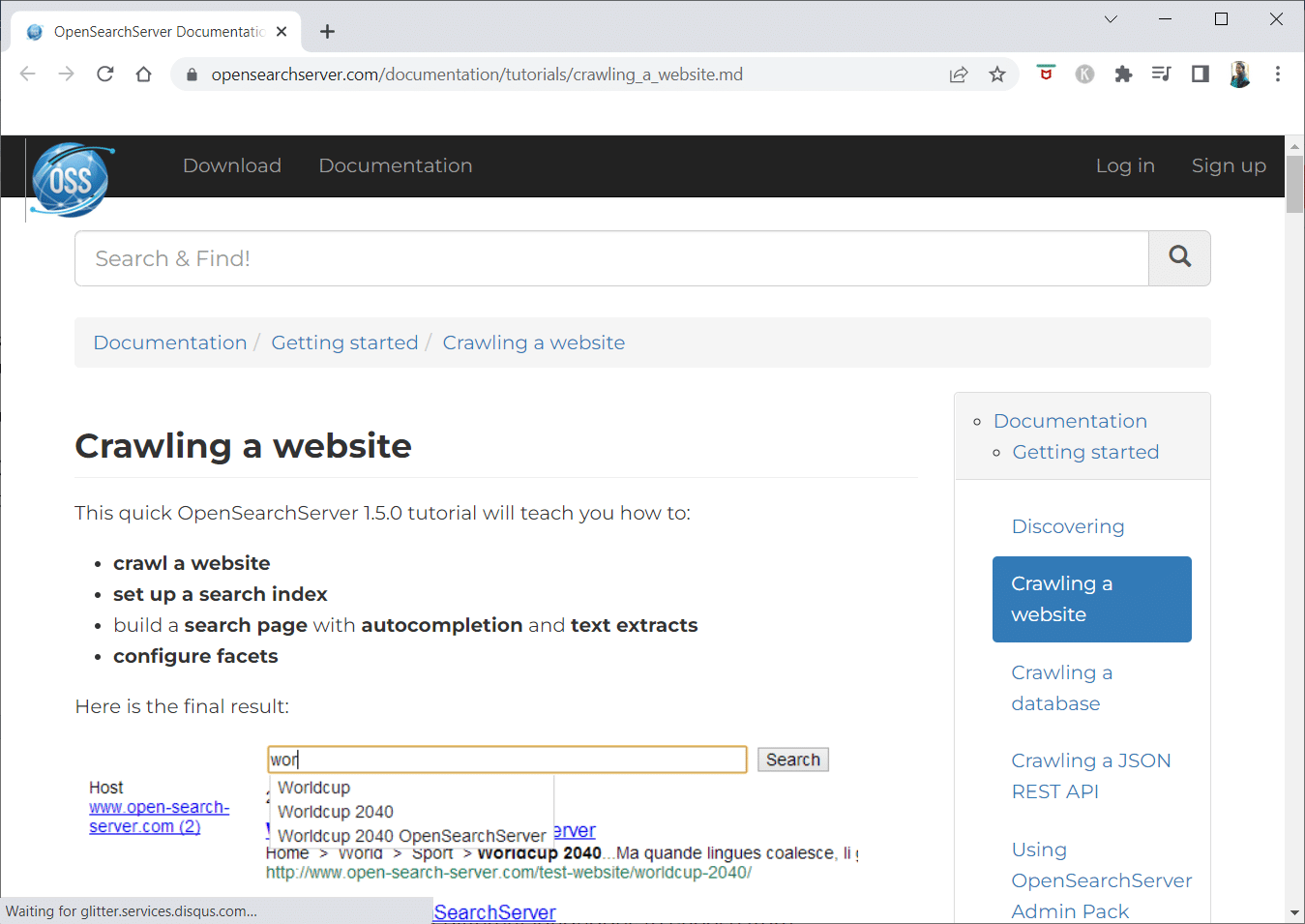

1.検索サーバーを開きます

OpenSearchServerは無料のWebクローラーであり、インターネットで最高の評価の1つです。 利用可能な最良の選択肢の1つ。

- これは完全に統合されたソリューションです。

- Open Search Serverは、無料のオープンソースのWebクロールおよび検索エンジンです。

- これは、ワンストップで費用効果の高いソリューションです。

- 包括的な検索機能のセットと、独自のインデックス作成戦略を構築する可能性が付属しています。

- クローラーは、ほぼすべてのインデックスを作成できます。

- フルテキスト、ブール、および音声検索から選択できます。

- 17の異なる言語から選択できます。

- 自動分類が行われます。

- 頻繁に発生することのタイムテーブルを作成できます。

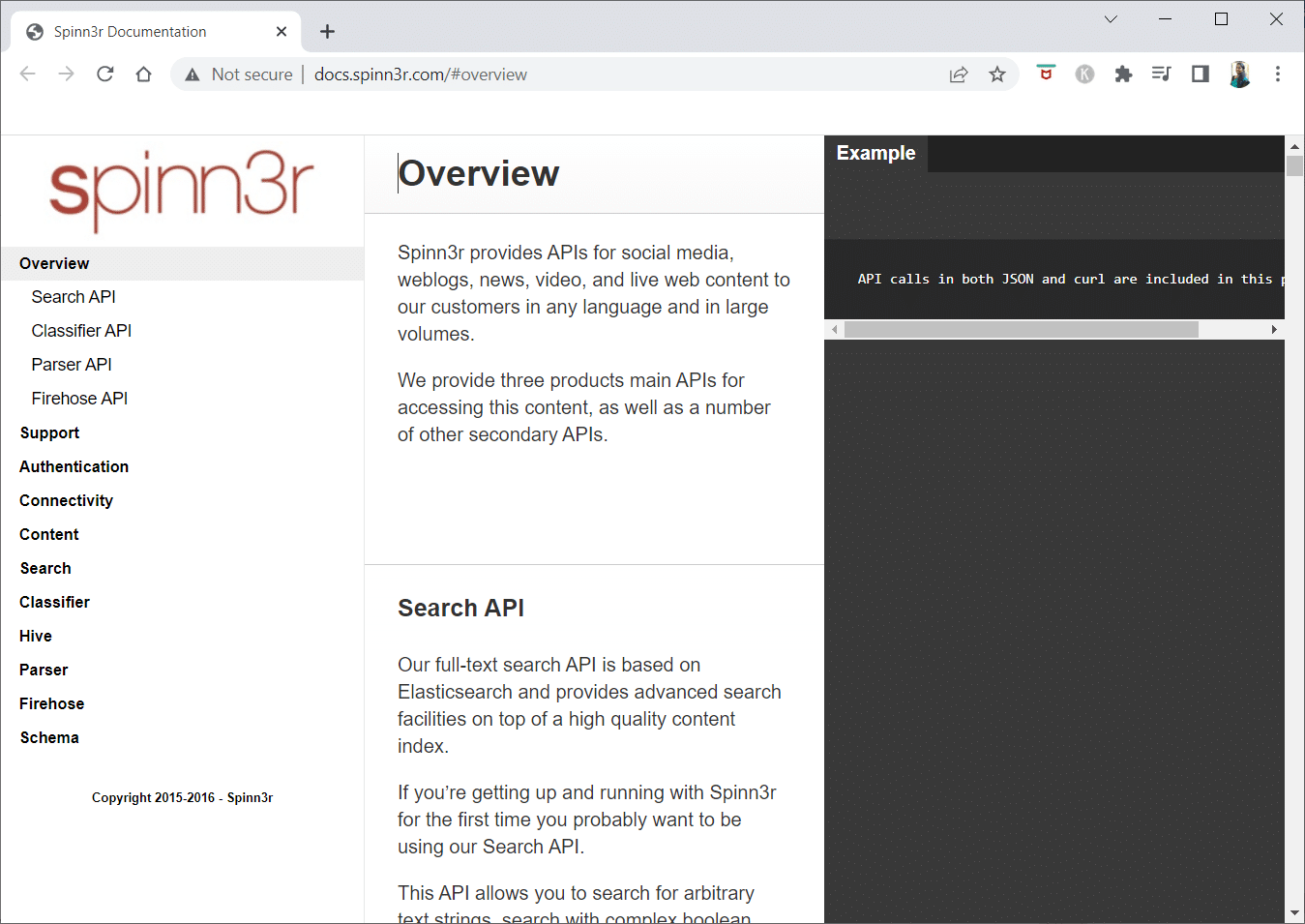

2. Spinn3r

Spinn3r Webクローラープログラムを使用すると、ブログ、ニュース、ソーシャルネットワーキングサイト、RSSフィード、およびATOMフィードからコンテンツを完全に抽出できます。

- インデックス作成作業の95%を処理する超高速APIが付属しています。

- このWebクロールアプリケーションには高度なスパム保護が含まれており、スパムや不適切な言語の使用を排除して、データのセキュリティを向上させます。

- Webスクレイパーは、リアルタイムコンテンツを表示するために、多数のソースからの更新をWebで継続的に検索します。

- Googleと同じ方法でコンテンツにインデックスを付け、抽出されたデータはJSONファイルとして保存されます。

- Parser APIを使用すると、任意のWebURLの情報をすばやく解析および管理できます。

- Firehose APIは、膨大な量のデータに大量にアクセスできるように設計されています。

- 単純なHTTPヘッダーは、Spinn3rのすべてのAPIを認証するために使用されます。

- これは、無料でダウンロードできるWebクローラーツールです。

- Classifier APIを使用すると、開発者は、機械学習テクノロジーによってラベル付けされるテキスト(またはURL)を送信できます。

また読む: UAEでブロックされたサイトにアクセスする方法

3. Import.io

Import.ioを使用すると、数百万のWebページを数分でスクレイピングし、コードを1行も記述せずに、ニーズに基づいて1000以上のAPIを構築できます。

- プログラムで操作できるようになり、データを自動的に取得できるようになりました。

- ボタンのストロークで多くのページからデータを抽出します。

- ページ付けされたリストを自動的に認識するか、次のページをクリックすることができます。

- 数回クリックするだけで、オンラインデータをアプリやウェブサイトに組み込むことができます。

- ページ番号やカテゴリ名などのパターンを使用して、必要なすべてのURLを数秒で作成します。

- Import.ioを使用すると、ページからデータを簡単に取得する方法を示すことができます。 データセットから列を選択し、目を引くページ上の何かをポイントするだけです。

- あなたは彼らのウェブサイトで見積もりを受け取るかもしれません。

- リストページへのリンクは、詳細情報を含む詳細ページにつながります。

- Import.ioを使用してそれらを結合し、詳細ページからすべてのデータを一度に取得できます。

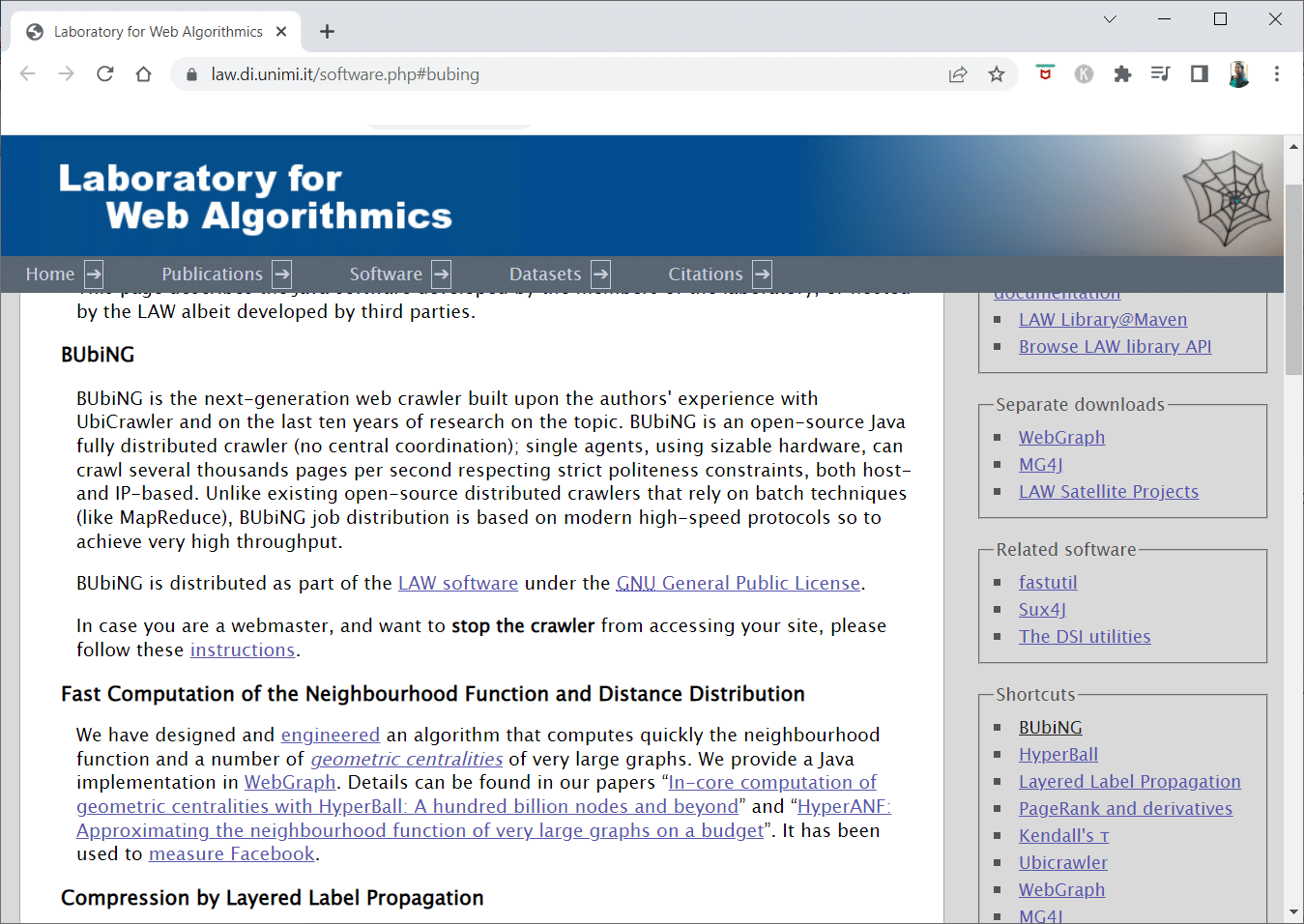

4.BUbiNG

次世代のWebクローラーツールであるBUbiNGは、UbiCrawlerに関する著者の経験と、このトピックに関する10年間の研究の集大成です。

- ホストとIPベースの両方の厳格なポライトネス基準に準拠しながら、1人のエージェントで1秒あたり数千ページをクロールできます。

- そのジョブ分散は、バッチ技術に依存する以前のオープンソース分散クローラーとは異なり、非常に高いスループットを提供するために最新の高速プロトコルに基づいて構築されています。

- ストリップされたページのフィンガープリントを使用して、ほぼ重複しているものを検出します。

- BUbiNGは、完全に分散されたオープンソースのJavaクローラーです。

- それは多くの並列性を持っています。

- この商品を利用している方も多いです。

- 速いです。

- 大規模なクロールが可能になります。

5. GNU Wget

GNU Wgetは、無料でダウンロードできる無料のWebクローラーツールであり、Cで記述されたオープンソースのソフトウェアプログラムであり、HTTP、HTTPS、FTP、およびFTPSを介してファイルを取得できます。

- このアプリケーションの最も特徴的な側面の1つは、さまざまな言語でNLSベースのメッセージファイルを作成する機能です。

- RESTおよびRANGEを使用して、停止されたダウンロードを再開できます。

- また、必要に応じて、ダウンロードしたドキュメントの絶対リンクを相対リンクに変換することもできます。

- ファイル名とミラーディレクトリでワイルドカードを再帰的に使用します。

- さまざまな言語のNLSに基づくメッセージファイル。

- ミラーリング中に、ローカルファイルのタイムスタンプが評価され、ドキュメントを再ダウンロードする必要があるかどうかが判断されます。

また読む: Windows10でファイルまたはフォルダーをコピーするときの不特定のエラーを修正

6. Webhose.io

Webhose.ioは、さまざまなソースにまたがるさまざまなフィルターを使用して、データをスキャンし、複数の言語でキーワードを抽出できる素晴らしいWebクローラーアプリケーションです。

- アーカイブにより、ユーザーは以前のデータを表示することもできます。

- さらに、webhose.ioのクロールデータ検出は最大80の言語で利用できます。

- 侵害されたすべての個人情報は、1か所で見つかる可能性があります。

- サイバー脅威のダークネットとメッセージングアプリケーションを調査します。

- XML、JSON、およびRSS形式は、スクレイピングされたデータにもアクセスできます。

- あなたは彼らのウェブサイトで見積もりを受け取るかもしれません。

- ユーザーは、Webhose.ioで構造化データのインデックスを作成して検索するだけです。

- すべての言語で、メディアのアウトレットを監視および分析できます。

- 掲示板やフォーラムでの議論をフォローすることが可能です。

- これにより、Web全体からの主要なブログ投稿を追跡できます。

7. Norconex

Norconexは、オープンソースのWebクローラーアプリを探している企業にとって優れたリソースです。

- このフル機能のコレクターは、使用することも、プログラムに統合することもできます。

- また、ページの注目画像を取得する場合もあります。

- Norconexを使用すると、任意のWebサイトのコンテンツをクロールできます。

- 任意のオペレーティングシステムを利用することが可能です。

- このWebクローラーソフトウェアは、単一の平均容量サーバー上で数百万のページをクロールできます。

- また、コンテンツとメタデータを変更するための一連のツールも含まれています。

- 現在作業中のドキュメントのメタデータを取得します。

- JavaScriptでレンダリングされたページがサポートされています。

- 複数の言語の検出を可能にします。

- 翻訳支援が可能になります。

- クロールの速度が変更される場合があります。

- 変更または削除されたドキュメントが識別されます。

- これは完全に無料のWebクローラープログラムです。

8. Dexi.io

Dexi.ioは、任意のWebサイトから情報を取得できるブラウザーベースのWebクローラーアプリです。

- 抽出装置、クローラー、およびパイプは、スクレイピング操作を行うために使用できる3種類のロボットです。

- 市場の発展は、デルタレポートを使用して予測されます。

- 収集したデータは、アーカイブする前にDexi.ioのサーバーに2週間保存されます。または、抽出したデータをJSONまたはCSVファイルとしてすぐにエクスポートすることもできます。

- あなたは彼らのウェブサイトで見積もりを受け取るかもしれません。

- 品質保証や継続的なメンテナンスなどの専門的なサービスが提供されています。

- リアルタイムのデータニーズを満たすのに役立つ商用サービスを提供します。

- 無制限の数のSKU/製品の在庫と価格を追跡することが可能です。

- ライブダッシュボードと完全な製品分析を使用してデータを統合できます。

- これは、Webベースの整理されたすぐに使用できる製品データを準備およびすすぐのに役立ちます。

また読む: AndroidからPCにファイルを転送する方法

9.ザイト

Zyteはクラウドベースのデータ抽出ツールであり、何万人もの開発者が重要な情報を見つけるのを支援します。 また、最高の無料のWebクローラーアプリの1つです。

- ユーザーは、コーディングを知らなくても、オープンソースのビジュアルスクレイピングアプリケーションを使用してWebページをスクレイピングできます。

- Zyteが使用する複雑なプロキシローテーターであるCrawleraを使用すると、ユーザーはボットの対抗策を回避しながら、大規模なサイトやボットで保護されたサイトを簡単にクロールできます。

- あなたのオンライン情報はスケジュール通りに一貫して配信されます。 したがって、プロキシを管理する代わりに、データの取得に集中できます。

- スマートなブラウザ機能とレンダリングにより、ブラウザ層をターゲットとするアンチボットを簡単に管理できるようになりました。

- 彼らのウェブサイトで、あなたは見積もりを得るかもしれません。

- ユーザーは、単純なHTTP APIを使用して多数のIPおよびリージョンからクロールできるため、プロキシのメンテナンスが不要になります。

- 必要な情報を取得することで時間を節約しながら、現金を生み出すのに役立ちます。

- これにより、コーディングとスパイダーのメンテナンスにかかる時間を節約しながら、Webデータを大規模に抽出できます。

10. Apache Nutch

Apache Nutchは、間違いなく、最高のオープンソースWebクローラーアプリのリストのトップにあります。

- 1台のマシンで動作します。 ただし、Hadoopクラスターで最高のパフォーマンスを発揮します。

- 認証には、 NTLMプロトコルが採用されています。

- 分散ファイルシステム(Hadoop経由)があります。

- これは、データマイニングに適応可能でスケーラブルな、有名なオープンソースのオンラインデータ抽出ソフトウェアプロジェクトです。

- 多くのデータアナリスト、科学者、アプリケーション開発者、および世界中のWebテキストマイニングスペシャリストがこれを使用しています。

- これは、 Javaベースのクロスプラットフォームソリューションです。

- デフォルトでは、フェッチと解析は独立して実行されます。

- データは、 XPathと名前空間を使用してマップされます。

- リンクグラフデータベースが含まれています。

11. VisualScraper

VisualScraperは、インターネットからデータを抽出するためのもう1つの素晴らしい非コーディングWebスクレイパーです。

- シンプルなポイントアンドクリックのユーザーインターフェイスを提供します。

- また、データ配布やソフトウェア抽出機能の構築などのオンラインスクレイピングサービスも提供しています。

- 競合他社にも目を光らせています。

- ユーザーは、プロジェクトを特定の時間に実行するようにスケジュールしたり、Visual Scraperを使用して、分、日、週、月、年ごとにシーケンスを繰り返すことができます。

- それはより安価でより効果的です。

- 話すコードすらありません。

- これは完全に無料のWebクローラープログラムです。

- リアルタイムデータは、複数のWebページから抽出され、 CSV、XML、JSON、またはSQLファイルとして保存される場合があります。

- ユーザーはこれを使用して、ニュース、更新、およびフォーラムの投稿を定期的に抽出できます。

- データは100%正確で、カスタマイズされています。

また読む:中小企業のための15の最高の無料の電子メールプロバイダー

12. WebSphinx

WebSphinxは、セットアップと使用が簡単な、すばらしい個人用の無料Webクローラーアプリです。

- これは、インターネットの限られた部分を自動的にスキャンしたい高度なWebユーザーおよびJavaプログラマー向けに設計されています。

- このオンラインデータ抽出ソリューションには、Javaクラスライブラリとインタラクティブプログラミング環境が含まれています。

- ページを連結して、閲覧または印刷できる単一のドキュメントを作成できます。

- 一連のページから、特定のパターンに適合するすべてのテキストを抽出します。

- このパッケージのおかげで、WebクローラーをJavaで記述できるようになりました。

- CrawlerWorkbenchとWebSPHINXクラスライブラリはどちらもWebSphinxに含まれています。

- Crawler Workbenchは、Webクローラーをカスタマイズおよび操作できるグラフィカルユーザーインターフェイスです。

- グラフは、Webページのグループから作成できます。

- オフラインで読むために、ページをローカルドライブに保存します。

13.OutWitハブ

OutWit Hubプラットフォームは、データ認識および抽出機能の広範なライブラリを備えたカーネルで構成されており、それぞれがカーネルの機能を利用して、無限の数の異なるアプリを作成できます。

- このWebクローラーアプリケーションは、サイトをスキャンして、検出したデータをアクセス可能な方法で保存できます。

- さまざまな要件に対応するために、可能な限り多くの機能を備えた多目的ハーベスターです。

- ハブは長い間存在してきました。

- これは、コーディング方法を知っているが、PHPがデータを抽出するための理想的なオプションであるとは限らないことを認識している、技術者以外のユーザーやITプロフェッショナルにとって便利で多様なプラットフォームに進化しました。

- OutWit Hubは、要求に応じて、適度な量または大量のデータをスクレイピングするための単一のインターフェイスを提供します。

- これにより、ブラウザから直接Webページをスクレイプし、データを取得して要件に応じて準備する自動エージェントを構築できます。

- あなたは彼らのウェブサイトで見積もりを受け取るかもしれません。

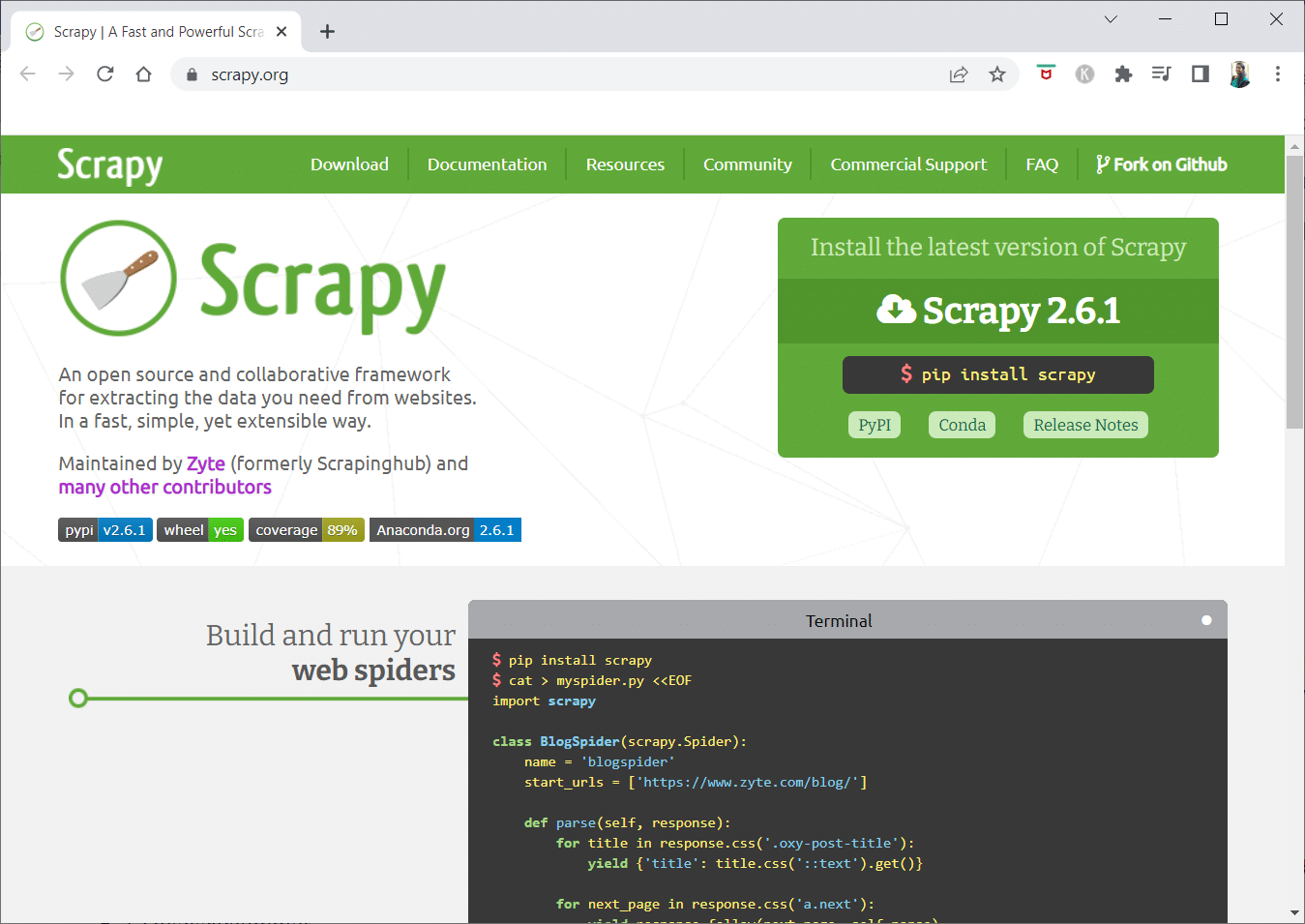

14. Scrapy

Scrapyは、スケーラブルなWebクローラーを構築するためのPythonオンラインスクレイピングフレームワークです。

- これは、プロキシミドルウェアや質問のクエリなど、Webクローラーの作成を困難にするすべての特性を処理する完全なWebクロールフレームワークです。

- データを抽出するためのルールを記述して、残りをScrapyに処理させることができます。

- そのように設計されているため、コアを変更せずに新しい機能を簡単に追加できます。

- これは、 Linux、Windows、Mac OS X、およびBSDシステムで動作するPythonベースのプログラムです。

- これは完全に無料のユーティリティです。

- そのライブラリは、Webクローラーをカスタマイズし、Webから大規模にデータを抽出するためのすぐに使用できる構造をプログラマーに提供します。

また読む: 9最高の無料データ回復ソフトウェア(2022)

15.モゼンダ

Mozendaは、最高の無料Webクローラーアプリでもあります。 これは、ビジネス指向のクラウドベースのセルフサービスWebスクレイピングプログラムです。 Mozendaには70億ページ以上のスクレイピングがあり、世界中に企業顧客がいます。

- MozendaのWebスクレイピング技術により、スクリプトの必要性とエンジニアの雇用がなくなります。

- データ収集を5倍高速化します。

- Mozendaのポイントアンドクリック機能を使用して、Webサイトからテキスト、ファイル、画像、およびPDF情報を取得できます。

- データファイルを整理することで、公開の準備をすることができます。

- MozedaのAPIを使用して、TSV、CSV、XML、XLSX、またはJSONに直接エクスポートできます。

- Mozendaの洗練されたデータラングリングを使用して情報を整理し、重要な決定を下すことができます。

- Mozendaのパートナーのプラットフォームの1つを使用して、データを統合したり、いくつかのプラットフォームでカスタムデータ統合を確立したりできます。

16. Cyotek Webcopy

Cyotek Webcopyは、Webサイトのコンテンツをローカルデバイスに自動的にダウンロードできる無料のWebクローラーツールです。

- 選択したWebサイトのコンテンツがスキャンされ、ダウンロードされます。

- Webサイトのどの部分を複製するか、およびその複雑な構造をどのように使用するかを選択できます。

- 新しいローカルルートは、スタイルシート、写真、その他のページなどのWebサイトリソースへのリンクをリダイレクトします。

- WebサイトのHTMLマークアップを調べて、他のWebサイト、写真、ビデオ、ファイルのダウンロードなど、接続されているリソースを見つけようとします。

- Webサイトをクロールし、表示されたものをすべてダウンロードして、元のコピーを作成する場合があります。

17.コモンクロール

Common Crawlは、有用な洞察を得るためにデータを調査および分析することに関心のある人を対象としています。

- これは501(c)(3)の非営利団体であり、運営を適切に運営するために寄付に依存しています。

- Common Crawlを利用したい人は誰でも、お金をかけたり問題を引き起こしたりすることなく利用できます。

- Common Crawlは、教育、調査、分析に使用できるコーパスです。

- コモンクロールのデータを利用して他の人が行った驚くべき発見について学ぶための技術的なスキルがない場合は、記事を読む必要があります。

- 教師はこれらのツールを使用してデータ分析を教えることができます。

また読む:あるGoogleドライブから別のGoogleドライブにファイルを移動する方法

18.セムラッシュ

Semrushは、技術的なSEOの問題についてWebサイトのページと構造を調べるWebサイトクローラーアプリです。 これらの問題を修正すると、検索結果を向上させるのに役立ちます。

- SEO、市場調査、ソーシャルメディアマーケティング、広告のためのツールがあります。

- ユーザーフレンドリーなUIを備えています。

- メタデータ、HTTP / HTTPS、ディレクティブ、ステータスコード、重複コンテンツ、ページ応答速度、内部リンク、画像サイズ、構造化データ、およびその他の要素が調べられます。

- それはあなたがあなたのウェブサイトを速くそして簡単に監査することを可能にします。

- ログファイルの分析に役立ちます。

- このプログラムは、Webサイトの問題を簡単に表示できるダッシュボードを提供します。

19. Sitechecker.pro

Sitechecker.proは、もう1つの最高の無料Webクローラーアプリです。 それはあなたがあなたのSEOランキングを高めるのを助けるウェブサイトのためのSEOチェッカーです。

- Webページの構造を簡単に視覚化できます。

- クライアントが電子メールで受け取る可能性のあるページ上のSEO監査レポートを作成します。

- このWebクローラーツールは、 Webサイトの内部リンクと外部リンクを確認できます。

- それはあなたのウェブサイトの速度を決定するのに役立ちます。

- Sitechecker.proを使用して、ランディングページのインデックス作成の問題を確認することもできます。

- ハッカーの攻撃から身を守るのに役立ちます。

20. Webharvy

Webharvyは、シンプルなポイントアンドクリックインターフェイスを備えたWebスクレイピングツールです。 コーディング方法がわからない人のために設計されています。

- ライセンスの費用は139ドルからです。

- WebHarvyの組み込みブラウザを使用してオンラインサイトをロードし、マウスクリックを使用してスクレイプするデータを選択します。

- Webサイトからテキスト、写真、URL、および電子メールを自動的にスクレイピングし、さまざまな形式で保存できます。

- プロキシサーバーまたはVPNを使用して、ターゲットWebサイトにアクセスできます。

- データをスクレイピングするために、プログラミングやアプリを作成する必要はありません。

- プロキシサーバーまたはVPNを使用してターゲットWebサイトにアクセスすることにより、匿名でスクレイピングし、WebサーバーによってWebスクレイピングソフトウェアが禁止されるのを防ぐことができます。

- WebHarvyは、Webサイトのデータパターンを自動的に識別します。

- Webページからオブジェクトのリストを取得する必要がある場合は、他に何もする必要はありません。

また読む: Windows10用のトップ8無料ファイルマネージャーソフトウェア

21. NetSpeak Spider

NetSpeak Spiderは、毎日のSEO監査、問題の迅速な特定、体系的な分析の実施、およびWebページのスクレイピングのためのデスクトップWebクローラーアプリです。

- このWebクロールアプリケーションは、RAMの使用を最小限に抑えながら、大きなWebページの評価に優れています。

- CSVファイルは、Webクロールデータから簡単にインポートおよびエクスポートできます。

- 数回クリックするだけで、これらの、そして何百もの他のウェブサイトのSEOの深刻な懸念を特定することができます。

- このツールは、ステータスコード、クロールとインデックス作成の手順、Webサイトの構造、リダイレクトなど、Webサイトのページ上の最適化を評価するのに役立ちます。

- GoogleAnalyticsおよびYandexからのデータがエクスポートされる場合があります。

- ウェブサイトのページ、トラフィック、コンバージョン、ターゲット、さらにはEコマース設定についても、データ範囲、デバイスの種類、セグメンテーションを考慮に入れてください。

- その月額サブスクリプションは21ドルから始まります。

- 壊れたリンクと写真はSEOクローラーによって検出され、ページ、テキスト、重複したタイトルとメタ説明タグ、H1などの重複した素材も検出されます。

22. UiPath

UiPathは、ロボットによる手順を自動化できるWebクローラーのオンラインスクレイピングツールです。 ほとんどのサードパーティプログラムのオンラインおよびデスクトップデータクロールを自動化します。

- ロボットプロセス自動化アプリケーションをWindowsにインストールできます。

- 多くのWebページから表形式およびパターンベースの形式でデータを抽出できます。

- UiPathは、箱から出してすぐに追加のクロールを実行できます。

- レポートはロボットを追跡するため、いつでもドキュメントを参照できます。

- あなたがあなたの慣行を標準化するならば、あなたの結果はより効率的で成功するでしょう。

- 月額サブスクリプションは$420から始まります。

- マーケットプレイスの200を超える既製のコンポーネントは、チームにより短い時間でより多くの時間を提供します。

- UiPathロボットは、ニーズに合った正確な方法に従うことでコンプライアンスを向上させます。

- 企業は、プロセスを最適化し、経済を認識し、洞察を提供することにより、低コストで迅速なデジタルトランスフォーメーションを実現できます。

また読む:デバッガーで検出されたエラーを修正する方法

23.ヘリウムスクレーパー

Helium Scraperは、要素間にほとんど関連性がない場合に最適に機能する視覚的なオンラインデータWebクロールアプリケーションです。 基本的なレベルでは、ユーザーのクロール要件を満たすことができます。

- コーディングや設定は必要ありません。

- 明確で簡単なユーザーインターフェイスにより、指定したリストからアクティビティを選択して追加できます。

- 特殊なクロール要件に対応するオンラインテンプレートも利用できます。

- 画面外では、いくつかのChromiumWebブラウザが使用されます。

- 可能な限り多くのデータを取得するには、同時ブラウザの数を増やしてください。

- 独自のアクションを定義するか、より複雑なインスタンスにカスタムJavaScriptを利用します。

- パソコンまたは専用のWindowsサーバーにインストールできます。

- そのライセンスは99ドルから始まり、そこから上昇します。

24.80レッグ

2009年に、オンラインデータをよりアクセスしやすくするために80Legsが設立されました。 これは、最高の無料Webクローラーツールの1つです。 当初、同社はさまざまなクライアントにWebクロールサービスを提供することに重点を置いていました。

- 当社の広範なWebクローラーアプリは、パーソナライズされた情報を提供します。

- クロール速度は、Webサイトのトラフィックに基づいて自動的に調整されます。

- 調査結果は、80legsを介してローカル環境またはコンピューターにダウンロードできます。

- URLを入力するだけで、Webサイトをクロールできます。

- その月額サブスクリプションは月額$29から始まります。

- SaaSを介して、Webクロールを構築および実行することができます。

- さまざまなIPアドレスからサイトを表示できるサーバーが多数あります。

- Webを精査する代わりに、サイトデータに即座にアクセスできます。

- カスタマイズされたWebクロールの構築と実行を容易にします。

- このアプリケーションを使用して、オンラインの傾向を追跡できます。

- 必要に応じて、テンプレートを作成できます。

また読む: Android用の5つの最高のIPアドレスハイダーアプリ

25. ParseHub

ParseHubは、AJAX、JavaScript、Cookie、およびその他の関連テクノロジーを使用するWebサイトから情報を収集できる優れたWebクローラーアプリです。

- その機械学習エンジンは、オンラインコンテンツを読み取り、評価し、意味のあるデータに変換できます。

- ブラウザに組み込まれているWebアプリを利用することもできます。

- 何百万ものウェブサイトから情報を入手することは可能です。

- ParseHubは、何千ものリンクや単語を自動的に検索します。

- データは自動的に収集され、サーバーに保存されます。

- 月額パッケージは149ドルから。

- シェアウェアとして、ParseHubで構築できるパブリックプロジェクトは5つだけです。

- ドロップダウンメニューへのアクセス、Webサイトへのログオン、マップのクリック、および無限のスクロール、タブ、ポップアップを使用したWebページの管理に使用できます。

- ParseHubのデスクトップクライアントは、 Windows、Mac OS X、およびLinuxで使用できます。

- スクレイピングされたデータは、分析のために任意の形式で取得できます。

- プレミアムメンバーシップレベルで少なくとも20のプライベートスクレイピングプロジェクトを確立できます。

おすすめされた:

- DoorDashアカウントを削除する方法

- 31最高のWebスクレイピングツール

- PC用の24の最高の無料タイピングソフトウェア

- Windows用の15の最高のファイル圧縮ツール

この記事がお役に立てば幸いです。お気に入りの無料のWebクローラーツールを選択してください。 以下のコメントセクションであなたの考え、質問、提案を共有してください。 また、不足しているツールを提案することもできます。 次に何を学びたいか教えてください。