So erkennen Sie, ob ein Artikel von ChatGPT geschrieben wurde

Veröffentlicht: 2023-05-14

Die KI-Technologie verändert, was wir online sehen und wie wir mit der Welt interagieren. Von einem Midjourney-Foto des Papstes im Daunenmantel bis hin zu Sprachlernmodellen wie ChatGPT dringt künstliche Intelligenz in unser Leben ein.

Die unheilvolleren Einsatzmöglichkeiten von KI-Technologie, etwa eine politische Desinformationskampagne, die gefälschte Artikel verbreitet, bedeuten, dass wir uns ausreichend weiterbilden müssen, um die Fälschungen zu erkennen. Wie können Sie also feststellen, ob es sich bei einem Artikel tatsächlich um KI-generierten Text handelt?

So erkennen Sie, ob ChatGPT diesen Artikel geschrieben hat

Derzeit gibt es mehrere Methoden und Tools, um festzustellen, ob der Artikel, den Sie gerade lesen, von einem Roboter geschrieben wurde. Nicht alle von ihnen sind 100 % zuverlässig und können falsch positive Ergebnisse liefern, aber sie bieten einen Ausgangspunkt.

Ein wichtiges Merkmal von von Menschen geschriebenen Texten ist, zumindest im Moment, die Zufälligkeit. Während Menschen in unterschiedlichen Stilen und in unterschiedlichem Slang schreiben und oft Tippfehler machen, machen KI-Sprachmodelle solche Fehler nur sehr selten. Laut MIT Technology Review ist „von Menschen geschriebener Text voller Tippfehler und unglaublich variabel“, während KI-generierte Textmodelle wie ChatGPT viel besser darin sind, text ohne Tippfehler zu erstellen. Ein gutes Lektorat hat natürlich den gleichen Effekt, Sie müssen also nicht nur auf die korrekte Rechtschreibung achten.

Ein weiterer Indikator sind Satzzeichenmuster. Menschen verwenden Satzzeichen zufälliger als ein KI-Modell. KI-generierter Text enthält in der Regel auch mehr Verbindungswörter wie „das“, „es“ oder „ist“ anstelle größerer, seltener verwendeter Wörter, da große Sprachmodelle nicht darauf basieren, vorherzusagen, welches Wort am wahrscheinlichsten als nächstes kommt etwas, das so gut klingen würde, wie es ein Mensch tun könnte.

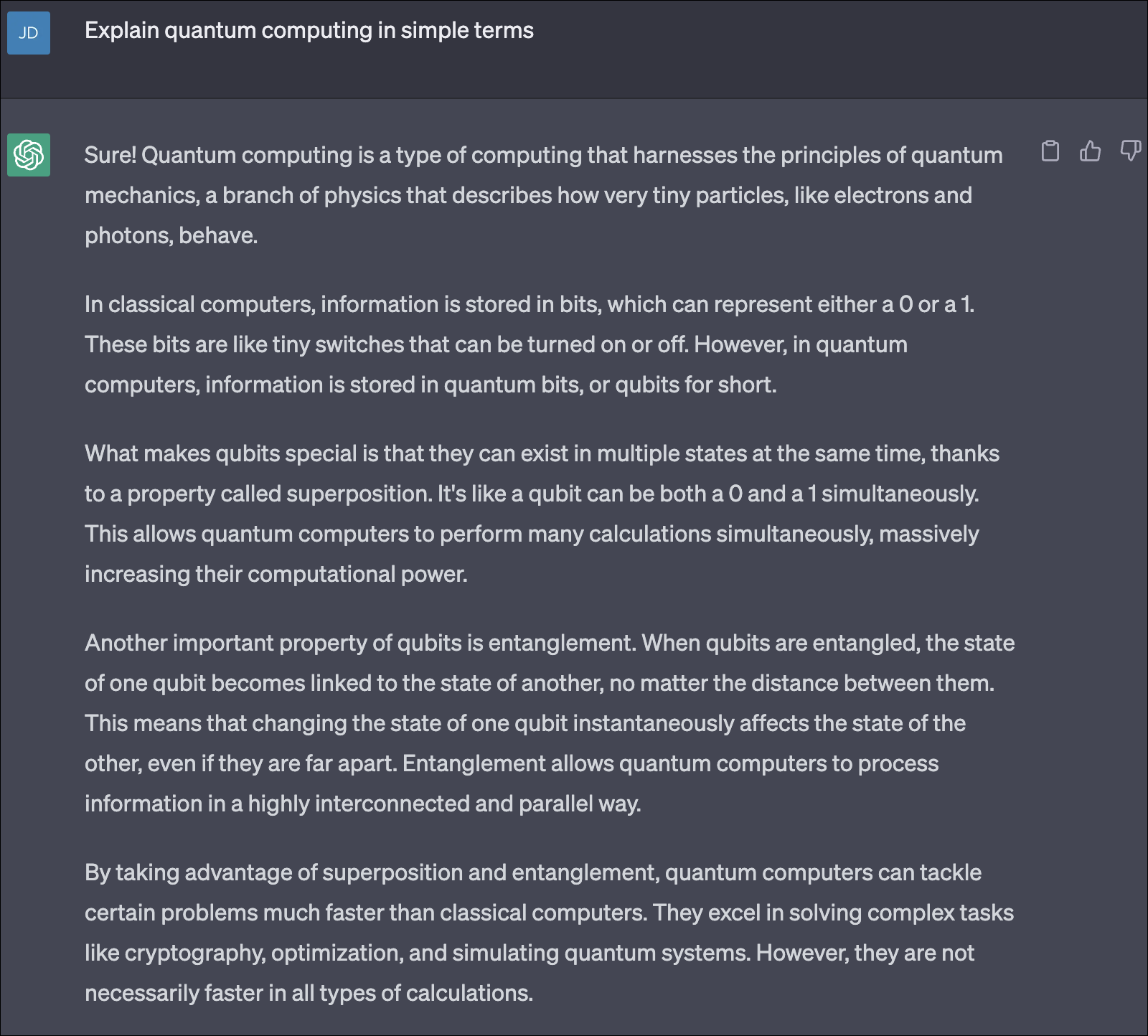

Dies geht aus der Antwort von ChatGPT auf eine der Standardfragen auf der Website von OpenAI hervor. Auf die Frage „Können Sie Quantencomputing in einfachen Worten erklären?“ erhalten Sie Sätze wie: „Das Besondere an Qubits ist, dass sie dank einer Eigenschaft namens Superposition in mehreren Zuständen gleichzeitig existieren können.“ Es ist, als ob ein Qubit gleichzeitig eine 0 und eine 1 sein kann. ”

Regelmäßig werden kurze, einfache Verbindungswörter verwendet, die Sätze sind alle gleich lang und die Absätze haben alle einen ähnlichen Aufbau. Das Endergebnis ist ein Schreiben, das ein wenig roboterhaft klingt und sich auch so anfühlt.

Können Sie KI verwenden, um KI-generierten Text zu erkennen?

Große Sprachmodelle selbst können darauf trainiert werden, KI-generiertes Schreiben zu erkennen. Wenn Sie das System auf zwei Sätze von Texten trainieren – einen von KI und einen von Menschen geschriebenen –, kann das Modell theoretisch lernen, KI-Schriftarten wie ChatGPT zu erkennen und zu erkennen.

Forscher arbeiten auch an Wasserzeichenmethoden zur Erkennung von KI-Artikeln und -Texten. Tom Goldstein, der Informatik an der University of Maryland lehrt, arbeitet an einer Möglichkeit, Wasserzeichen in KI-Sprachmodelle einzubauen, in der Hoffnung, dass damit maschinengenerierte Schrift erkannt werden kann, selbst wenn sie gut genug ist, um menschliche Zufälligkeiten nachzuahmen.

Für das bloße Auge unsichtbar, wäre das Wasserzeichen durch einen Algorithmus erkennbar, der es entweder als von Menschen oder von KI erzeugt angibt, je nachdem, wie oft es sich an die Wasserzeichenregeln hielt oder gegen diese verstieß. Leider wurde diese Methode bei späteren Modellen von ChatGPT nicht so gut getestet.

Tools zum Überprüfen, ob ein Artikel von ChatGPT geschrieben wurde

Im Internet finden Sie mehrere Tools zum Kopieren und Einfügen, mit denen Sie überprüfen können, ob ein Artikel KI-generiert ist. Viele von ihnen verwenden Sprachmodelle zum Scannen des Textes, darunter auch ChatGPT-4 selbst.

Nicht nachweisbare KI vermarktet sich beispielsweise als Werkzeug, um Ihre KI-Schrift von der eines Menschen nicht mehr zu unterscheiden. Kopieren Sie den Text und fügen Sie ihn in sein Fenster ein, und das Programm vergleicht ihn mit den Ergebnissen anderer KI-Erkennungstools wie GPTZero, um ihm einen Wahrscheinlichkeitswert zuzuweisen – es prüft im Grunde, ob acht andere KI-Detektoren denken würden, dass Ihr Text von einem Roboter geschrieben wurde.

Originalität ist ein weiteres Tool, das sich an große Verlage und Inhaltsproduzenten richtet. Es behauptet, genauer zu sein als andere auf dem Markt und nutzt ChatGPT-4, um von KI geschriebenen Text zu erkennen. Weitere beliebte Prüftools sind:

- GPTZero

- Copyleaks

- Schriftsteller

Die meisten dieser Tools geben Ihnen einen Prozentwert an, beispielsweise 96 % von Menschen und 4 % von KI, um zu bestimmen, wie wahrscheinlich es ist, dass der Text von einem Menschen geschrieben wurde. Wenn die Punktzahl 40–50 % KI oder mehr beträgt, ist es wahrscheinlich, dass das Stück KI-generiert wurde.

Während Entwickler daran arbeiten, diese Tools bei der Erkennung von KI-generiertem Text zu verbessern, ist keines davon absolut genau und kann menschliche Inhalte fälschlicherweise als KI-generierten Text kennzeichnen. Es besteht auch die Sorge, dass Erkennungsmodelle ständig aufholen, da sich große Sprachmodelle wie GPT-4 so schnell verbessern.

Trainieren Sie Ihr Gehirn, um KI zu fangen

Zusätzlich zur Verwendung von Tools können Sie sich darin üben, KI-generierte Inhalte zu erfassen. Es braucht Übung, aber mit der Zeit kann man darin besser werden.

Daphne Ippolito, eine leitende Wissenschaftlerin in der KI-Abteilung von Google, Google Brain, hat ein Spiel namens Real Or Fake Text (ROFT) entwickelt, das Ihnen helfen kann, menschliche Sätze von Robotersätzen zu unterscheiden, indem es Sie nach und nach trainiert, zu bemerken, wenn ein Satz nicht ganz richtig aussieht .

Laut Ippolito sind unsinnige Aussagen wie „Es dauert zwei Stunden, eine Tasse Kaffee zuzubereiten“ ein häufiges Merkmal von KI-Texten. Ippolitos Spiel konzentriert sich hauptsächlich darauf, Menschen dabei zu helfen, diese Art von Fehlern zu erkennen. Tatsächlich gab es mehrere Fälle, in denen ein KI-Schreibprogramm ungenaue Fakten mit absoluter Sicherheit wiedergab – Sie sollten es wahrscheinlich auch nicht damit beauftragen, Ihre Mathematikaufgabe zu erledigen, da es mit numerischen Berechnungen offenbar nicht besonders gut zurechtkommt.

Im Moment sind dies die besten Erkennungsmethoden, die uns zur Verfügung stehen, um von einem KI-Programm geschriebenen Text zu erkennen. Sprachmodelle werden mit einer Geschwindigkeit besser, die aktuelle Erkennungsmethoden ziemlich schnell überholt macht, was uns jedoch, wie Melissa Heikkila für MIT Technology Review schreibt, in ein Wettrüsten verwickelt.

VERWANDT: So überprüfen Sie ChatGPT mit Bing AI Chat